通过自然语言处理理解文本

介绍

在自然语言处理和文本分析的领域中,理解和表示人类叙事的丰富而复杂的结构是一个持续挑战。在研究人员和数据科学家可用的众多工具和技术中,“Word Story Embeddings”是一种创新和有希望的方法。这些嵌入建立在词嵌入的基础上,更深入地探索叙事的核心,寻求揭示不仅是语义关系,而且是赋予词语以生命的细微差别和情感。在本文中,我们将探讨文字故事嵌入的概念、它们的重要性以及已经开始塑造自然语言处理领域的潜在应用。

词嵌入:基础概念

作为基础概念,词向量嵌入已经在自然语言处理领域引起了革命。这些嵌入将单词表示为连续空间中的数值向量,捕捉到单词之间的语义关系和相似性。像Word2Vec、GloVe和FastText等技术因其将单词转化为有意义的向量,能够用于情感分析、机器翻译和文档聚类等各种自然语言处理任务而广受欢迎。

演变:文字故事嵌入

文字故事嵌入将这一概念延伸到叙述和故事领域。它们不仅仅是把单词置于孤立地处理,而是承认了文本中上下文、连贯性和情感共鸣的重要性。通过嵌入不仅仅是单个单词,还有短语、句子,甚至是整个叙述,文字故事嵌入提供了对文本更全面的理解。这种方法超越了语义,深入到故事常常编织的复杂情感旅程中。

重要性和应用

1. 情感分析:文字故事嵌入通过考虑叙述中的情感轨迹,使情感分析更加准确。它们可以检测到文本中情感的微妙变化,从而更深刻地理解作者的意图。

2. 故事生成:文字故事嵌入为更富有情感共鸣的故事生成打开了大门。它们可以用于创建引人入胜、深入引起读者共鸣的叙事。

3. 内容推荐:在内容推荐系统领域,文字故事嵌入可以将用户偏好与引起类似情感和主题共鸣的叙事进行匹配,从而提升用户体验。

4. 教育见解:在教育领域,文字故事嵌入可以为教师提供工具,分析和改进学生对复杂叙述的理解,帮助他们理解情感和叙事弧线。

挑战和未来方向

尽管文字故事嵌入具有巨大潜力,但也面临着挑战。叙述的微妙和上下文相关性的特性使得开发普适的嵌入变得具有挑战性。研究人员需要解决情感偏见、文化差异和叙事特定的特征等问题。

文字故事嵌入的未来在于优化技术,捕捉更微妙的情感细微差别和特定上下文信息。这将需要语言学家、心理学家和计算机科学家之间的跨学科合作。此外,开发涵盖不同叙事类型和情感的全面数据集将至关重要。

代码

创建文字故事嵌入通常涉及多个步骤,包括对文本进行预处理、训练模型和可视化嵌入。这里提供了一个完整的Python代码示例,包括一个简单的数据集和图表,以帮助你入门。

import pandas as pd

import numpy as np

import gensim

import matplotlib.pyplot as plt

# Sample dataset with short stories

data = {

'Story': [

'Once upon a time, in a land far, far away, there lived a brave knight.',

'The sun set behind the mountains, casting long shadows on the valley below.',

'It was a dark and stormy night, and the old mansion stood eerie and foreboding.',

'She walked through the city streets, lost in thought and memories of better days.'

]

}

# Create a DataFrame

df = pd.DataFrame(data)

# Preprocessing the text data

import nltk

from nltk.tokenize import word_tokenize

from nltk.corpus import stopwords

from nltk.stem import PorterStemmer

nltk.download('punkt')

nltk.download('stopwords')

def preprocess_text(text):

# Tokenization

tokens = word_tokenize(text.lower())

# Removing stopwords and punctuation

tokens = [word for word in tokens if word.isalnum() and word not in stopwords.words('english')]

# Stemming

stemmer = PorterStemmer()

tokens = [stemmer.stem(word) for word in tokens]

return tokens

df['Preprocessed'] = df['Story'].apply(preprocess_text)

# Train Word2Vec model

model = gensim.models.Word2Vec(df['Preprocessed'], vector_size=100, window=5, min_count=1, sg=0)

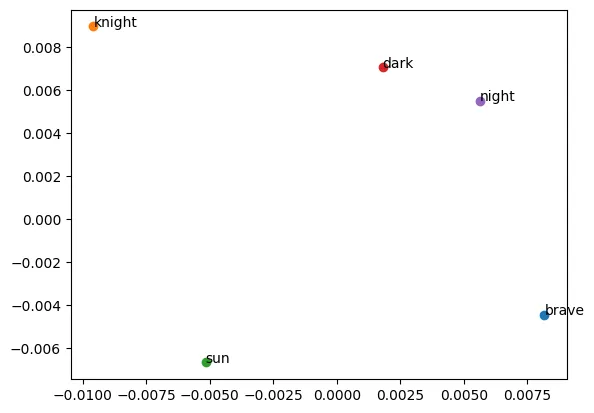

# Visualize Word Embeddings

def plot_word_embeddings(word_embeddings, words_to_plot):

for word in words_to_plot:

if word in word_embeddings:

embedding = word_embeddings[word]

plt.scatter(embedding[0], embedding[1])

plt.annotate(word, (embedding[0], embedding[1]))

words_to_plot = ['brave', 'knight', 'sun', 'dark', 'night']

word_embeddings = {word: model.wv[word] for word in words_to_plot}

plot_word_embeddings(word_embeddings, words_to_plot)

plt.show()

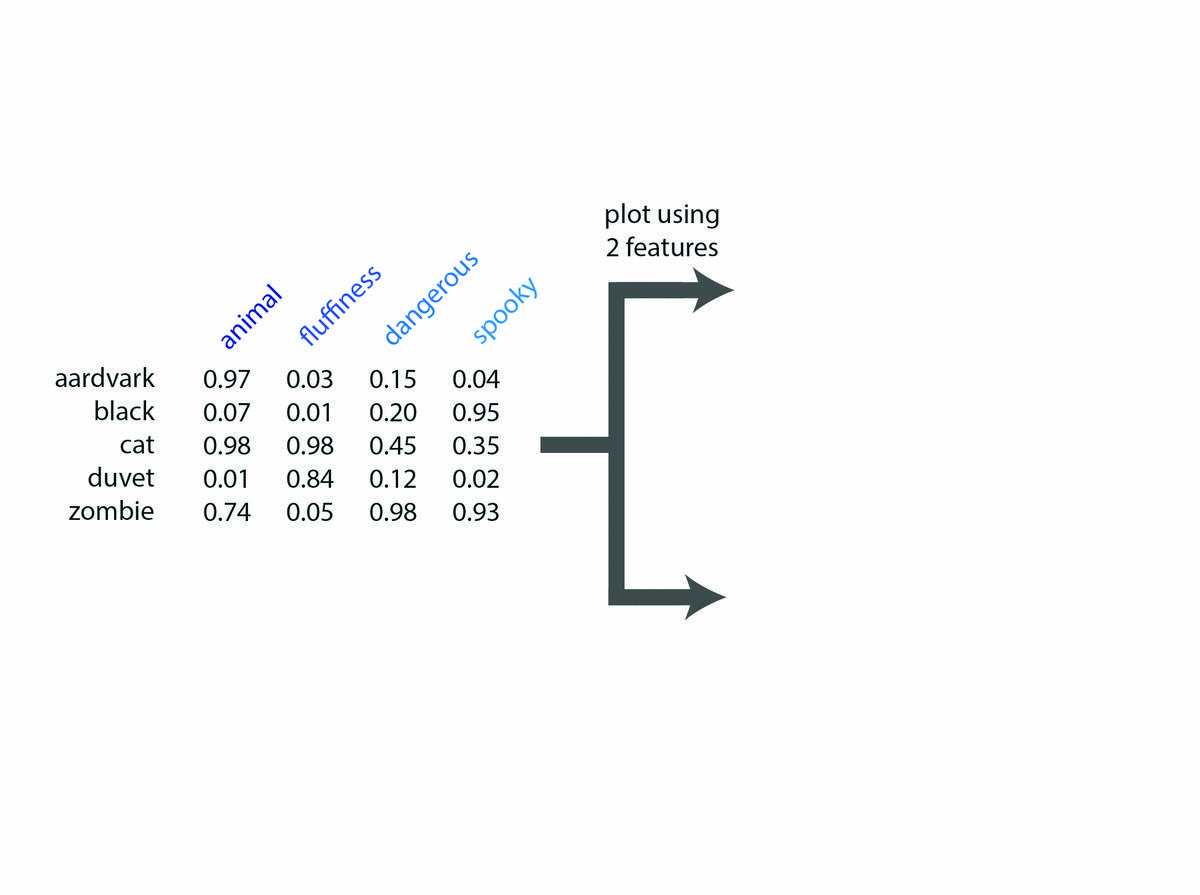

这段代码展示了以下内容:

1. 对文本数据进行预处理:分词、去除停用词和标点符号、词干提取。

2. 在经过预处理的文本数据上训练Word2Vec模型。

3. 将特定词的词嵌入可视化。

如果你尚未安装gensim库,你需要使用pip install gensim安装。

model.wv['brave'].wv['brave']

array([ 8.1681199e-03, -4.4430327e-03, 8.9854337e-03, 8.2536647e-03,

-4.4352221e-03, 3.0310510e-04, 4.2744912e-03, -3.9263200e-03,

-5.5599655e-03, -6.5123225e-03, -6.7073823e-04, -2.9592158e-04,

4.4630850e-03, -2.4740540e-03, -1.7260908e-04, 2.4618758e-03,

4.8675989e-03, -3.0808449e-05, -6.3394094e-03, -9.2608072e-03,

2.6657581e-05, 6.6618943e-03, 1.4660227e-03, -8.9665223e-03,

-7.9386048e-03, 6.5519023e-03, -3.7856805e-03, 6.2549924e-03,

-6.6810320e-03, 8.4796622e-03, -6.5163244e-03, 3.2880199e-03,

-1.0569858e-03, -6.7875278e-03, -3.2875966e-03, -1.1614120e-03,

-5.4709399e-03, -1.2113475e-03, -7.5633135e-03, 2.6466595e-03,

9.0701487e-03, -2.3772502e-03, -9.7651005e-04, 3.5135616e-03,

8.6650876e-03, -5.9218528e-03, -6.8875779e-03, -2.9329848e-03,

9.1476962e-03, 8.6626766e-04, -8.6784009e-03, -1.4469790e-03,

9.4794659e-03, -7.5494875e-03, -5.3580985e-03, 9.3165627e-03,

-8.9737261e-03, 3.8259076e-03, 6.6544057e-04, 6.6607012e-03,

8.3127534e-03, -2.8507852e-03, -3.9923131e-03, 8.8979173e-03,

2.0896459e-03, 6.2489416e-03, -9.4457148e-03, 9.5901238e-03,

-1.3483083e-03, -6.0521150e-03, 2.9925345e-03, -4.5661093e-04,

4.7064926e-03, -2.2830211e-03, -4.1378425e-03, 2.2778988e-03,

8.3543835e-03, -4.9956059e-03, 2.6686788e-03, -7.9905549e-03,

-6.7733466e-03, -4.6766878e-04, -8.7677278e-03, 2.7894378e-03,

1.5985954e-03, -2.3196924e-03, 5.0037908e-03, 9.7487867e-03,

8.4542679e-03, -1.8802249e-03, 2.0581519e-03, -4.0036892e-03,

-8.2414057e-03, 6.2779556e-03, -1.9491815e-03, -6.6620467e-04,

-1.7713320e-03, -4.5356657e-03, 4.0617096e-03, -4.2701806e-03],

dtype=float32)

这段代码是一个简化的例子,在真实场景中,你会处理更大、更多样化的文本数据。你可以根据你特定的数据集和需求自定义代码以适应词汇故事嵌入。

结论

在不断发展的自然语言处理领域中,文字故事嵌入代表着一个迷人且至关重要的进步。这些嵌入打开了理解、生成和推荐具有深刻情感共鸣的故事的新视野。通过关注对故事的整体理解,词汇故事嵌入有潜力创建更具共情力的人工智能系统,生成引人入胜的情感内容,并改进我们与叙事互动的方式。