构建数据管道以创建具有大型语言模型的应用

对于生产级别的大规模语言模型(LLM)应用程序,你需要一个强大的数据管道。本文讨论了构建Gen AI数据管道的不同阶段以及这些阶段中包含的内容。

目前企业追求两种用于LLM应用程序的方法-微调和检索增强生成(RAG)。在非常高的层面上,RAG接受一个输入,并在给定源(例如公司维基)的情况下检索一组相关/支持文档。这些文档将作为上下文与原始输入提示拼接在一起,并输入LLM模型,生成最终的响应。在实时处理场景中,RAG似乎是使LLM快速上市的最受欢迎的方法。支持大多数时间的LLM架构包括构建一个有效的数据管道。

在本文中,我们将探讨LLM数据管道中的不同阶段,以帮助开发人员实现与其数据交互的生产级系统。跟随本文了解如何输入、准备、丰富和提供数据,以供GenAI应用程序使用。

LLM管道的不同阶段是什么?

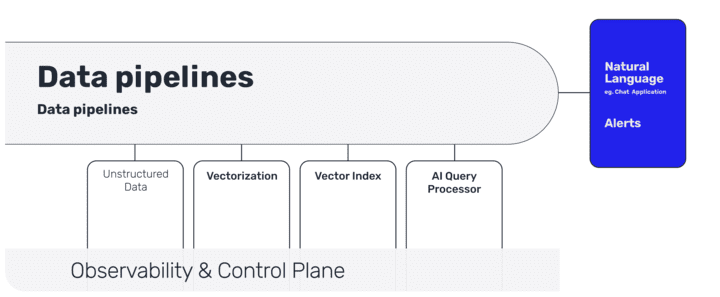

以下是LLM管道的不同阶段:

- 无结构数据的数据导入

- 向量化与丰富(包括元数据)

- 向量索引(与实时同步)

- AI查询处理器

- 自然语言用户交互(使用聊天或API)

非结构数据的数据导入

第一步是收集合适的数据来帮助实现业务目标。如果你正在构建面向消费者的聊天机器人,那么你需要特别注意将使用哪些数据。数据源可以从公司门户(例如Sharepoint、Confluent、文档存储)到内部API等。理想情况下,你希望这些源向索引提供推送机制,以便你的LLM应用程序始终为最终用户保持最新。

在为上下文训练LLM提取文本数据时,组织应该实施数据治理政策和协议。组织可以通过审计文档数据源来编制敏感级别、许可条款和来源目录。识别需要删除或从数据集中排除的受限数据。

这些数据源还应对质量进行评估-多样性、大小、噪音水平、冗余。质量较低的数据集将削弱LLM应用程序的响应。你甚至可能需要一个早期的文档分类机制,以帮助在管道后期进行正确种类的存储。

即使在快节奏的LLM开发中,坚持数据治理的底线也能减少风险。在一开始建立治理措施可以减轻许多问题,并支持可扩展、健壮的文本数据提取。

通过Slack、Telegram或Discord API拉取消息可以获得实时数据的访问,这有助于RAG,但原始的对话数据包含噪音-打字错误、编码问题、奇怪的字符。实时过滤包含冒犯内容或可能是个人敏感信息(PII)的消息是数据清洗的重要组成部分。

向量化与元数据

作者、日期和对话上下文等元数据进一步丰富数据。将外部知识嵌入向量中有助于更智能、更有针对性的检索。

有关文档的某些元数据可能位于门户或文档自身的元数据中,但如果文档附加到业务对象(例如案例、客户、员工信息),则必须从关系数据库中获取该信息。如果存在有关数据访问的安全问题,你可以在此处添加安全元数据,这也有助于管道后期的检索阶段。

这里的一个关键步骤是使用LLM的嵌入模型将文本和图像转化为向量表示。对于文档,你首先需要进行分块,然后最好使用本地零-shot嵌入模型进行编码。

向量索引

向量表示必须存储在某个地方。这就是向量数据库或向量索引用于高效存储和索引此信息的地方。

这成为你的“LLM真相源”,必须与数据源和文档保持同步。如果你的LLM应用程序为客户提供服务或生成业务相关的信息,实时索引变得很重要。你希望避免LLM应用程序与数据源不同步。

通过查询处理器实现快速检索

当你拥有数百万份企业文档时,基于用户查询获取正确的内容变得具有挑战性。

这是管道早期阶段开始增加价值的地方:通过元数据添加进行清洗和数据丰富,尤其是通过数据索引。这种上下文的添加有助于加强提示工程。

用户交互

在传统的管道环境中,你将数据推送到数据仓库,分析工具将从仓库中查询报告。在LLM管道中,最终用户界面通常是一个聊天界面,最简单的情况下接收用户查询并响应查询。

总结

此新类型的管道的挑战不仅仅是获取原型,还包括将其投入生产。这就是企业级监控解决方案追踪你的管道和向量存储变得重要的地方。从结构化和非结构化数据源获取业务数据成为重要的架构决策。LLM代表自然语言处理的最新技术水平,为基于LLM的应用程序构建企业级数据管道将使你处于前沿位置。