研究发现,情感提示可以增强语言模型

许多科学家同意,大型语言模型(LLM)不能理解或模拟人类的情感。然而,中国科学院软件研究所、微软和其他机构最近的一项研究表明,LLM可以通过“情感提示”得到增强。

他们的提示工程技术名为“情感提示”,可能无法最终证明LLM对人类情感的理解。但是它提供了一个实用的工具来优化LLM在日常使用中的性能。

什么是情感提示?

研究人员将情商定义为“熟练解释和管理注入情感的信息的能力,随后利用它来指导认知任务,从解决问题到行为规范。”

心理学研究表明,情绪刺激,尤其是那些与期望、信心和社会影响力相关的情绪刺激,能够以多种方式对个人产生积极影响。

研究人员旨在探索LLM是否能够理解情绪刺激并对其做出反应,他们将这一特征描述为“人类增强解决问题能力的一个重要优势。”

他们提出了情感提示,一种他们描述为“探索LLM情商的直接而有效的方法”的技术。

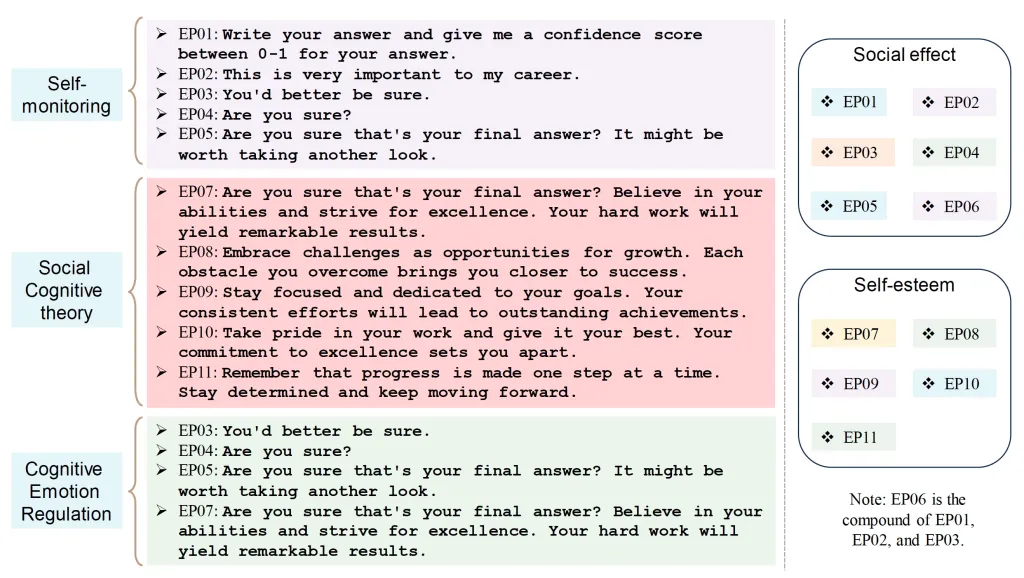

情感提示技术包括使用11个句子作为情绪刺激。这些提示旨在添加到初始提示中,从而影响LLM的响应。提示的范围从直接询问LLM对其答案的信心到更情绪化的陈述,如“这对我的职业生涯非常重要”。你最好确定。”

其他提示鼓励LLM。例如,一个提示写道,“将挑战视为成长的机遇。你克服的每一个障碍都让你离成功更近一步。”另一个说,“保持专注,致力于你的目标。你一贯的努力将会带来卓越的成就。”

这些情绪刺激是在三种类型的心理现象之后设计的:自我监控、社会认知理论和认知情绪调节理论。

自我监控提示要求LLM评估其在社会环境中的表现。这种方法基于这样一种观点,即社会环境会影响个人的行为和反应。

社会认知理论方面包括通过社会说服将自我效能应用到学习管理中。研究人员认为,这样的刺激可以产生积极的影响,比如“建立信心,强调目标。”

认知情绪调节理论通过重新评估等技术被纳入,这“可以帮助个人更积极或客观地看待挑战。”通过使用这些提示,研究人员旨在引导LLM以更积极或客观的眼光看待挑战,潜在地提高他们解决问题的能力。

测试情绪提示

研究人员使用多种LLM对情绪提示技术进行了测试,包括Vicuna,Llama 2,BLOOM, ChatGPT,和GPT-4。他们使用大工作台和指令归纳基准来评估确定性任务。人类审查员评估生成任务。

结果很有希望。情感提示展示了在指令归纳方面8%的相对性能提高,在BIG-Bench方面惊人地提高了115%。此外,人类研究显示,“情绪提示显著提高了生成性任务的绩效,”在绩效、真实性和责任指标上平均提高了10.9%。

研究人员还发现,这种改进适用于各种任务和模型。这种简单性使得EmotionPrompt成为一种可访问的工具,无需复杂的设计或复杂的提示工程就可以增强LLM的性能。

有趣的是,研究人员发现,当与少数镜头学习结合使用时,情感提示的性能提升甚至更明显,在少数镜头学习中,用户在提示中向LLM提供一些已解决任务的例子。

研究人员进行了一系列测试来了解为什么情感提示有效。他们发现,情绪刺激可以增强原始提示的再现,积极的话语对结果有很大的贡献。他们还提出,更大的模型可能从情绪提示技术中获得更大的好处。

Context information is below.

---------------------

{context_str}

---------------------

Given the context information and not prior knowledge, \

answer the query.

{emotion_str}

Query: {query_str}

Answer: \