针对不平衡分类问题的ADASYN算法

介绍

在机器学习领域中,从业者经常面临的一个常见挑战是处理不平衡数据集,即数据集中的类别分布不均,其中一个类别明显超过其他类别。传统的分类算法在处理这种数据集时往往表现较差,因为它们通常偏向多数类别,导致预测结果出现不平衡。为解决这个问题,研究人员开发了各种技术,其中一种显著的技术是自适应合成采样(ADASYN)算法。ADASYN是处理不平衡分类问题的一种强大有效的方法。本文将深入探讨ADASYN算法的原理和优势,以解决不平衡数据集的问题。

了解不均衡分类问题

了解不均衡分类问题的性质对于深入研究ADASYN非常重要。在这些情况下,少数类(即实例较少的类)具有特殊的关注度,例如检测罕见疾病、欺诈检测或制造业中的缺陷检测。数据集中的固有不平衡可能导致传统分类器产生偏倚的结果,即在多数类上表现良好但在少数类上表现糟糕。

ADASYN算法

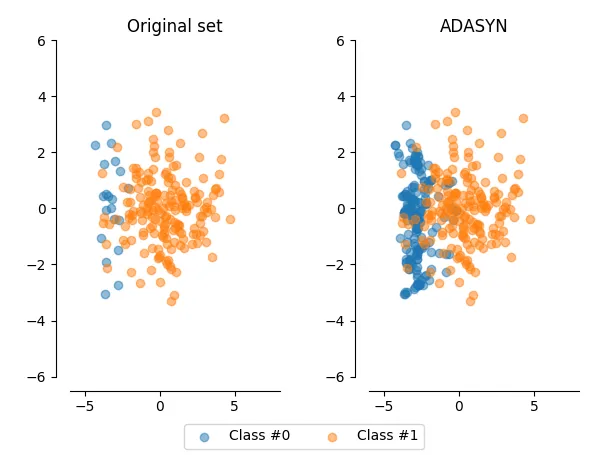

ADASYN是一种数据驱动的方法,旨在解决不平衡数据集带来的挑战。ADASYN作为Synthetic Minority Over-sampling Technique (SMOTE)的一种扩展,旨在自适应地为少数类生成合成样本,更加强调难以分类的实例。

ADASYN的主要原理:

1. 自适应性:ADASYN自适应地评估数据集中的不平衡程度。它赋予更具挑战性的少数类样本更高的重要性,确保在最需要的地方生成合成样本。

2. 数据生成:该算法通过在现有少数类样本之间进行插值生成合成样本。然而,它根据估计的实例分类难度来调整要为每个实例生成的合成样本数量。实例越难分类,为其生成的合成样本就越多。

3. 邻域检测:ADASYN通过计算实例与其k个最近邻之间的欧氏距离来确定其分类难度。距离较大的实例被认为更难分类,并为其创建更多的合成样本。

ADASYN的优点:

1. 提高模型性能:ADASYN有助于提高机器学习模型在不平衡数据集上的分类性能。通过为少数类生成合成样本,它减轻了对多数类的偏见,使模型能够做出更明智的决策。

2. 适应性:ADASYN具有多样性和适应性,适用于各种不平衡数据集。它根据数据集的不平衡程度动态调整合成样本的数量,确保算法的行为与特定数据集的特征相一致。

3. 减少过拟合:与可能导致过拟合的传统过采样技术不同,ADASYN智能地生成合成样本,重点关注决策边界不太清晰的区域。这有助于降低过拟合的风险。

4. 平衡的决策边界:ADASYN通过在需要的地方引入合成样本,有助于更平衡的决策边界。这导致机器学习模型在未见数据上的更好泛化能力。

代码

以下是一个Python代码示例,演示了如何使用ADASYN算法来平衡一个不均衡的数据集,训练分类器,并创建可视化结果的图表。在这个示例中,我们将使用scikit-learn库实现ADASYN算法,使用matplotlib创建图表。我们还将使用著名的Iris数据集进行演示。

import numpy as np

import matplotlib.pyplot as plt

from sklearn.datasets import load_iris

from sklearn.model_selection import train_test_split

from sklearn.ensemble import RandomForestClassifier

from imblearn.over_sampling import SMOTE

from collections import Counter

# Load the Iris dataset

iris = load_iris()

X, y = iris.data, iris.target

# Creating class imbalance by removing some samples

X_imbalanced = X[25:, :]

y_imbalanced = y[25:]

# Split the data into training and testing sets

X_train, X_test, y_train, y_test = train_test_split(X_imbalanced, y_imbalanced, test_size=0.3, random_state=42)

# Count the class distribution before applying SMOTE

print("Class distribution before SMOTE:", Counter(y_train))

# Apply SMOTE to balance the dataset

smote = SMOTE(sampling_strategy='auto', random_state=42)

X_resampled, y_resampled = smote.fit_resample(X_train, y_train)

# Count the class distribution after applying SMOTE

print("Class distribution after SMOTE:", Counter(y_resampled))

# Train a classifier on the balanced dataset

clf = RandomForestClassifier(random_state=42)

clf.fit(X_resampled, y_resampled)

# Make predictions on the test set

y_pred = clf.predict(X_test)

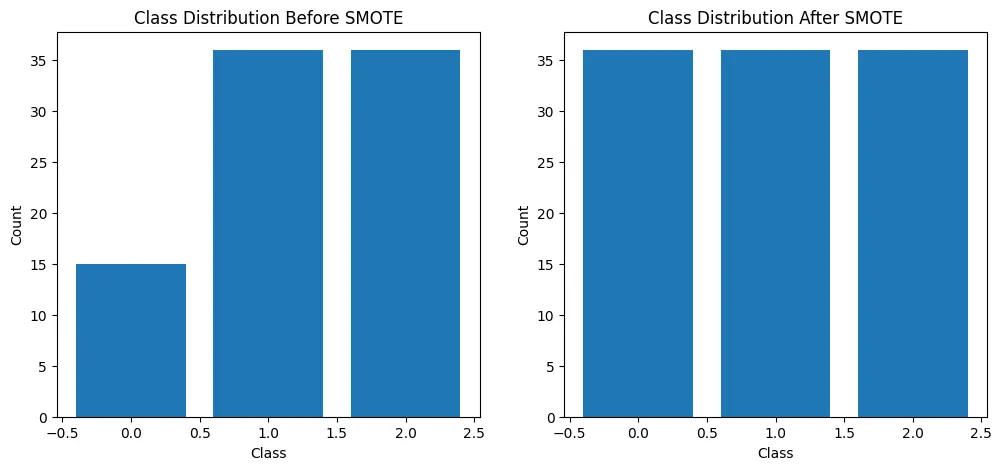

# Plot the class distribution before and after SMOTE

plt.figure(figsize=(12, 5))

plt.subplot(1, 2, 1)

plt.bar(Counter(y_train).keys(), Counter(y_train).values())

plt.title("Class Distribution Before SMOTE")

plt.xlabel("Class")

plt.ylabel("Count")

plt.subplot(1, 2, 2)

plt.bar(Counter(y_resampled).keys(), Counter(y_resampled).values())

plt.title("Class Distribution After SMOTE")

plt.xlabel("Class")

plt.ylabel("Count")

plt.show()

在这段代码中,我们首先在Iris数据集中创建类别不平衡,然后使用ADASYN平衡数据集。我们计算ADASYN之前和之后的类别分布,并使用条形图进行可视化。最后,我们训练一个随机森林分类器,并在特征的二维子空间上绘制决策边界。

Class distribution before SMOTE: Counter({2: 36, 1: 36, 0: 15})

Class distribution after SMOTE: Counter({2: 36, 1: 36, 0: 36})

请注意,你可能需要安装imbalanced-learn库来使用ADASYN。你可以使用pip来安装它:

pip install imbalanced-learn这个实例仅使用了Iris数据集的两个特征用于可视化目的。在实际应用中,通常会处理高维数据。

结论

自适应合成采样(ADASYN)算法是一种解决不平衡分类问题的宝贵工具。通过为少数类别自适应生成合成样本,它可以使机器学习模型做出更准确的预测,并减少对多数类的偏差。ADASYN的适应性和降低过拟合的能力使其成为处理不平衡数据集的首选选择,从医学诊断到欺诈检测等各个领域。随着机器学习领域的不断发展,ADASYN 是一种很有前途的解决方案,可提高不平衡数据集上分类器的性能。