检测科学期刊中人工智能生成的文本

在学术界对人工智能生成的论文高度关注的时代,Kansas大学传来了令人放心的消息。

研究人员开发了一种用于科学论文的人工智能文本检测器,几乎可以100%区分人工撰写的内容和计算机生成的内容。

在11月6日发表在《细胞报告物理科学》上的一项研究中,Heather Desaire教授指出,虽然目前有几种用于一般内容的人工智能检测器,但应用于科学论文时效果都不是很理想。

Desaire说:“文本分析领域的大多数人都希望有一个真正通用的检测器,可以应用于各种领域。”相反的是,她的团队则专注于检测化学专题的科学期刊上的报告。

“我们真的在追求准确性,”她说。

该团队的探测器在美国化学学会出版的期刊上接受了训练。他们收集了100篇由专业人士撰写的介绍性文章,然后编程ChatGPT根据期刊摘要或仅根据报告标题撰写自己的介绍。

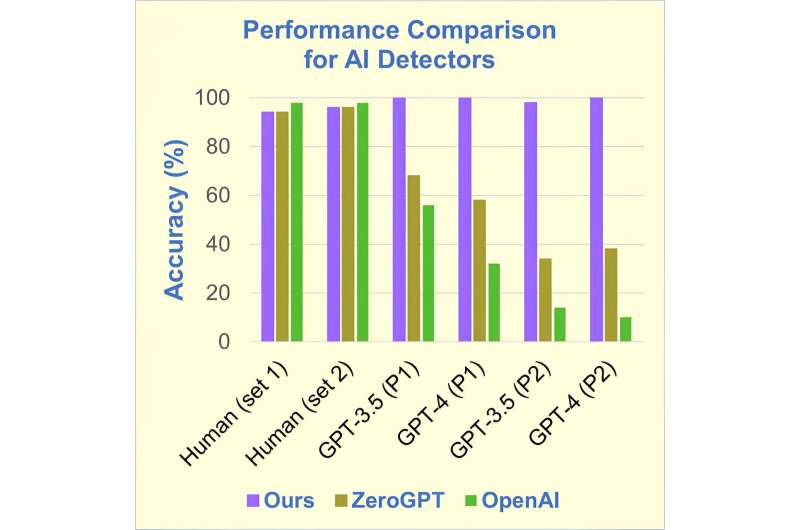

当ChatGPT检测器扫描这三类报告时,它几乎100%的时间正确地识别出人类撰写的内容,并且对于仅基于报告标题的生成的报告也能准确识别。对于依赖引言段落的报告,正确识别率为98%。

然而,ZeroGPT等竞争对手在检测一般人工智能文章方面的准确率为98%,但在化学相关报告方面表现不佳。基于标题的相同报告的平均准确率仅为37%,基于介绍性文本的报告的准确率仅高出几个百分点。

第二个竞争对手OpenAI的情况更糟,平均无法正确识别论文作者的身份高达80%。

Desaire说:“学术出版商正在努力应对新的人工智能文本生成器的迅速普及。”“这种新的检测器将使科学界能够评估ChatGPT对化学期刊的渗透,确定其使用的后果,并在出现问题时迅速引入缓解策略。”

科学期刊正在改写其关于文章提交的规则,大多数期刊禁止人工智能生成的报告,并要求披露撰写报告时使用的任何其他人工智能过程。

Desaire列举了一些关于人工智能生成的内容渗透科学期刊风险的担忧:“它们的过度使用可能会导致价值不高的文章泛滥。它们可能会导致被高度引用的论文被过度代表,而尚未广为人知的新兴作品被忽视。”

“最令人担忧的是,”她补充道,“这些工具倾向于‘幻觉’,编造不真实的事实。”

作为例证,Desaire收录了一则关于ChatGPT撰写的关于她的传记。它说她“毕业于Minnesota大学,是英国皇家化学学会的成员,并获得了Biemann奖章。”这些令人印象深刻的成就都是假的。

Desaire说:“虽然这个例子很有趣,但用谎言渗透科学文献一点也不好笑。”

但她仍然乐观。她说,有人说,抵制人工智能生成内容的出现是不可避免的,他们认为“开发这样的工具是在参与一场人类不会赢的(与人工智能的)军备竞赛。”

她说,编辑必须带头检测人工智能污染。

她说:“期刊应该采取合理的措施,确保他们关于人工智能写作的政策得到遵守,我们认为在检测人工智能的问题上保持领先是完全可行的。”