ControlLLM:一种使LLM利用多模态工具解决复杂任务的AI框架

LLM在处理复杂的现实世界任务方面的表现令人印象深刻。然而,在由于用户提示含糊、选择工具不正确以及参数设置和调度不当的情况下,它们可能需要帮助来正确使用工具。为了解决这些挑战,香港科技大学、OpenGVLab、上海AI Lab、清华大学和商汤科技的研究团队提出了一个名为ControlLLM的开创性框架。该研究旨在探究ControlLLM在提高LLM有效性方面的重要性。

LLM在解决自主代理的规划、推理和决策挑战方面已经取得了实质性的进展。研究的另一个方向集中于通过外部工具增强LLM,以获取最新信息、减少幻觉和实现多模态交互。工具增强型LLM利用LLM的零次或少次数上下文学习来处理任务分解、工具选择和参数完成,无需明确的微调。像幻觉和有效分解这样的挑战依然存在。人们正在努力培育具有内在多模态能力的LLM,扩展它们适用于更复杂的现实世界场景。

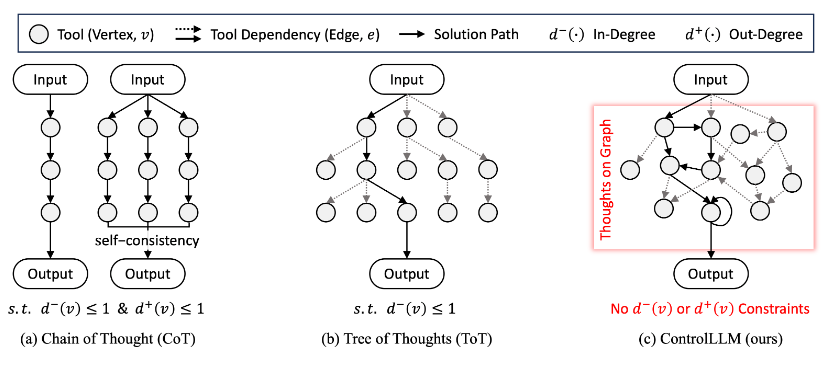

LLM在自然语言理解方面展现了自己的威力,并且现在它们正在扩展其能力以包括多模态交互。工具增强型LLM试图通过整合能够处理涉及图像、视频、音频等任务的工具来扩展LLM的功能,尽管需要解决任务分解、工具选择、参数分配和高效执行调度等挑战。之前的方法如Chain-of-Thought(思维链)、Tree-of-Thought(思维树)和自我一致性已通过将复杂任务分解为更小的子任务来处理这些任务。

ControlLLM框架包括三个基本组件:任务分解器、Thoughts-on-Graph方法和一个多功能执行引擎。任务分解器将复杂的用户提示分解为具有明确输入和输出的明确子任务。Thoughts-on-Graph在预定义的工具图上探索最佳的解决路径,指定工具的参数和依赖关系。执行引擎解释这一路径并在各种计算设备上高效地执行动作。

与现有方法相比,ControlLLM框架在准确性、效率和通用性方面表现出色,尤其是在涵盖图像、音频和视频处理的各种任务中。它在解决难题方面取得了98%的成功评估率,超过了59%的最佳基线表现。ControlLLM还显著提升了工具使用效率,善于推断和分配工具参数。在简单和复杂的场景中,ControlLLM无缝地整合了各种信息类型,基于执行结果生成全面而有意义的回应。

总之,ControlLLM框架使LLM能够使用多模态工具来解决复杂的现实世界任务,提供了卓越的准确性、效率和可适应性。其组成部分,包括任务分解器、Thoughts-on-Graph方法和一个多功能执行引擎,共同为工具使用带来了实质性的改善。ControlLLM通过专业地推断和分配工具参数,并在解决方案评估中达到高成功率,一直展示着其实力。通过广泛的案例研究,它重申了其任务规划能力,提供了提升用户体验的多样化解决方案。ControlLLM整合了不同信息来源,生成了基于执行结果的全面且有意义的回应。