Toloka:评估LLM更好的方法

本文介绍了一种评估LLM的新方法,该方法利用人类洞察力,将LLM的响应与按NLP任务分类的实际用户提示进行比较,为提高LLM评估标准提供了一个有希望的解决方案。

LLM评估简介

LLM开发的最新进展使其在以前使用旧的机器学习方法处理的各种NLP任务中得到了推广。大型语言模型能够解决各种语言问题,如分类、摘要、信息检索、内容创建、问题回答和维护对话——所有这些都都可以只使用一个模型完成。但我们怎么知道他们在所有这些不同的任务上都做得很好呢?

LLM的兴起暴露了一个尚未解决的问题:我们没有一个可靠的标准来评估它们。使评估更加困难的是,它们用于高度多样化的任务,而我们对每个用例的好答案缺乏明确的定义。

本文讨论了当前评估LLM的方法,并介绍了一种新的LLM排行榜,该排行榜利用了对现有评估技术的改进。

当前方法和排行榜

第一种也是通常的初始评估形式是在几个精心策划的数据集上运行模型并检查其性能。HuggingFace创建了一个开放LLM排行榜,使用四个众所周知的数据集(AI2推理挑战、HellaSwag、MMLU和TruthfulQA)评估开放访问大型模型。这相当于自动评估,并检查模型获取某些特定问题事实的能力。

这是MMLU数据集中的一个问题示例。

主题:学院_医学

问题:补充肌酸的预期副作用是。

A) 肌肉无力

B) 体重增加

C) 肌肉痉挛

D) 电解质损失

答案:(B)

对模型回答这类问题进行评分是一个重要的指标,可以很好地进行事实核查,但它并不能测试模型的生成能力。这可能是这种评估方法的最大缺点,因为生成自由文本是LLM最重要的功能之一。

社区内部似乎达成了共识,即要正确评估模型,我们需要人工评估。这通常是通过比较不同模型的响应来完成的。

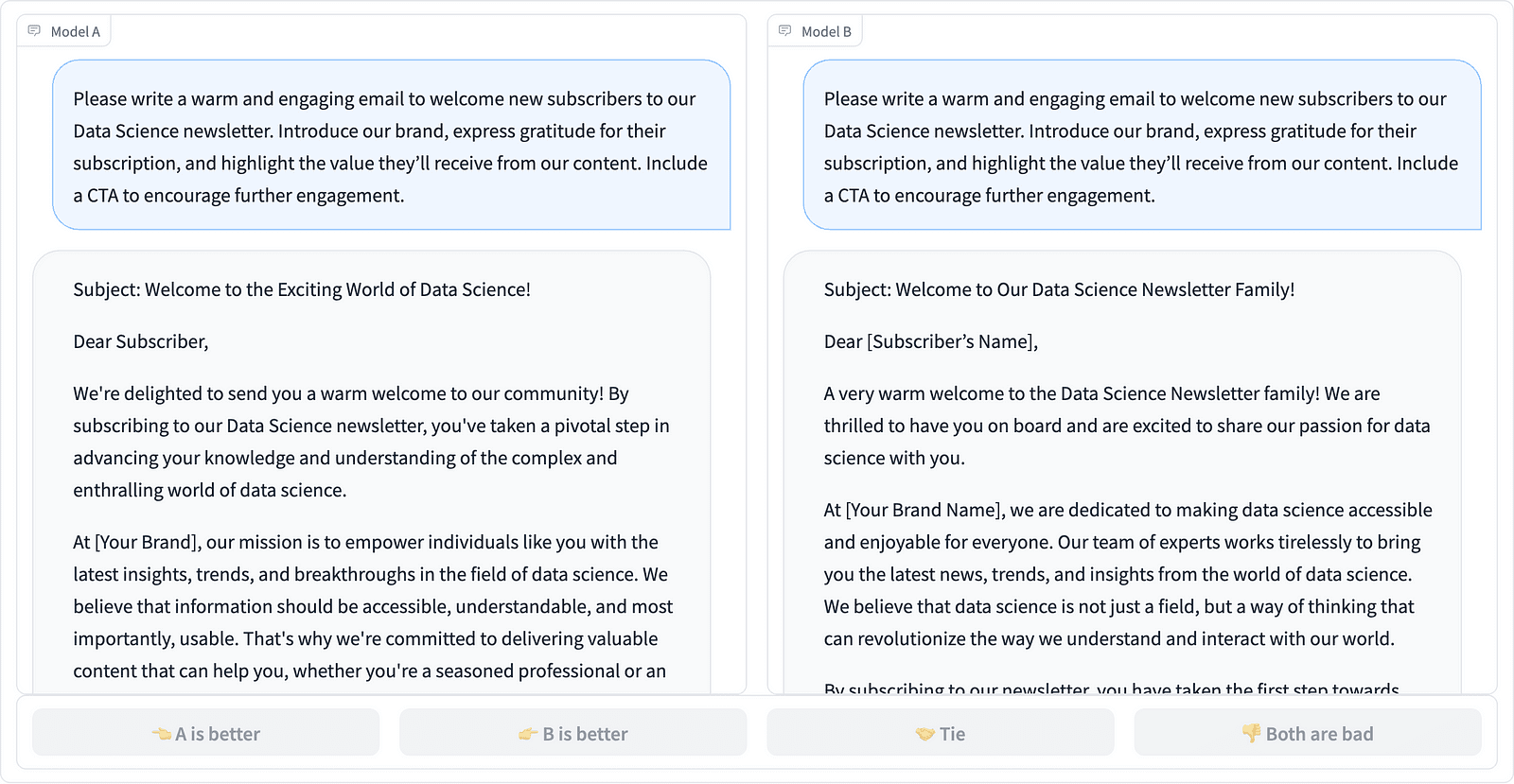

评估者决定哪种响应更好,如上面的例子所示,有时还会量化提示完成的质量差异。LMSYS组织创建了一个使用这种类型的人类评估的排行榜,并比较了17种不同的模型,报告了每个模型的Elo评级。

由于人类评估可能很难规模化,因此一直在努力扩大和加快评估过程,这导致了一个名为AlpacaEval的有趣项目。在这里,将每个模型与基线(GPT-4提供的text-davinci-003)进行比较,并用GPT-4判断代替人类评估。这确实是快速和可扩展的,但我们能相信这里的模型来执行评分吗?我们需要意识到模型的偏差。该项目实际上已经表明,GPT-4可能更喜欢更长的答案。

随着人工智能社区寻求简单、公平和可扩展的方法,LLM评估方法正在不断发展。最新的进展来自于Toloka的团队,他们有了一个新的排行榜,以进一步提高当前的评估标准。

利用人类评估LLM

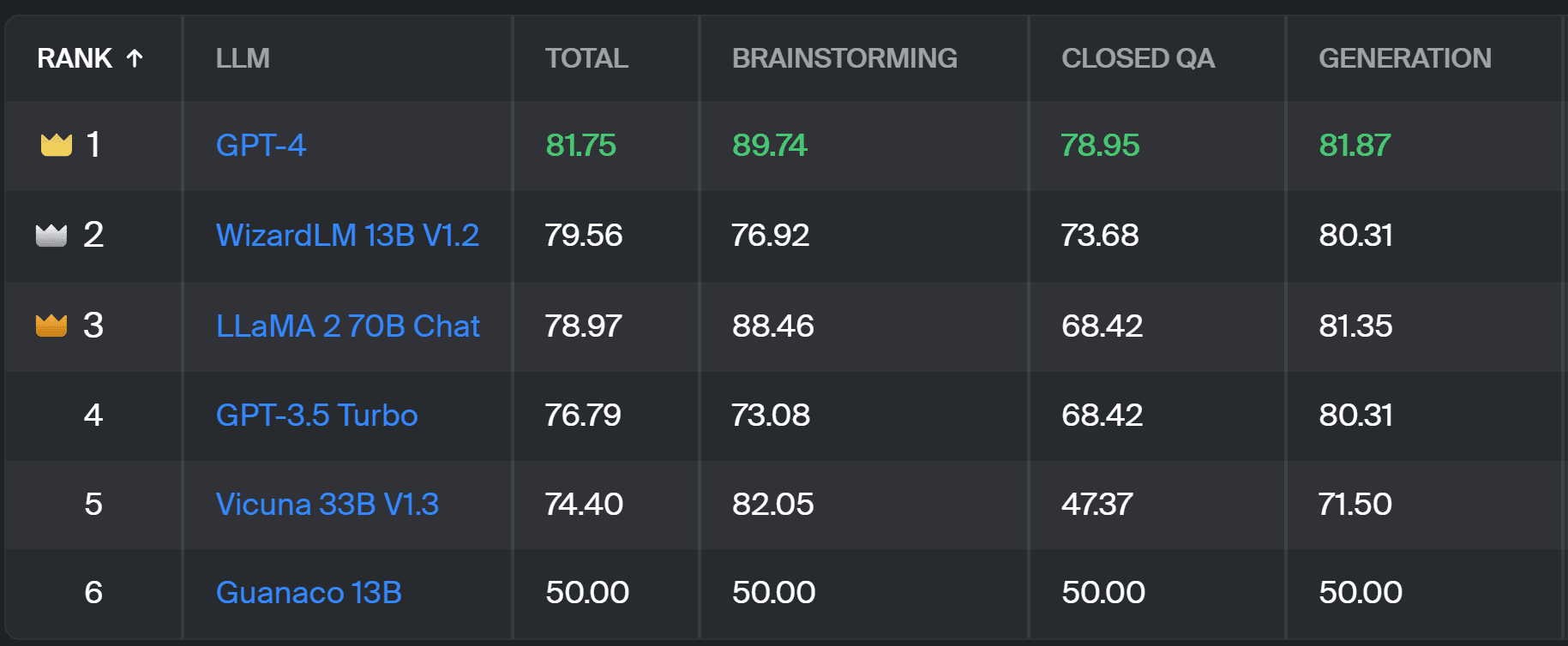

新的排行榜将模型响应与现实世界中的用户提示进行了比较,这些提示按本InstructionGPT论文中概述的有用的NLP任务进行了分类。它还显示了每个模型在所有类别中的总体胜率。

本项目所使用的评估类似于在AlpacaEval中进行的评估。排行榜上的分数代表相应模型与基准Guanaco 13B模型比较的胜率。选择Guanaco 13B而不是即将过时的text-davinci-003模型,是对AlpacaEval方法的改进。

实际的评估是由人类专家在一组真实世界的提示上完成的。对于每个提示,注释者都会得到两个完成情况,并被问到他们更喜欢哪一个。

这种类型的人工评估比任何其他自动评估方法都更有用。LMSYS方法的缺点是,任何拥有链接的人都可以参与评估,这就导致以这种方式收集的数据的质量可能出现严重问题。一个固定的专家评注员群体具有更可靠的结果潜力,Toloka采取了额外的质量控制技术以确保数据质量。

总结

在本文中,我们介绍了一个很有前途的评估LLM新解决方案——Toloka排行榜。该方法具有创新性,结合了现有方法的优势,增加了任务特定的颗粒度,使用了可靠的人工注释技术来比较模型。