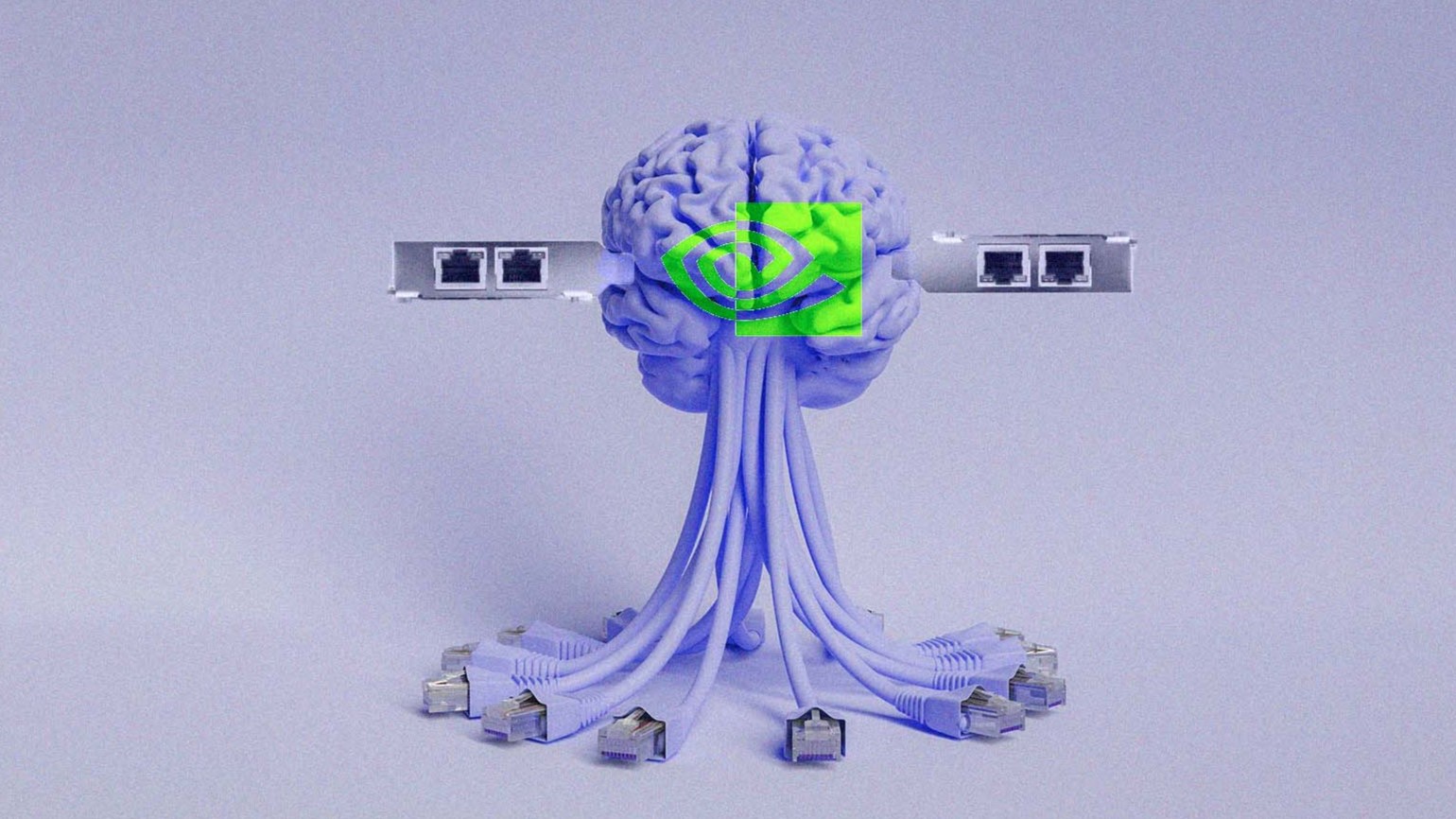

NVIDIA凭借Infiniband技术引领高性能计算领域

黄仁勋在NVIDIA电话财报会议上表示:“绝大多数专门的大型人工智能工厂都在InfiniBand上实现标准化。”

NVIDIA一直以来表现亮眼,最新的第三季度财报反映了这家科技巨头的不可阻挡增长。其最近的公布收入为181.2亿美元,同比增长206%,环比上一季度增长34%。该公司甚至将收入的惊人增长归因于NVIDIA HGX平台的持续提升以及通过InfiniBand实现的端到端网络。

NVIDIA宣布网络业务的贡献现已超过每年100亿美元的年化收入运营速率,几乎是去年的三倍。这归因于对InfiniBand日益增长的需求,其年增长率高达五倍。

InfiniBand被认为是获得训练大型语言模型(LLM)所需的规模和性能的关键,与NVIDIA HGX结合起来,构成了人工智能超级计算机和数据中心基础设施的基础架构。InfiniBand通常用于超级计算环境中连接服务器。其最大的优势是能够提供对并行处理任务至关重要的低延迟和高带宽通信。对于超大型数据集和超快速处理高分辨率模拟,NVIDIA的Quantum InfiniBand交换机据说能以更低的成本和复杂性满足这些需求。

几个月前,NVIDIA在其领先的H100芯片上取得了突破性的性能。这些测试是在连接了InfiniBand的3584个H100 GPU上运行的,它们允许GPU在独立和规模层面上提供性能。由此证明了与高性能网络能力相结合时的实力。

谈到InfiniBands的未来,黄仁勋说,绝大多数专用的大规模人工智能工厂都标准化使用InfiniBand,这不仅仅是因为数据速率和延迟,“网络中的流量移动方式”也很重要。他还称其为“Computing Fabric”。

将其与以太网进行比较,黄谈到两者之间的巨大差异。随着NVIDIA为人工智能工厂投资20亿美元,任何形式的偏差都将导致数百万美元价值的变动,并在未来4-5年内累积成重大成本。

黄称InfiniBand的价值主张对于人工智能工厂来说是“不可否认的”。不过,以太网并未被排除在外。InfiniBands用于需要高带宽和低延迟的情况,以太网在其他场景中也适用。

以太网是一种用于有线局域网(LAN)的广泛使用的通用网络技术,适用于广泛的应用程序,更多地用于连接终端设备。然而,其能力无法与InfiniBands匹敌。

有趣的是,NVIDIA还提供网关设备将InfiniBand数据中心连接到基于以太网的基础设施和存储。NVIDIA还将在明年第一季度发布Spectrum-X,一种以太网产品,据称其网络性能比其他可用的以太网技术高出1.6倍。

在功能上,Intel的Omni Path Architecture (OPA)被设计用于高速数据传输和高性能计算环境中的低延迟通信。它于2016年发布,在2019年停产。

随着GPU和网络产品的提供,企业现在可以选择将他们的整个架构框架与NVIDIA产品集成。除了谈到与Reliance、Infosys和Tata的合作关系,该公司还提到了与多家组织的合作,用于优化他们在人工智能计算需求中的InfiniBands。

在财报电话会议中,NVIDIA谈到了与Scaleway(一家法国私有云提供商)的合作关系,该公司将基于NVIDIA H100 InfiniBand和人工智能企业软件建立他们的区域性人工智能云,以推动欧洲的人工智能进步。

此外,德国的Julich超级计算中心也宣布了其建设下一代人工智能超级计算机的计划,使用接近24000个Grace Hopper Superchips和Quantum-2 InfiniBand,将其提升为全球最强大的人工智能超级计算机,拥有超过90 exaflops的人工智能性能。

有趣的是,微软Azure使用了超过29000英里的InfiniBand布线。Infiniband启用的HB和N系列虚拟机被微软用于实现高性能计算(HPC)并带来成本效益。

通过捆绑网络和GPU,NVIDIA正在促进其在超级计算机市场的增长和地位。从NVIDIA InfiniBands缺乏替代品来看,该公司的主导地位似乎将进一步提升,最终使其成为想要利用GPU和网络的公司不可或缺的。