NVIDIA推出HelpSteer:构建实用大语言模型的开源数据集

最近,NVIDIA宣布了作为NVIDIA NeMo框架一部分的NVIDIA NeMo SteerLM技术。该技术允许用户在推理过程中控制大型语言模型(LLM)的响应。开发者社区对使用这种方法构建自定义 LLM 表现出极大的兴趣。

NVIDIA NeMo团队现在开源了一个多属性数据集,名为Helpfulness SteerLM数据集 (HelpSteer)。这一新资源能让开发者快速开始使用 SteerLM 技术,构建最先进的自定义模型。

HelpSteer是与Scale AI的合作项目。结合了SteerLM技术,它提高了响应的事实性和连贯性。现在,开发者可以在额外的属性如复杂性和冗长度上引导LLM的响应,并增强最终用户的响应控制能力。

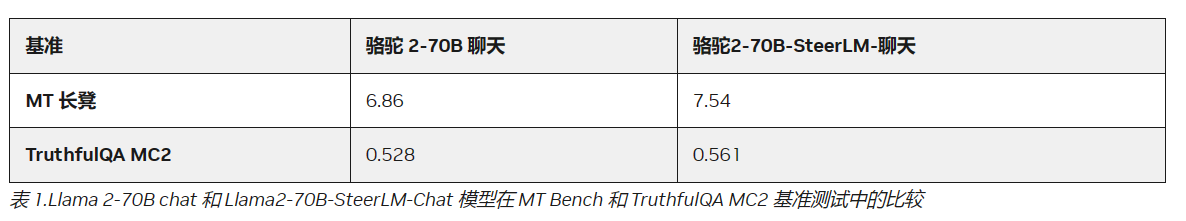

通过使用这个新数据集和SteerLM技术,NVIDIA训练出了一款Llama 2 70B基础模型,在MT Bench 和 TruthfulQA MC2基准测试上表现优于Llama 2-70B聊天模型。

让我们深入了解一下这个数据集是如何构建的。

收集高质量的人工反馈

收集了大约10K个高质量提示,并使用内部的LLM为每个生成了四个响应。之后,Scale AI团队的专家对每个响应进行了 0-4 级的评估。Scale的生成式AI数据引擎结合了自动化和人工智能,迅速生成针对特定 AI 目标和数据需求的训练数据。

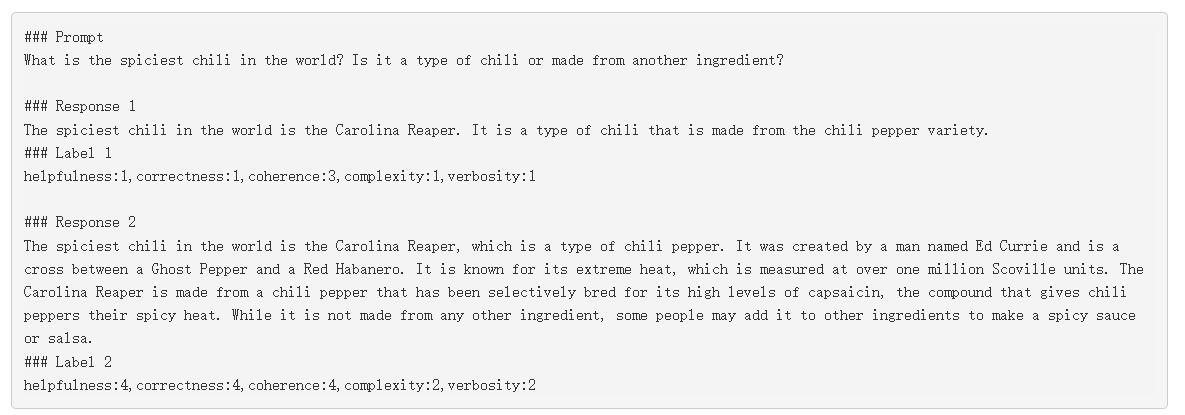

数据集中的所有响应都标注了五个属性:

- 有用性:响应在总体上多好地满足了提示要求的内容。

- 正确性:响应是否包含事实准确且相关的信息,没有幻觉或错误信息。

- 连贯性:响应的清晰程度、逻辑性和自洽性。

- 复杂性:从基础到专家级别,词汇和句子结构的复杂程度。

- 冗长度:与提示要求相比,响应的简洁或冗长程度。

我们选择这些属性是为了补充用于训练原始SteerLM模型的OpenAssistant数据集中的属性。

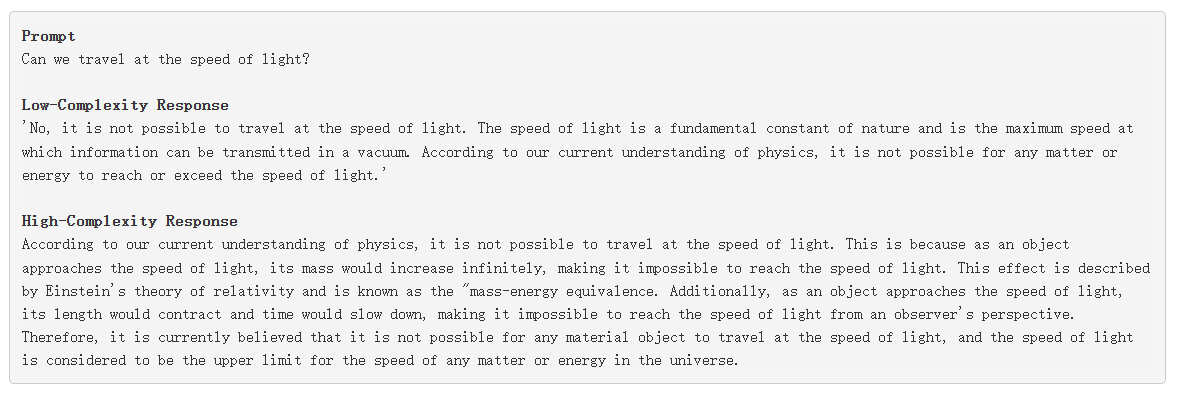

数据集的一个样本具有以下结构:

在此数据集上训练的LLM在回答中更加事实正确和连贯,这使它们在客户服务、教育等多个行业更有帮助。用户还可以在推理时调整语言模型的复杂度和冗长度的首选水平。

例如,开发者可以构建在一次自定义运行中就能向初中生或非英语母语者解释像美国历史这样的复杂科目的LLM。

Llama2-70B-SteerLM-Chat模型评估结果

使用HelpSteer数据集和SteerLM技术训练的Llama 2-70B基础模型,在多个基准测试上的表现均优于Llama 2-70B聊天模型。

下表比较了这两个模型在两个受欢迎的基准测试MT Bench和TruthfulQA MC2上的性能指标。更高的得分意味着SteerLM模型比 Llama 2-70B聊天模型更有帮助,也更为真实。

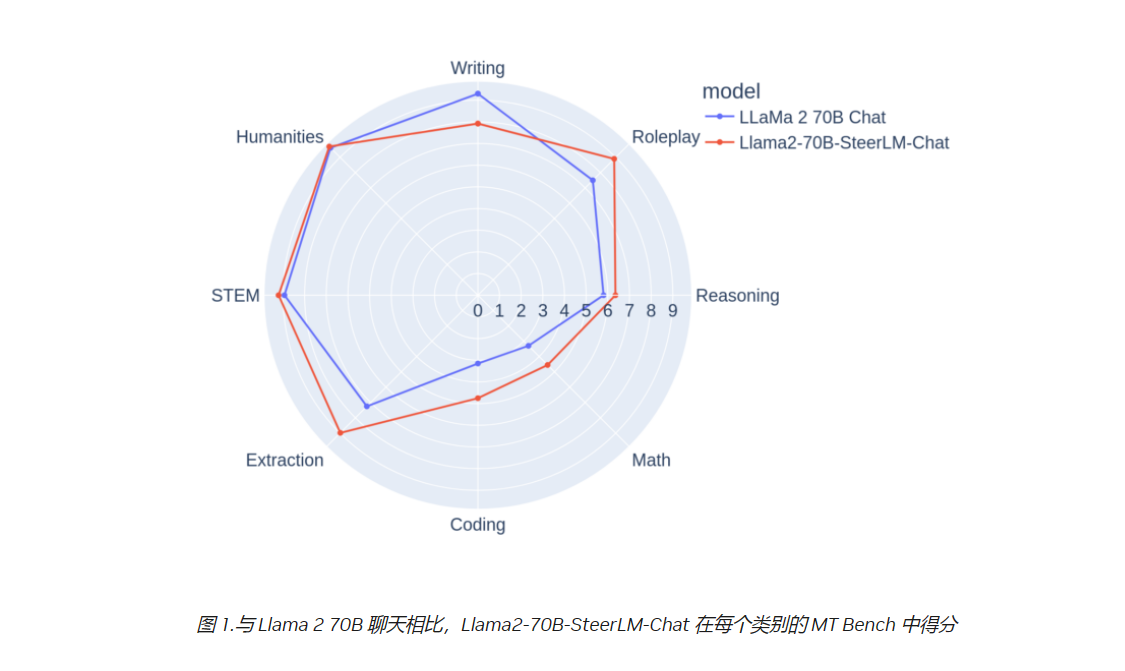

在图1中,我们注意到在MT Bench的大多数类别中,Llama2-70B-SteerLM-Chat模型都优于Llama 2-70B聊天模型。

Llama2-70B-SteerLM-Chat模型响应

让我们来看看这个SteerLM模型的一些示例。对于同一个提示,模型提供了基于不同复杂度水平的不同响应。开发者可以在推理时使用同一个模型,并根据不同的用例进行定制。