Nous发布开源视觉语言模型Hermes 2 Vision Alpha,面临优化挑战

Nous Research, 一家以在大型语言模型(LLM)领域发布开源工作而闻名的私人应用研究小组,发布了一款轻量级的视觉-语言模型,名为Nous Hermes 2 Vision。

这个开源模型可以通过Hugging Face获得,该模型在公司之前的OpenHermes-2.5-Mistral-7B模型的基础上发展而来。它具有视觉功能,包括能够通过图像提示和从视觉内容中提取文本信息的能力。

然而,该模型发布后不久,就发现模型幻觉比预期的多,导致出现了错误,并最终将项目重命名为Hermes 2 Vision Alpha。公司预计会发布一个更稳定的版本,提供相似的好处但错误较少。

Nous Hermes 2 Vision Alpha

以希腊神使赫尔墨斯的名字命名,Nous视觉模型旨在成为一个能够“以天国的技巧巧妙地导航复杂的人类话语”的系统。它利用用户提供的图像数据,并将该视觉信息与其学习成果结合起来,以自然语言提供详细的答案。

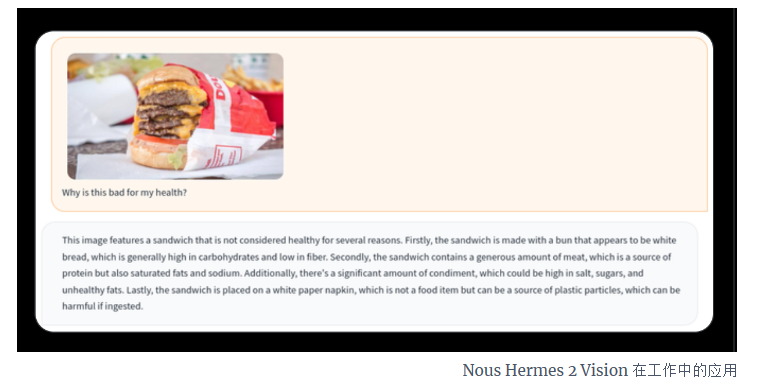

例如,它可以分析用户的图像,并详细说明它所包含的不同方面。Nous的联合创始人之一,化名Teknium在X上,分享了一个测试截图,其中LLM能够分析一张汉堡照片,并弄清楚吃它是否会有害健康并解释原因。

尽管基于GPT-4V的ChatGPT也带来了使用图像提示的能力,但Nous的开源产品在两个关键方面与众不同。

首先,与依赖庞大的3B视觉编码器的传统方法不同,Nous Hermes 2 Vision采用SigLIP-400M。这不仅简化了模型的架构,使其比同类产品更轻量,而且还有助于在视觉-语言任务上提升性能。

其次,它经过了一个经过丰富函数调用的自定义数据集的训练。这允许用户使用<fn_call>标签提示模型,并从图像中提取书面信息,比如菜单或广告牌。

“这个独特的补充将Nous-Hermes-2-Vision转变为一个视觉-语言动作模型。开发者现在拥有一个多功能的工具,为创造各种巧妙的自动化做好了准备。”该公司在模型的Hugging Face页面上写道。

用于训练模型的其他数据集包括LVIS-INSTRUCT4V、ShareGPT4V以及OpenHermes-2.5的对话。

现阶段依旧存在问题

虽然Nous视觉-语言模型可供研究和开发使用,但早期使用显示它远非完美。

在发布后不久,联合创始人发表帖子称模型出了问题,产生了很多幻觉,滥用EOS令牌等。后来,该模型被重命名为alpha版本。

“我看到人们谈论‘幻觉’,是的,情况确实很糟。我也意识到这一点,因为基础LLM是一个未经审查的模型。我将在本月底之前更新这个版本,以解决这些问题。”Nous的研究员Quan Nguyen在X上写道。

尽管如此,Nguyen在另一篇帖子中指出,如果用户定义了一个好的架构,函数调用功能仍然运行良好。他还说,如果用户反馈足够好,他会推出一个专门用于函数调用的模型。

到目前为止,Nous Research已经发布了41个具有不同架构和功能的开源模型,作为其Hermes、YaRN、Capybara、Puffin和Obsidian系列的一部分。