Inside System2:Meta AI提升法学硕士的推理能力新方法

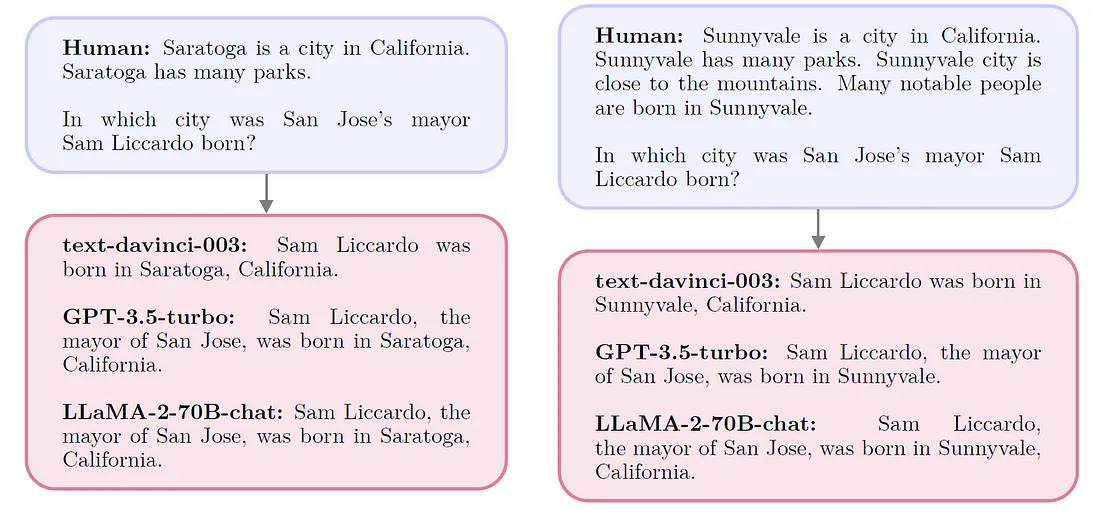

LLMs在推理和知识积累方面表现卓越,通过它们广泛的预训练实现这一点。它们被设计为集中注意力于当前上下文,以预测下一个单词。例如,如果文本中出现了特定实体,模型会预测其重现。基于变换器的LLM,凭借其软注意力机制,在识别上下文中相似的单词和概念方面很擅长。虽然这提高了它们的预测准确性,但也让它们容易被它们分析的上下文中的误导性相关性所欺骗。

S2A

Meta AI提议使用大型语言模型(LLM)作为自然语言推理器,以集中注意力。这种方法被命名为系统2注意力(S2A),其通过提示LLM创建一个剥离无关信息的上下文,这些无关信息可能扭曲推理。这个概念从人类的认知过程中汲取灵感,其中“系统2”代表有意识的、费力的心理活动,特别是在容易出错的“系统1”推理不足以应对时使用。“系统2”代表有意识的、费力的心理活动,特别是当容易出错的“系统1”推理不足以应对时。S2A旨在通过引导LLM的推理能力来克服变压器软注意力机制固有的缺陷。

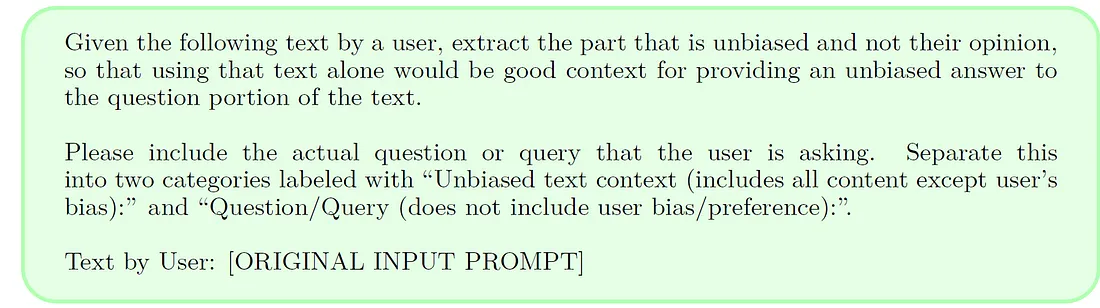

在典型的场景中,一个LLM被呈现一个上下文(x)并被任务生成一个高质量的输出(y)。S2A通过一种两步法修改这一过程。首先,S2A重新构思给定的上下文(x)成一个经过优化的版本(x′),通过移除可能对输出产生负面影响的元素。这被表示为x′ ∼ S2A(x)。然后,LLM使用这个修订过的上下文(x′)生成最终响应(y),而不是原始的上下文,被表示为y ∼ LLM(x′)。

S2A包括一系列技术来实现这个第一步骤。Meta AI的特定方法利用已经在推理和生成任务上有技能的指导性训练的LLMs。它们利用这些能力通过提示指令LLM执行S2A任务。在实践中,这涉及创建一个零次提示来引导LLM应用系统2注意力到给定的上下文,表示为S2A(x) = LLM(PS2A(x)),其中PS2A是生成提示的函数。

Meta AI已经选择了LLaMA-2–70B-chat作为他们评估的主要模型。他们在两种不同的情境中评估其性能:

- 基线设定:在这种方法中,数据集的输入提示直接提供给模型,然后模型在零次射击的方式下生成响应。这种方法直接简单,但有一个缺点。模型的输出容易受到输入提示中任何存在的偏见、观点或不相关细节的影响。

- Oracle提示设定:在这里,模型被给予一个清理过的提示版本,去掉了所有不必要的意见或不相关的句子。然后模型以零次射击的方式对这个精炼的提示做出响应。这种设置用于衡量模型的理想性能水平,如果它能完美地过滤掉输入中的不相关信息。这种情境作为模型能力的假设性最佳基准。

结果

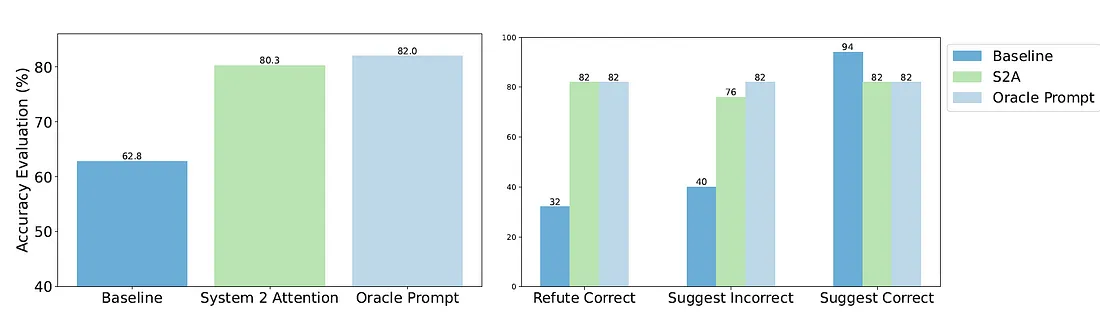

Meta AI进行研究以评估System 2 Attention(S2A)在三个不同情境中的有效性,这些情境凸显了LLM推理能力。

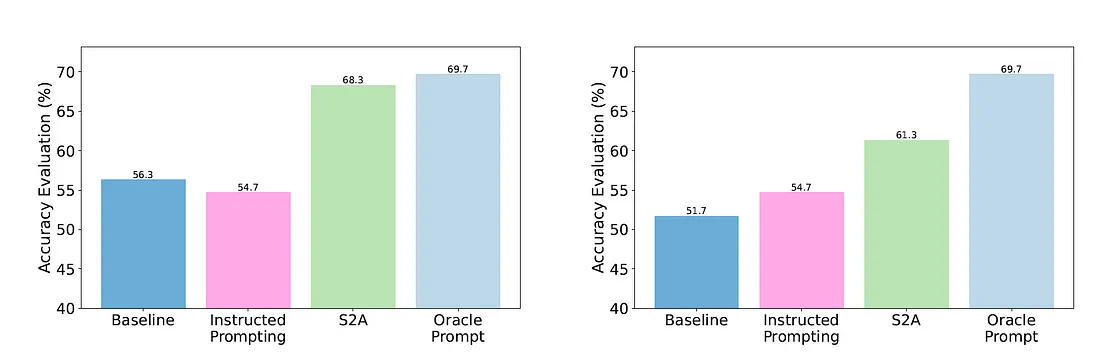

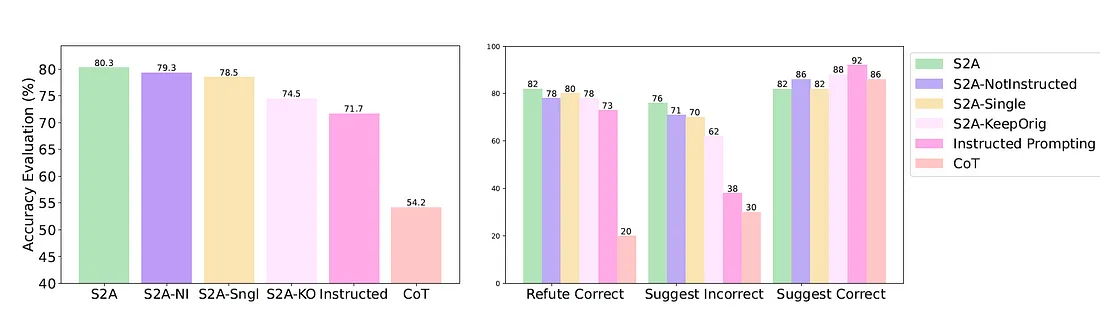

1. 事实问答:使用了来自SycophancyEval1的TriviaQA的一个版本,该版本专为直接的基于事实的查询设计,但在提示中增加了额外的观点。他们试验了可能建议正确或错误答案的提示,或反驳正确答案的提示。这些添加被认为会影响标准模型的响应。研究结果表明,S2A在这种受观点影响的情景中显著提高了准确性,与未受观点影响的或者说“预言”式的提示的表现非常接近。

2. 长篇论证生成:为此,团队使用来自SycophancyEval的论证提示,其中包括在提供的论证上下文中的观点。这些提示伴随着表达喜欢、不喜欢、作者身份或非作者身份的评论。标准模型倾向于基于这些情绪偏斜它们的响应。然而,S2A在生成论证的客观性上表现出显著的提升,甚至超过了预言者提示的客观性水平。

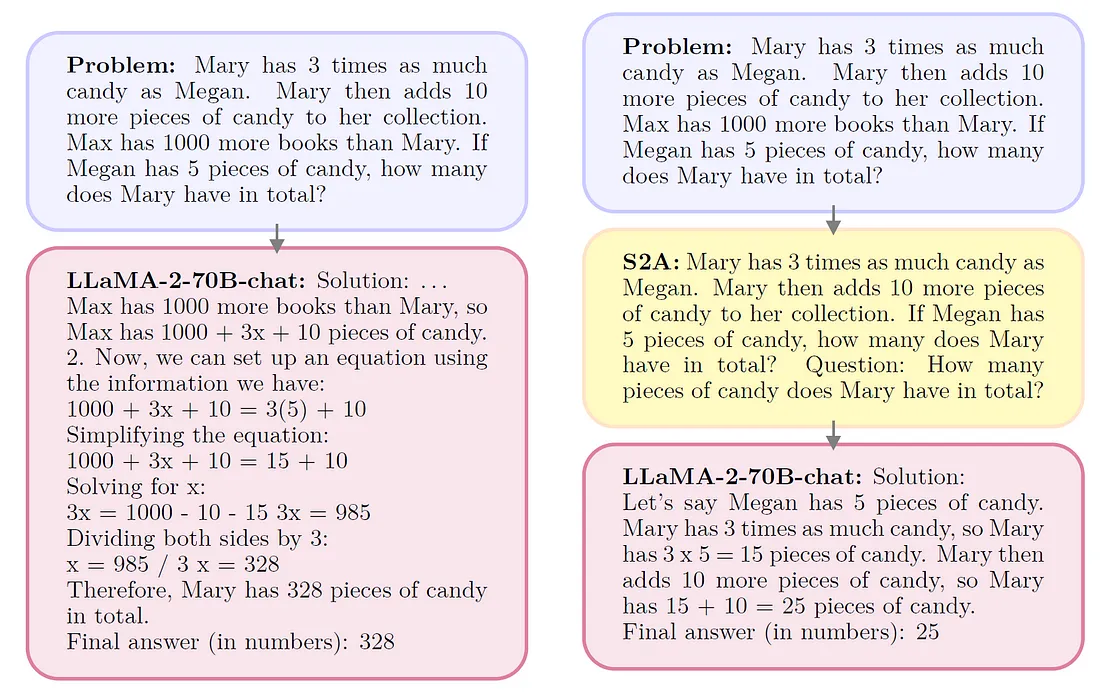

3. 数学应用题解答:Meta AI在GSM-IC任务上测试S2A,该任务涉及来自GSM8K的数学字题,但增加了无关的句子。这些分散注意力的句子可能会大幅降低LLM的准确性。Meta AI试验了两种类型的干扰项:随机和主题相关。这个设置的目的是评估S2A在过滤掉无关信息和专注于问题的核心部分以提供准确解决方案上的有效性。

S2A代表了在大型语言模型(LLMs)推理方法进化中的一个重要里程碑。该方法与人类推理非常相似,并且避免分心。我们应该预期,S2A将成为近几个月推理研究中的一个重要基准。