Stability AI发布StableLM Zephyr 3B:小型高性能聊天语言模型

Stability AI或许最为人所知的是其一系列稳定扩散文本到图像生成AI模型,但这已不是该公司唯一的业务。

近日,Stability AI发布了其最新的模型,StableLM Zephyr 3B,这是一个拥有30亿参数的大型语言模型(LLM),适用于聊天场景,包括文本生成、总结和内容个性化。这个新模型是Stability AI首次在4月谈论的StableLM文本生成模型的一个规模较小、优化后的版本。

StableLM Zephyr 3B的规模比起70亿参数的StableLM模型要小,这带来了一系列好处。模型规模较小使得它可以在更广泛的硬件上部署,降低资源占用的同时还可以提供快速响应。该模型已针对问答和指令遵循类型任务进行了优化。

Stability AI的首席执行官Emad Mostaque说:“StableLM经过了更长时间、更优质数据的训练,例如,与先前的模型相比,使用的标记数量是LLaMA v2 7b的两倍,尽管规模只有其40%,但在基础性能上却与之匹敌。”

关于StableLM Zephyr 3B

StableLM Zephyr 3B并不是一个全新的模型,而是Stability AI将其定义为现有的StableLM 3B-4e1t模型的一个扩展。

Zephyr采用了Stability AI称之为受HuggingFace Zephyr 7B模型启发的设计方法。HuggingFace的Zephyr模型是在开源MIT许可下开发的,旨在充当助手。Zephyr使用了一种被称为直接偏好优化(DPO)的训练方法,StableLM现在也从中受益。

Mostaque解释说,直接偏好优化(DPO)是一种与先前模型中使用的增强学习不同的方法,用于调优模型以满足人类的偏好。DPO通常用于更大的70亿参数模型,而StableLM Zephyr是首批使用该技术的较小的30亿参数模型之一。

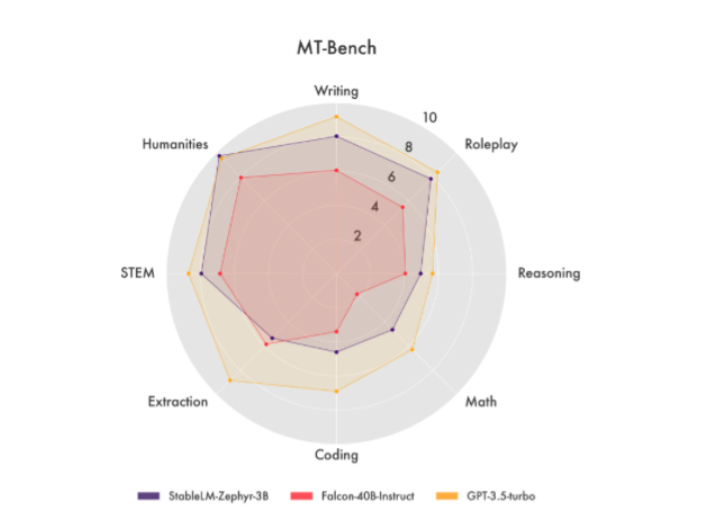

Stability AI使用来自OpenBMB研究组的UltraFeedback数据集进行了DPO。UltraFeedback数据集包括超过64,000个提示和256,000个响应。DPO的结合、较小的规模和优化后的数据训练集为StableLM提供了一些在Stability AI提供的指标中的扎实性能。例如,在MT Bench评估中,StableLM Zephyr 3B能够胜过包括Meta的Llama-2-70b-chat和Anthropric的Claude-V1在内的更大型模型。

Stability AI日益增长的模型套件

StableLM Zephyr 3B加入了Stability AI在近几个月发布的一系列新模型,因为这家生成AI初创公司继续推进其能力和工具的发展。

在8月,Stability AI发布了StableCode,作为一个用于应用程序代码开发的生成AI模型。这次发布在9月被Stable Audio紧随其后,作为一个新的文本到音频生成工具。然后在11月,该公司通过预览Stable Video Diffusion跳入了视频生成领域。

虽然忙于扩展到不同的领域,但新的模型并不意味着Stability AI忘记了它的文本到图像生成基础。上周,Stability AI发布了SDXL Turbo,作为其旗舰SDXL文本到图像稳定扩散模型的更快版本。

Mostaque也非常明确地指出,Stability AI还会有更多的创新来临。

“我们相信,根据用户自己的数据调整的小型、开放、性能出色的模型,将胜过那些更大的通用模型。”Mostaque说。“随着我们全新StableLM模型未来完整发布,我们期待将生成语言模型进一步民主化。”