Mistral AI发布新的开源大模型Mixtral MoE 8x7B

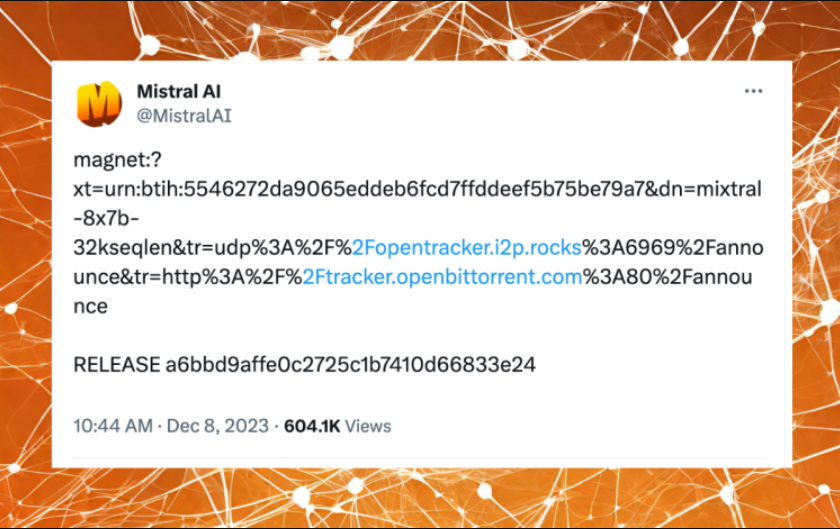

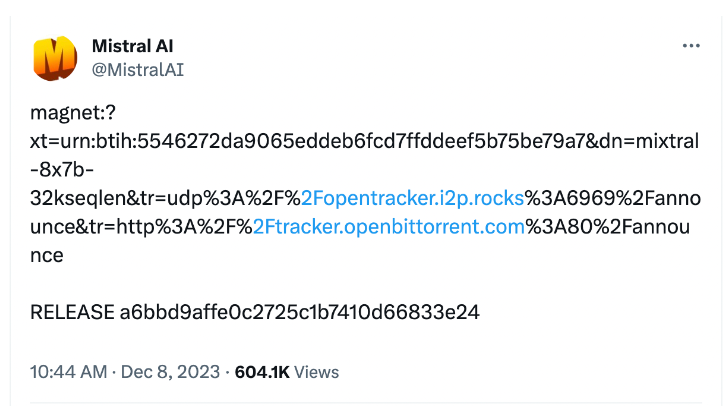

开源模型初创公司Mistral AI仅仅以一个种子链接的方式发布了一款新的LLM(大型语言模型)。

这一行为与本周谷歌发布的Gemini展示了鲜明对比,引发了社区广泛讨论。

谷歌的一个演示视频在过去24小时内由于看起来过度剪辑和预设场景而受到了重度批评。

另一方面,Mistral只是发布了一个种子链接 — 一个用来下载他们的新模型的大型种子文件,这款新模型被命名为MoE 8x7B。

Reddit上的一个帖子描述了Mistral LLM为一个“缩小版的GPT-4”,其出现为基于“一个包含8个7B专家的MoE(Mixture of Experts,专家混合模型)”。该帖继续解释,对于每个词的推断,只使用2个专家,并补充说:“从GPT-4的泄露信息中,我们可以推测GPT-4是一个拥有8个专家的MoE模型,每个专家自己拥有111B参数,以及55B共享注意力参数(每个模型166B参数)。对于每个词元的推断,也同样只使用2个专家。”

AI顾问和“Machine & Deep learning Israel”社区创始人Uri Eliabayev发消息称,Mistral以这种发布方式而“众所周知”,“不附带任何论文、博客、代码或新闻稿。”而开源AI倡导者Jay Scambler也发消息说这种发布方式“绝对不寻常,但我认为这正是其产生如此多话题的目的。”

这种行为立刻被AI社区中的许多人称赞。例如,企业家George Hotz就发表了评论:

而1X Technologies的AI副总裁、谷歌前机器人学研究科学家Eric Jang发文说,Mistral的品牌“已经变成我在AI领域最喜欢的品牌之一。”

Mistral是一家位于巴黎的初创公司,在由Andreessen Horowitz领投的一轮巨额融资中获得了20亿美元的估值,已因其创纪录的1.18亿美元种子轮融资(据说是欧洲历史上最大的种子轮融资)以及其首款大型语言AI模型Mistral 7B(于9月发布)而闻名。