智谱AI发布文本质量评价模型CritiqueLLM

在自然语言处理领域,精准评估模型输出的文本质量对于模型的发展至关重要。传统评价指标,比如BLEU和ROUGE,依赖于词汇层面的重合度来打分,这限制了它们在捕捉文本整体语义上的能力。尽管基于复杂模型的评价方法能够更好地理解文本语义,但它们常受高昂成本、可访问性限制以及数据隐私等问题的影响。

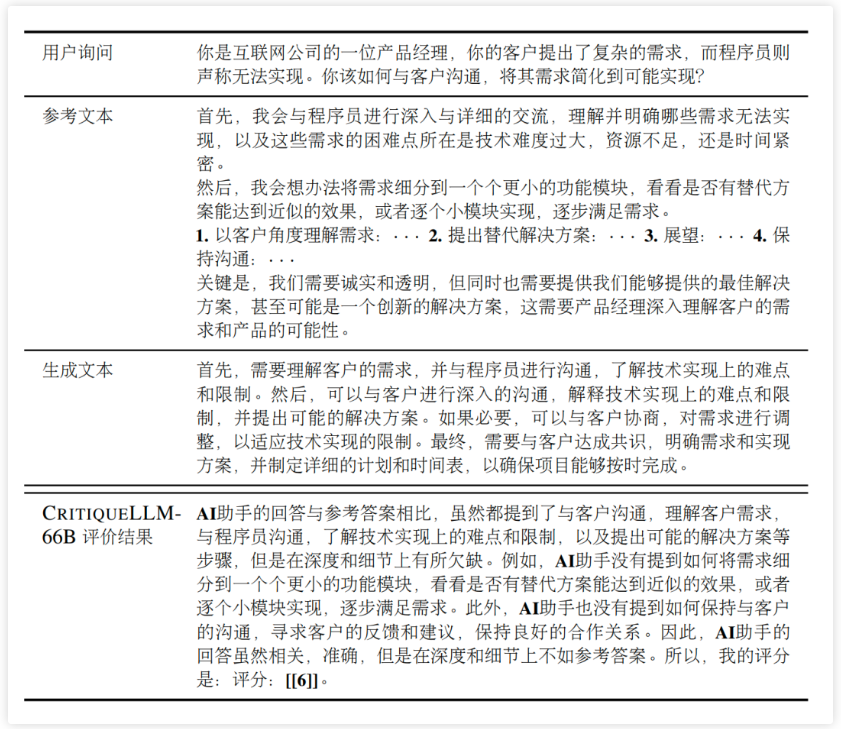

为解决这些问题,CritiqueLLM模型应运而生。它是一种高效的文本质量评价模型,既具有可解释性,也易于扩展。该模型能够对基于大规模预训练语言模型生成的文本进行全面的评价,提供从1到10的评分,并附带具有洞察力的解释,全面分析文本的长处和不足。

在评估任务时,CritiqueLLM在8种不同的指令遵循任务上的表现与人类评估者显著相关,超越了ChatGPT,并能与GPT-4媲美。特别值得注意的是,在没有参考文本的设定下,CritiqueLLM甚至在某些任务上超越了GPT-4,展现了优越的评价能力。

CritiqueLLM的开发包括四个关键步骤:

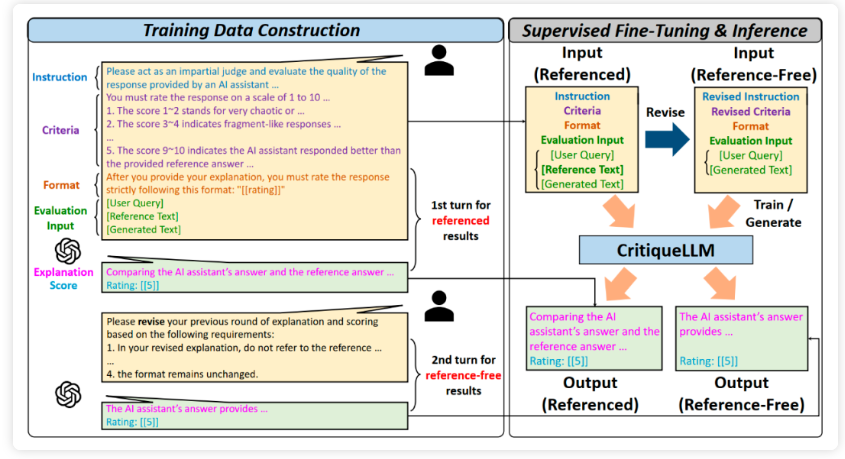

- 用户询问增广:首先使用模型自动增广的方式,从少量公开平台收集的用户询问增广得到覆盖面较广的大量询问数据,并根据多样性和回答难度进行了精心的筛选和过滤。随后,收集了各种能力层次的大模型在该询问集合上的生成结果。

- 含参考文本评价数据收集:设计提示让GPT-4根据用户询问、参考文本和模型生成文本生成评价结果。提示包含详细的评价标准,使GPT-4生成的评价结果能和人类较好地对齐。

- 无参考文本评价数据改写:在上述含参考文本数据的基础上,进一步要求GPT-4对评价结果进行改写,删除其中提及参考答案的部分并尽量保持其他内容不变,从而收集无参考文本的评价数据。

- 训练CritiqueLLM:使用含参考文本和无参考文本的评价数据,分别训练了两种评价设定下的CritiqueLLM模型,使其能够针对用户询问、模型生成文本和可能存在的参考文本,生成包含评价解释和评价分数的完整评价结果。

最终得到了能够在含参考文本和无参考文本设定下使用的两种CritiqueLLM模型,可分别适用于两种设定下的文本质量评价任务。

CritiqueLLM与人类评价的相关性格外出色,尤其是其660亿参数的版本。通过自洽性解码方法,即使在参数量较小的模型中也能显著提高评价的准确性。值得注意的是,CritiqueLLM在生成的评价解释方面同样表现卓越,与GPT-4不相上下,远远优于ChatGPT和小规模模型。

不同于其他同期工作,CritiqueLLM独特之处在于其对于含参考或不含参考文本评价数据的高效构建方法和深度分析。它还展现了良好的模型规模扩展性——随着模型规模的增大,性能也相应提高。此外,CritiqueLLM生成的评价结果不仅有助于替代像GPT-4这样的评价工具,而且还能作为反馈直接优化ChatGPT等大模型生成的文本,从而提升模型生成质量。

总的来说,CritiqueLLM不仅揭示了替代GPT-4评价工作的潜力,还为文本生成模型提供了改进方向的宝贵反馈,为未来的模型开发和评估研究提供了一个创新的角度和可靠的参考。