微软正式发布27亿参数的Phi-2小规模语言模型

微软发布了Phi-2,这是一款27亿参数的语言模型,首次亮相是由CEO Satya Nadella在上个月的Ignite大会上宣布的。Phi-2展示了通常只有在至少大5到25倍体积的模型中才看到的非凡能力。在不超过130亿参数的基础语言模型中,Phi-2在衡量推理、语言理解、数学、编码和常识的复杂基准测试中展示了最先进的性能。

Phi-2之所以有惊人的能力,归功于微软对高质量训练数据的重视,以及在有效扩大模型知识方面的创新。微软通过在精心策划的旨在传授知识的“教科书质量”数据上进行培训,结合从较小模型传递学习见解的技术,Phi-2打破了常规的规模定律。

传统上,语言模型的能力与它们的大小紧密相连,更大的模型拥有更令人印象深刻的能力。然而,Phi-2推翻了这一观念。它不仅匹配,而且在某些情况下,甚至超过了体量大25倍的模型。

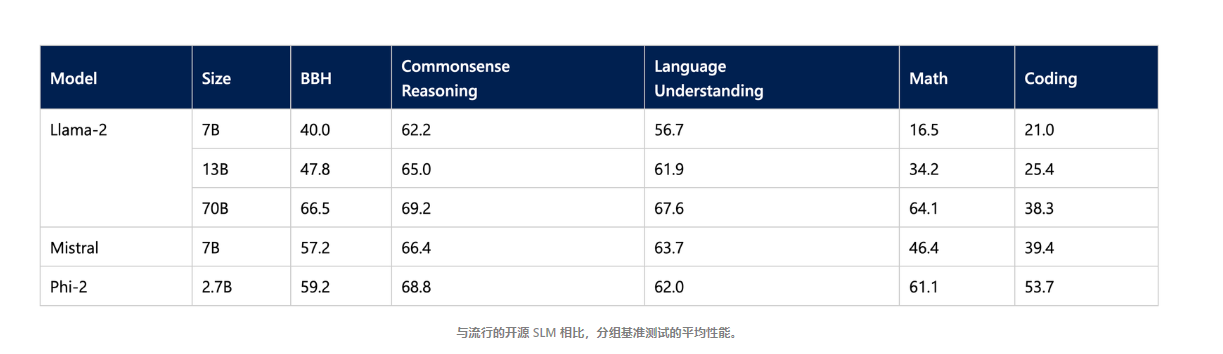

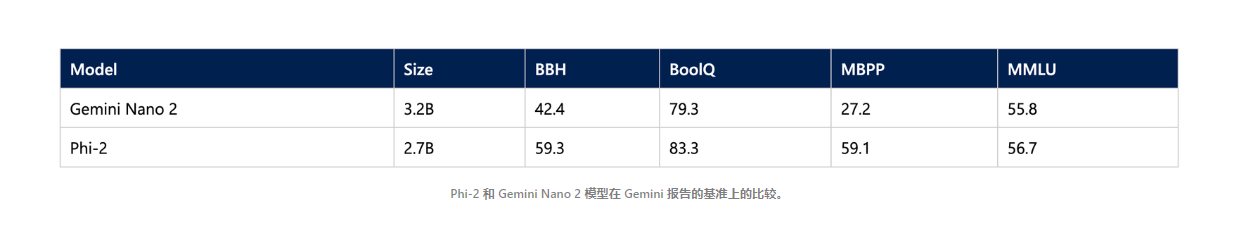

Phi-2在选择的基准测试中匹配或超过了如7B Mistral、13B Llama-2,甚至70B Llama-2这样的大模型。它还在性能上匹配或超越了最近宣布的谷歌Gemini Nano 2,尽管它在大小上更小。测试是广泛的,包括推理任务、语言理解、数学、编码挑战等。

微软将Phi-2在小规模下的性能归功于两个关键点:

- 训练数据的质量在模型能力中发挥着关键作用。通过专注于高质量的"教科书"数据,这些数据是专门针对教授推理、知识和常识的,Phi-2从较少的数据中学到了更多。

- 从小型模型嵌入知识的技术帮助有效规模化模型见解。微软从1.3B参数的Phi-1.5开始,使用知识转移等方法成功解锁了2.7B参数的Phi-2出人意料的强大能力,而不需要指数级更多的数据。

值得注意的是,尽管Phi-2没有经过强化学习来自人类反馈或指令性微调等对齐技术的改善,但它在减少毒性和偏见方面仍然展示出优越的安全性,并且与使用了对齐策略的其他可用开源模型相比较。微软表示,这种改进的行为来自于他们量身定制的数据策划方法。通过单独选择数据来开发能力强大且更安全的模型的能力对行业持续处理问题模型输出等风险具有积极的意义。

Phi-2的效率使其成为研究者探索关键模型开发(如提升可解释性、安全性和语言模型的道德发展)的理想平台。微软已经在Azure模型目录上发布了对Phi-2的访问权限,以促进此类研究,同时促进自然语言处理的新应用。