设计和实现流数据管道:基于Python的综合数据和可视化方法

2023年12月13日 由 alex 发表

990

0

介绍

流数据管道指的是用于摄取、处理和分析持续高速生成的数据的系统和过程。这与传统的批处理系统形成对比,后者是在预定时间间隔内处理数据的离散块。物联网(IoT)、社交媒体和在线交易的兴起导致了流数据量的激增。流数据管道是现代数据架构的关键组成部分,为实时数据处理和分析提供了支持。这些管道旨在处理连续的数据流,使企业和组织能够根据最新信息及时做出决策。本文探讨了流数据管道的概念、组成部分、优势、挑战及其潜在应用。

流数据管道的组成要素

典型的流数据管道包含几个关键组件:

- 数据源:包括传感器、日志、社交媒体数据源和其他实时数据生成器。

- 摄取层:负责捕获和将数据导入系统。在这个阶段经常使用的技术包括Apache Kafka和Amazon Kinesis。

- 处理层:这一层应用业务逻辑、过滤、聚合和转换数据。这里使用的流处理框架如Apache Flink和Apache Storm。

- 存储层:处理后的数据存储在数据库或数据湖中,以便进一步分析。这可能涉及到系统如Apache Hadoop、NoSQL数据库或云存储解决方案。

- 分析和可视化:最后一步是分析处理后的数据,并通过仪表板或报告进行可视化,以获得可行的洞见。

流数据管道的优势

流数据管道的优点众多:

- 实时洞见:它们提供了实时分析数据和做出决策的能力。

- 可伸缩性:这些系统设计用来高效处理大量数据。

- 灵活性:它们可以处理各种数据格式和类型。

- 改善客户体验:实时数据处理可以增强客户互动和服务。

实施流数据管道的挑战

尽管流数据管道有其优势,也面临着一些挑战:

- 复杂性:设计和维护一个流管道可能很复杂,需要专业知识。

- 数据质量和管理:确保实时数据的准确性和一致性是困难的。

- 与现有系统集成:将流数据管道与遗留系统集成可能具有挑战性。

流数据管道的应用

流数据管道有广泛的应用范围:

- 金融服务:用于欺诈检测和高频交易。

- 电信:用于网络监控和优化。

- 零售:用于实时库存管理和个性化客户体验。

- 医疗保健:用于监控病人数据和关键护理系统。

代码

用Python创建一个完整的流数据管道示例包括几个步骤,包括生成一个合成数据集、配置一个流管道,以及可视化处理后的数据。以下是一个全面的指南和代码片段,帮助你使用Python设置一个基本的流数据管道。

import pandas as pd

import numpy as np

import time

import random

import matplotlib.pyplot as plt

# Generate a synthetic dataset

def generate_data(num_entries):

timestamps = pd.date_range(start="2023-01-01", periods=num_entries, freq="S")

temperatures = np.random.normal(loc=20, scale=5, size=num_entries) # Normal distribution

return pd.DataFrame({'timestamp': timestamps, 'temperature': temperatures})

def stream_data(dataframe):

for _, row in dataframe.iterrows():

new_data = row.to_dict()

yield new_data

time.sleep(random.uniform(0.1, 0.5)) # Simulate data streaming delay

def process_data(data):

data['temperature_f'] = data['temperature'] * 9/5 + 32

return data

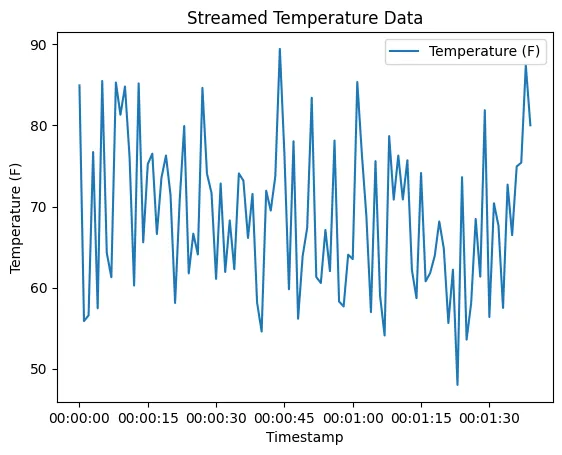

def plot_data(processed_data):

plt.plot(processed_data['timestamp'], processed_data['temperature_f'], label='Temperature (F)')

plt.xlabel('Timestamp')

plt.ylabel('Temperature (F)')

plt.title('Streamed Temperature Data')

plt.legend()

plt.show()

# Generate the dataset

dataset = generate_data(100) # 100 data points

# Stream and process data

processed_data = pd.DataFrame()

for data in stream_data(dataset):

processed_data = processed_data.append(process_data(data), ignore_index=True)

# Visualize the processed data

plot_data(processed_data)

这段代码创建一个合成数据集,仿佛实时地流式传输它,处理每一个数据点,然后绘制结果。请记住,这是一个基本示例,用于演示目的。在现实世界场景中,你需要一个更复杂的设置,特别是在处理更大数据量和更复杂的处理需求时。

结论

流数据管道代表着当今快节奏数字世界中数据处理和利用方式的重大转变。随着技术的不断发展,这些管道将变得更加复杂,提供更深层次的洞察,并驱动各个行业的创新。然而,企业必须应对在实施和维护这些系统时涉及的复杂性和挑战,以充分收获其优势。总之,流数据管道是现代数据生态系统的重要组成部分,它能够实现实时数据处理和分析,这可以改变组织的运作方式和决策方式。

文章来源:https://medium.com/ai-mind-labs/designing-and-implementing-streaming-data-pipelines-a-python-based-approach-with-synthetic-data-3fe618f3055a

欢迎关注ATYUN官方公众号

商务合作及内容投稿请联系邮箱:bd@atyun.com

热门企业

热门职位

写评论取消

回复取消