微软展示新提示技术 助力拓展前沿AI模型潜能

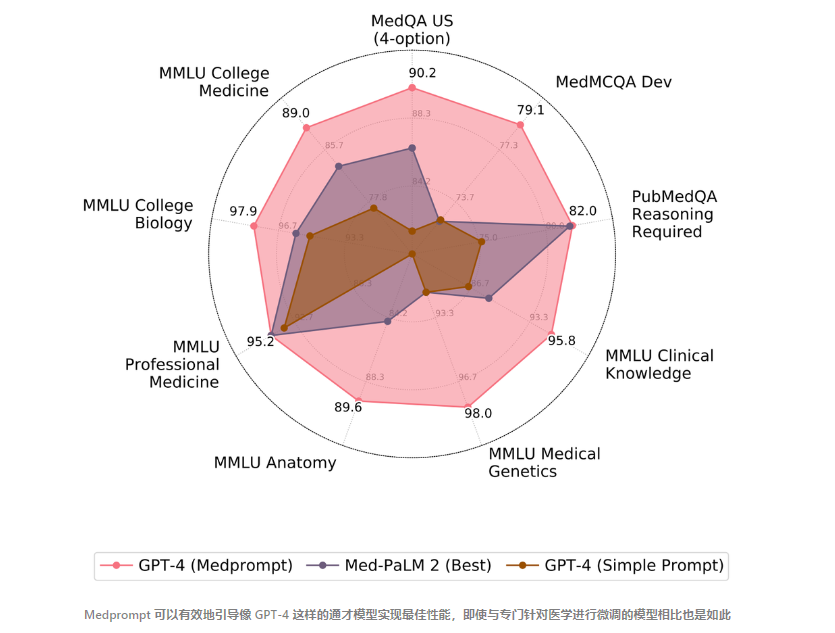

微软研究人员开发了一种先进的提示技术,以更好地指导OpenAI强大的GPT-4语言模型,从而在关键的AI基准测试上取得了最先进的表现。

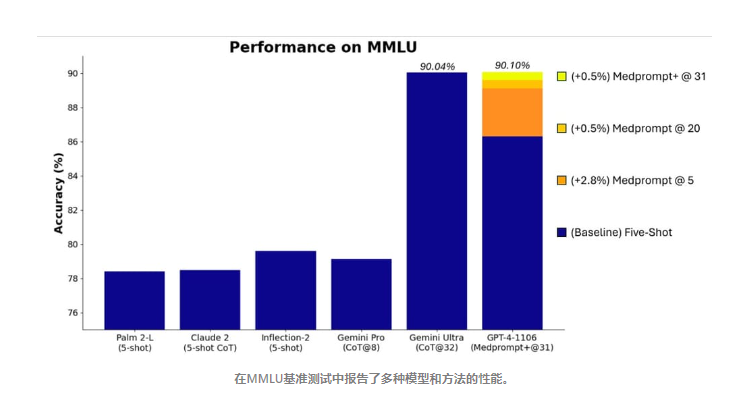

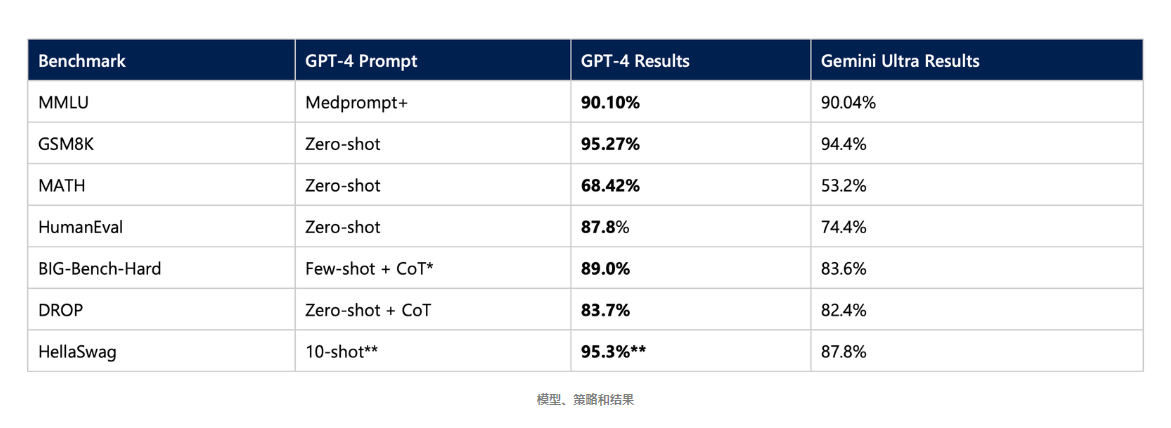

研究人员专注于公认的 MMLU 基准测试,该测试覆盖了从数学到医学的 57 个不同知识领域。通过修改原本为医疗问题设计的一种叫做Medprompt的方法,团队获得了有史以来最高的MMLU得分——90.10%。

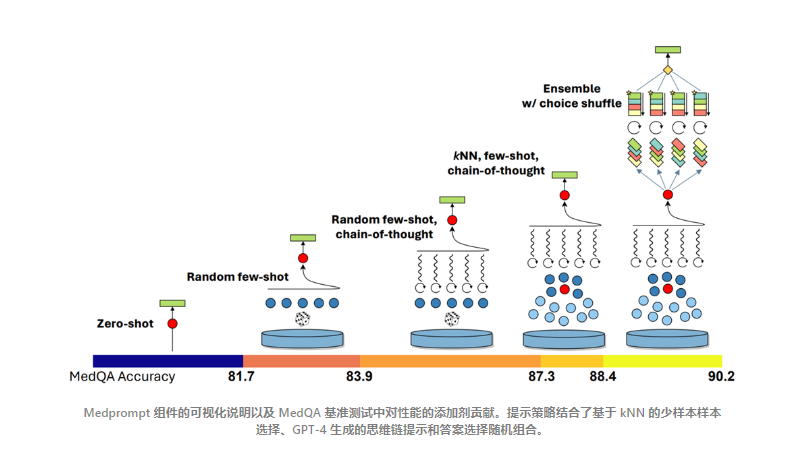

Medprompt结合了三种不同的提示策略:

- 动态少数示例选择(Dynamic few-shot selection)

- 自生成思维过程链(Self-generated chain of thought)

- 选择混洗组合(Choice-shuffle ensembling)

首先,动态少数示例选择利用了少数示例学习的能力,快速适应特定领域。这种方法巧妙地为不同的任务输入选择不同的少数示例,增强了相关性和表征。

第二种策略涉及到自生成的思维过程链。这种方法提示模型生成中间推理步骤,提高了解决复杂推理任务的能力。与依赖人工编写示例的传统方法不同,Medprompt自动化了这一过程,降低了错误推理路径的风险。

最后,多数投票组合策略通过结合来自不同算法的输出来提高预测性能。这包括一个针对多项选择题的独特技巧,叫做选择混洗,提高了模型响应的鲁棒性。

虽然最初专为医学领域设计,但微软发现,Medprompt细致的提示方法很好地转移到了广泛的学科领域,当应用于全面的MMLU(衡量大规模多任务语言理解)基准测试时可以看出这一点。在GPT-4上应用Medprompt的原始成果在MMLU上取得了令人印象深刻的89.1%的得分。然而,通过增加集成调用的数量和整合一个更简单的提示方法与原始策略并行,他们开发了 Medprompt+。

Medprompt+实现了里程碑式的表现, 在MMLU上取得了创纪录的90.10%得分。这得益于同时整合来自基础Medprompt策略的输出和简化提示的输出,并由一个控制策略引导,该策略利用了推断出的候选答案的置信度。值得注意的是,这种方法利用了GPT-4能够访问置信度分数(logprobs)的能力,这是一个即将公开可用的功能。

微软还开源了promptbase,这是一个不断发展的资源集合、最佳实践和示例脚本,用于从像GPT-4这样的基础模型中引出最佳性能。目标是降低研究人员和开发者利用模型潜力进行优化提示的障碍。

与即将于明年推出的谷歌最新AI系统Gemini Ultra相对照,微软在GPT-4上的提示创新获得了额外的重要性。谷歌宣布的Gemini Ultra(实际上要到明年才能使用)的公告伴随着一个备受争议的演示视频,该视频最初因其描绘的实时AI交互而受到赞誉,但后来谷歌承认视频是使用静态图像和文本提示编排的,而不是它所描述的动态、实时互动。

现在,微软的提示创新已将GPT-4的能力扩展到超出与明年推出的Gemini Ultra时预期的能力。在所有流行的基准测试上,提示后的GPT-4现在显著超过了来自Gemini Ultra的预期结果。

随着GPT-4在得到适当指导时已展现出类似于主题专家的智能,这一里程碑表明了这些模型非凡的自然语言能力,以及通过更复杂的提示进一步扩展其能力的有希望的机会。微软的最新进展强调了随着AI模型的进步,更好的提示策略很可能是将这些强大工具引导向可靠、合乎伦理和有益结果的关键。