如何使用Mistral AI的混合专家模型Mixtral-8x7B

上周,法国创业公司Mistral AI不仅筹集了4.15亿美元的资金,还推出了一款全新的稀疏混合专家模型Mixtral-8x7B,并宣布了其新平台服务的测试版发布。

Mixtral-8x7B在大多数基准测试中都超过了Llama 2 70B模型,同时提供了六倍更快的推理速度。而且,它是一个开放权重的模型,以 Apache 2.0许可证发布,这意味着任何人都可以访问和使用它来完成自己的项目。

如果你是一位经验丰富的研究人员或开发人员,那么您可以直接使用Mistral提供的磁力链接来下载种子文件。这个下载包括了 Mixtral 8x7B和Mixtral 8x7B Instruct。

magnet:?xt=urn:btih:5546272da9065eddeb6fcd7ffddeef5b75be79a7&dn=mixtral-8x7b-32kseqlen&tr=udp%3A%2F%http://2Fopentracker.i2p.rocks%3A6969%2Fannounce&tr=http%3A%2F%http://2Ftracker.openbittorrent.com%3A80%2Fannounce

RELEASE a6bbd9affe0c2725c1b7410d66833e24使用Mistral AI平台

如果你还没有这样做,那么现在可能是一个好时机,去注册Mistral的AI平台的测试版访问权限,你将能够通过API轻松地访问模型。如果你有商业用例,只需联系该公司,Mistral团队将与你合作并加快访问速度。注意,Mixtral-8x7B模型可以在mistral-small 端点后面找到。作为奖励,你还将获得mistral-medium的访问权限,这是他们目前最强大的模型。

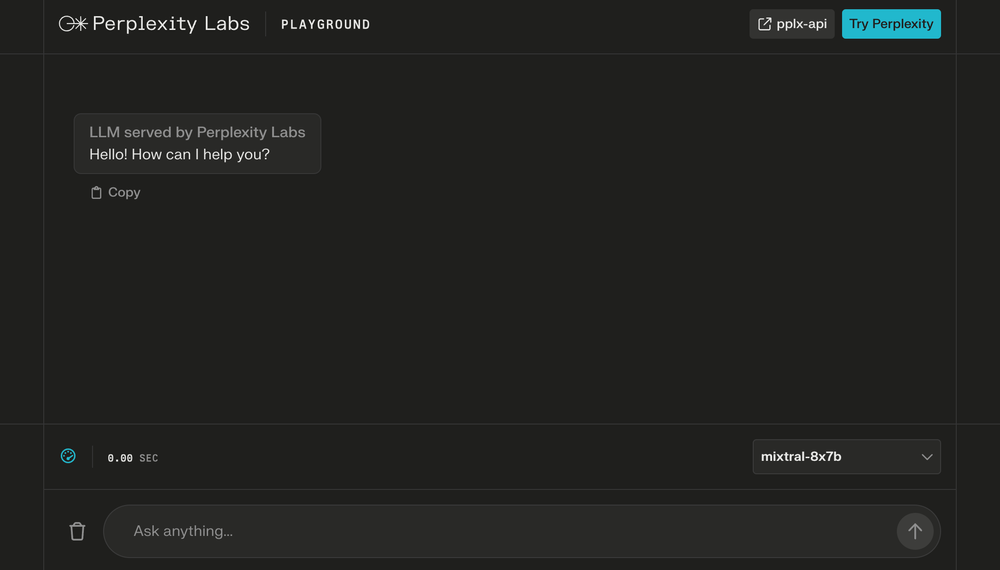

使用Perplexity Labs

如果你只想通过聊天界面使用指令调整版本,你可以使用Perplexity Labs的游乐场。只需在右下角的模型选择下拉菜单中选择它。

使用 Hugging Face

Hugging Face既有基础模型,也有指令微调模型,它们都可以用于基于聊天的推理。

- Mixtral-8x7B-v0.1

- Mixtral-8x7B-Instruct-v0.1

有一些可以直接使用的检查点,可以通过HuggingFace Hub下载和使用,或者你可以将原始检查点转换为HuggingFace格式。Mixtral-8x7B-Instruct-v0.1模型也可以在Hugging Face Chat上使用。只需将它作为你的模型选择即可。

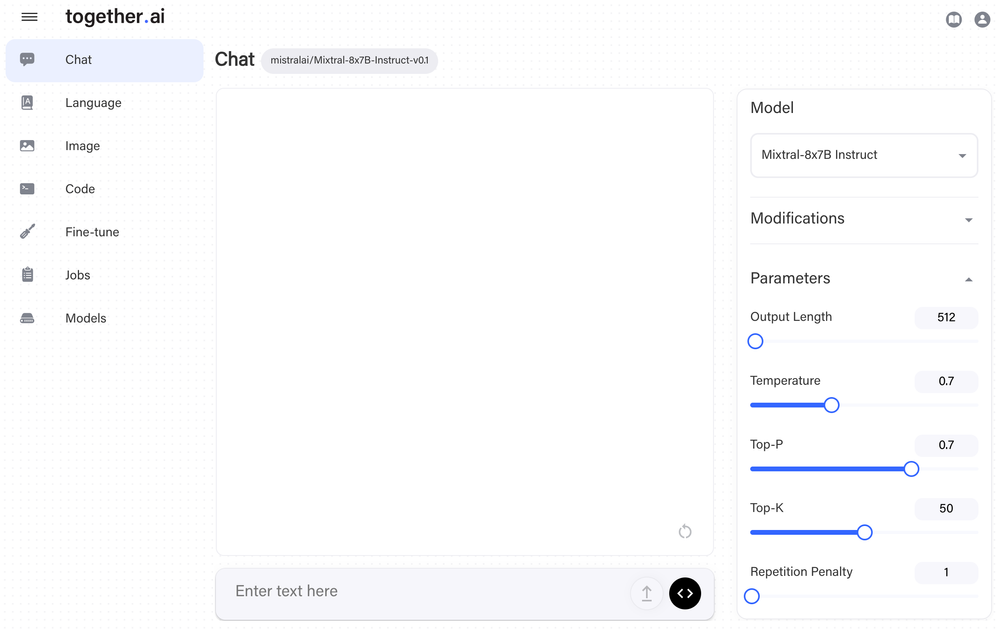

使用Together.AI

Together 提供了一个最快的推理堆栈,通过 API 可以轻松访问。毕竟,他们是 FlashAttention 的幕后团队。

他们针对Mixtral优化了Together推理引擎,可以以每秒100个令牌的速度提供服务,每1000个令牌只需0.0006美元。你可以通过游乐场或他们的API访问DiscoLM-mixtral-8x7b-v2和Mixtral-8x7b。

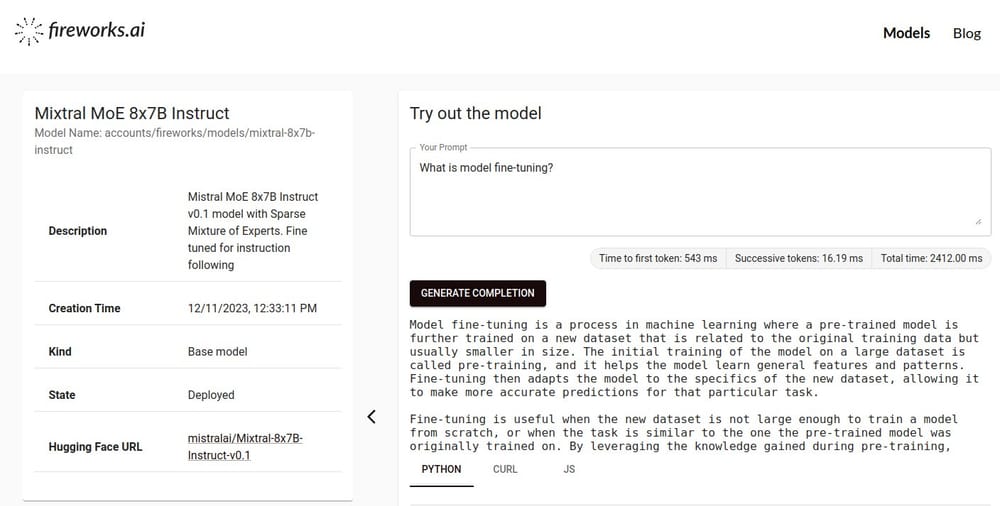

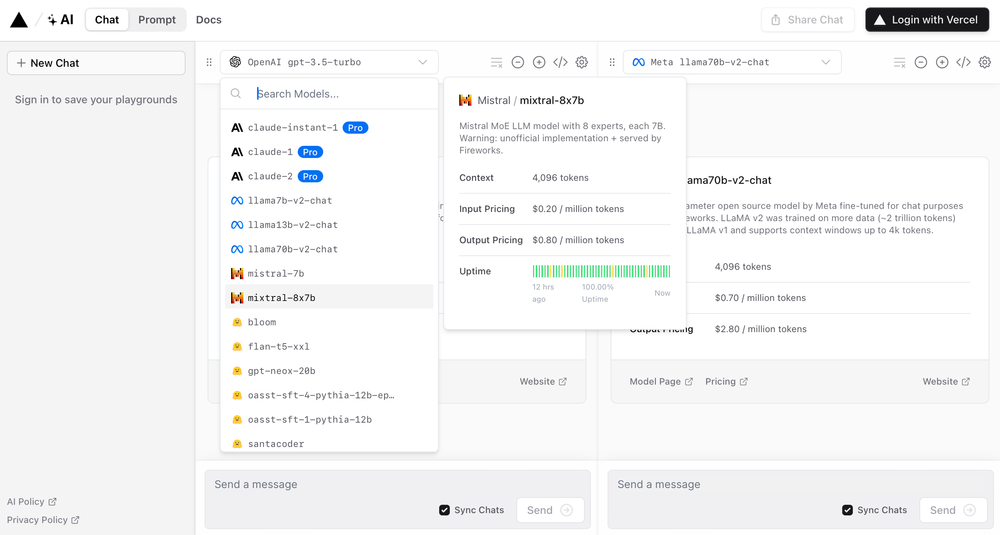

使用Fireworks生成式AI平台

Fireworks是另一个方便的选择。该平台旨在为开发者提供快速、经济和可定制的开源LLMs。登录后,只需搜索mixtral-8x7b-instruct模型即可开始使用。

注意,你也可以通过其他平台,如Vercel,访问Fireworks托管的模型。

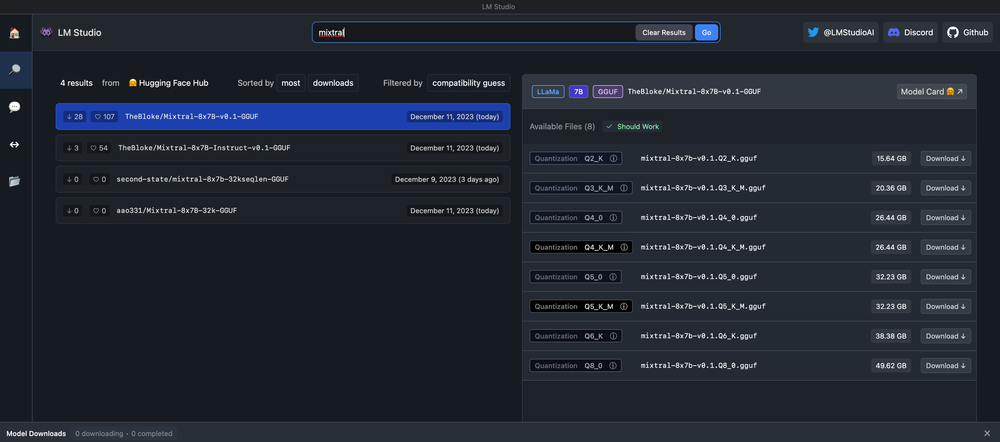

在本地使用LM Studio运行

LM Studio是在 Mac、Windows 或 Linux 计算机上本地离线运行模型的最简单的方法之一。LM Studio得益于llama.cpp项目,支持Hugging Face上的任何ggml Llama、MPT和StarCoder模型。

只需下载并安装LM Studio,然后搜索Mixtral即可找到兼容的版本。