利用深度学习中的稀疏性:稀疏神经网络及其影响之旅

2023年12月15日 由 alex 发表

2124

0

介绍

深度学习已经在人工智能的许多领域带来了革命性的变革,这要归功于其从大型数据集中学习复杂模式的能力。在众多促进深度学习模型有效性的方法和机制中,强化稀疏性(sparsity-enforcing)算法的概念尤为突出。本文深入探讨了强化稀疏性算法在深度学习中的作用,探索了它们的原理、应用以及意义。

在深度学习中理解稀疏性

稀疏性,在深度学习的背景下,是指设计模型时只使用少数重要特征或神经元,同时忽略不太相关的特征。这种方法反映了人类大脑处理信息的方式:不是所有神经元都同时活跃;相反,通常只有一小部分神经元集合在特定任务中被激活。

稀疏性算法的原则

- 特征选择:这些算法有助于从大型数据集中选择最相关的特征。通过专注于更少、更重要的特征,模型可以提高其学习效率和泛化能力。

- 正则化技术:像L1正则化这样的技术鼓励神经网络中的权重系数为零,导致模型更简单且更容易解释。这种正则化方法本质上是稀疏性的。

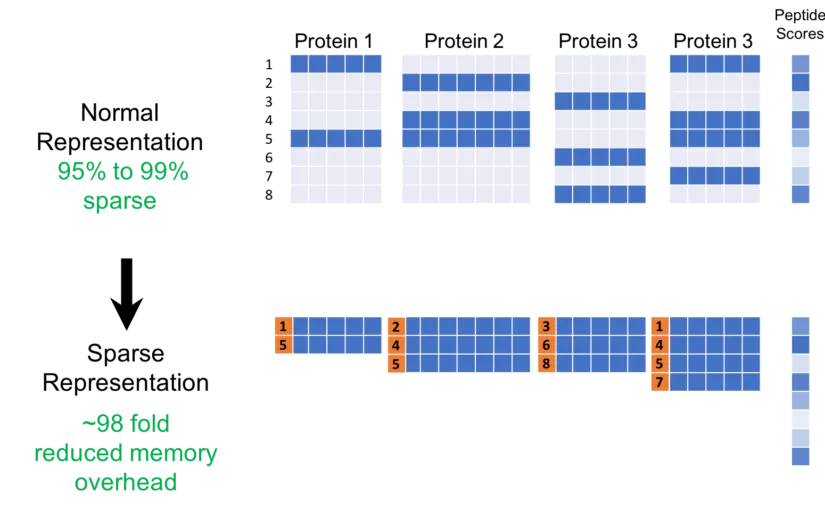

- 计算效率:稀疏模型需要更少的计算,因为在任何给定的时间只有一部分神经元或特征被激活。这导致了减少的复杂性和更快的处理时间。

深度学习应用

- 计算机视觉:在图像识别等任务中,稀疏性算法有助于识别并专注于图像的最关键特征,从而提高准确性并减少计算负载。

- 自然语言处理(NLP):在文本分类或情感分析等NLP任务中,稀疏性有助于专注于关键词或短语,忽略不太相关的信息。

- 推荐系统:这些系统通过专注于一小部分高度相关的项目来推荐,而不是考虑整个库存,从而受益于稀疏性。

稀疏性的优点

- 提升性能:通过减少过拟合并专注于关键特征,稀疏性可以导致模型在未见数据上表现更好。

- 可解释性:稀疏模型通常更容易解释和理解,因为它们依赖于更少、更有意义的特征。

- 效率:稀疏模型需要更少的内存和计算能力,使其更加高效和环保。

挑战与限制

- 识别相关特征:确定哪些特征确实相关可能是具有挑战性的,特别是在复杂数据集中。

- 平衡稀疏性和准确性:过多的稀疏性可能导致欠拟合,即模型未能捕捉数据中的重要模式。

- 实现复杂性:实施和微调稀疏性算法可能是复杂的,并需要专业知识。

未来展望

随着深度学习的不断发展,稀疏性算法的集成可能会变得更加成熟。未来的研究可能会专注于开发更先进的自动特征选择技术和平衡稀疏性与模型准确性。此外,边缘计算的兴起以及移动和物联网(IoT)设备中对轻量级模型的需求将进一步推动深度学习中稀疏性的重要性。

代码

使用Python创建一个完整的实施稀疏性的深度学习模型,包括多个步骤,例如生成合成数据集、构建模型和绘制结果。在这个例子中,我们将使用Python库,如NumPy用于数据操纵,TensorFlow和Keras用于构建神经网络,以及Matplotlib用于绘图。

import numpy as np

import matplotlib.pyplot as plt

from sklearn.model_selection import train_test_split

# Generate synthetic data

np.random.seed(0)

X = np.random.rand(1000, 10) # 1000 samples, 10 features

true_weights = np.array([0.5, -0.2, 0.1, 0, 0, 0, 0, 0, 0, 0]) # Only 3 features are informative

y = X @ true_weights + np.random.normal(0, 0.1, 1000) # Linear combination + noise

# Split the dataset into training and testing sets

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=0)

import tensorflow as tf

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import Dense

from tensorflow.keras.regularizers import l1

# Build a neural network model with L1 regularization

model = Sequential([

Dense(64, activation='relu', input_shape=(X_train.shape[1],),

kernel_regularizer=l1(0.01)), # L1 regularization

Dense(1)

])

model.compile(optimizer='adam', loss='mse')

history = model.fit(X_train, y_train, epochs=100, validation_split=0.2, verbose=0)

test_loss = model.evaluate(X_test, y_test)

print("Test Loss:", test_loss)

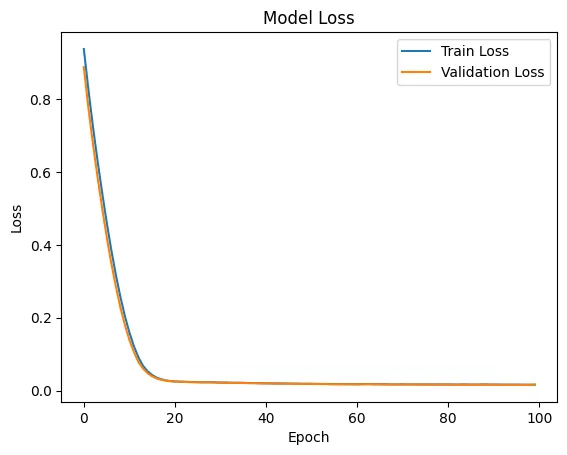

plt.plot(history.history['loss'], label='Train Loss')

plt.plot(history.history['val_loss'], label='Validation Loss')

plt.title('Model Loss')

plt.ylabel('Loss')

plt.xlabel('Epoch')

plt.legend()

plt.show()

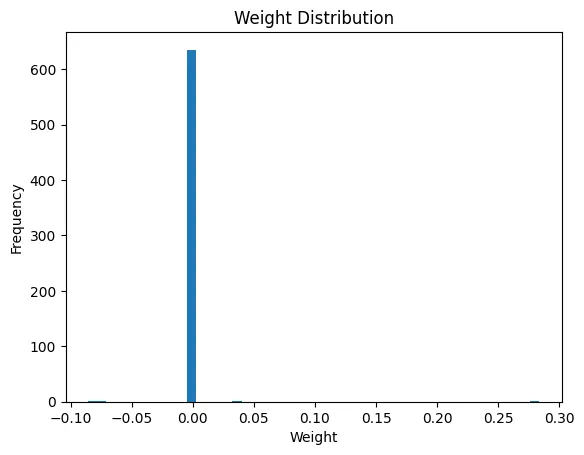

weights, biases = model.layers[0].get_weights()

plt.hist(weights.flatten(), bins=50)

plt.title('Weight Distribution')

plt.xlabel('Weight')

plt.ylabel('Frequency')

plt.show()

这段完整的代码为实现通过L1正则化强制稀疏的深度学习模型提供了一个框架。合成数据集很简单,因此对于更复杂的情况,你可能需要调整数据生成过程和模型架构。

Test Loss: 0.01679409295320511

结论

总之,在深度学习领域中,稀疏性强制算法扮演着至关重要的角色,它们在性能、可解释性和效率方面提供了好处。虽然在实现这些算法时存在挑战,但它们在改进深度学习模型的潜力是巨大的,这使得它们成为未来研究和开发的重点领域。

文章来源:https://medium.com/@evertongomede/harnessing-sparsity-in-deep-learning-a-journey-through-sparse-neural-networks-and-their-impact-2ac62f7bea36

欢迎关注ATYUN官方公众号

商务合作及内容投稿请联系邮箱:bd@atyun.com

上一篇

使用RAGA评估RAG应用

热门企业

热门职位

写评论取消

回复取消