研究揭示GPT-4抽象推理仍不及人类水平

当前有一个关于大型语言模型(LLM),如 GPT-4 是否真正模仿人类逻辑和推理的辩论。一些研究人员认为,随着规模的扩大,LLM 可能会发展出对抽象推理、模式识别和类比制造的新兴能力。

其他人则认为,支持这些能力的内部工作机制仍然未被解释。一些实验显示,这些模型未能超越其训练数据的范围进行泛化。

“创造和推理抽象表征的能力是稳健泛化的基础,因此了解 LLM 在多大程度上实现了这些能力至关重要。”圣塔菲研究所的科学家们在一篇最近的论文中写道。

在他们的研究中,研究人员探讨了抽象推理的含义,并提供了一种评估 LLM 中抽象推理能力的框架。研究结果显示,尽管 GPT-4 及其多模态对应产品 GPT-4V 非常复杂,但它们在抽象推理水平上仍未达到人类水平。

抽象推理是什么?

抽象推理是从稀疏数据中辨别出规则或模式并将其推广到新场景的能力。这种特性是人类智力的基石——儿童在从最少的示例中学习抽象规则方面表现出熟练的能力。

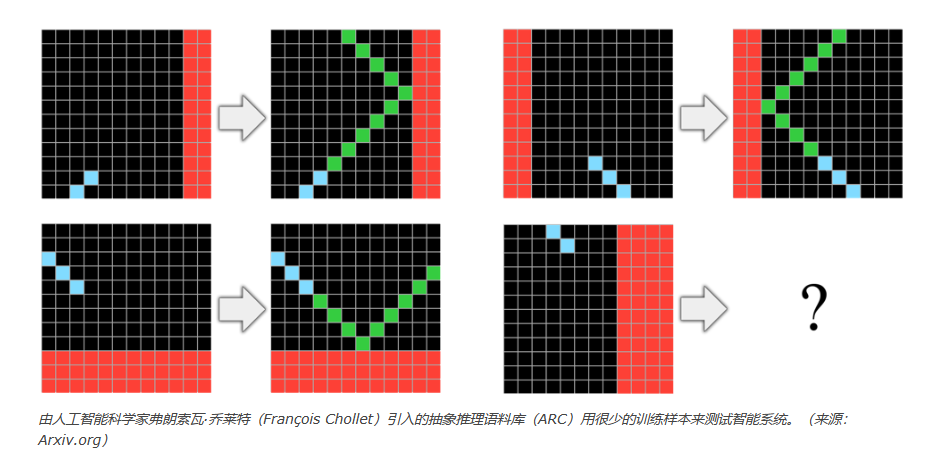

评估抽象推理能力是困难的。一个公平的衡量标准是 Francois Chollet 的抽象与推理语料库(ARC)。ARC 是一个评估人类和 AI 中抽象推理的框架。该测试包含 1,000 个手工制作的类比谜题,每个谜题呈现几个网格转换的示例以及一个最终的、不完整的网格,解题者必须正确填充。这些谜题的设计是为了消除任何不公平的优势,例如与训练数据的相似性或依赖外部知识。

为了解决这些谜题,人必须从几个示例中推断出整体抽象规则并将其应用于测试格。解决ARC所需的基础知识被认为是人类天生具有的,包括像对象识别、数量评估以及几何和拓扑的基本原则。

“[ARC] 旨在抓住抽象推理的核心:从少量示例中归纳出一般规则或模式,并灵活地将这些规则应用于新的、以前未见过的情况。”研究人员在他们的论文中写道。

人类在 ARC 上的表现停留在大约 84% 左右。与此相反,利用当前 AI 系统进行 ARC 测试的尝试令人失望。一个著名的Kaggle竞赛的顶尖参赛作品,采用程序合成技术,只解决了这些谜题中的 21%,并且没有能力超出其狭隘范围进行泛化。号称通用问题解决者的 LLM 在最近的实验中在 ARC 挑战中的表现甚至更差,只解决了 10-12%。

在推理任务上测试 GPT-4

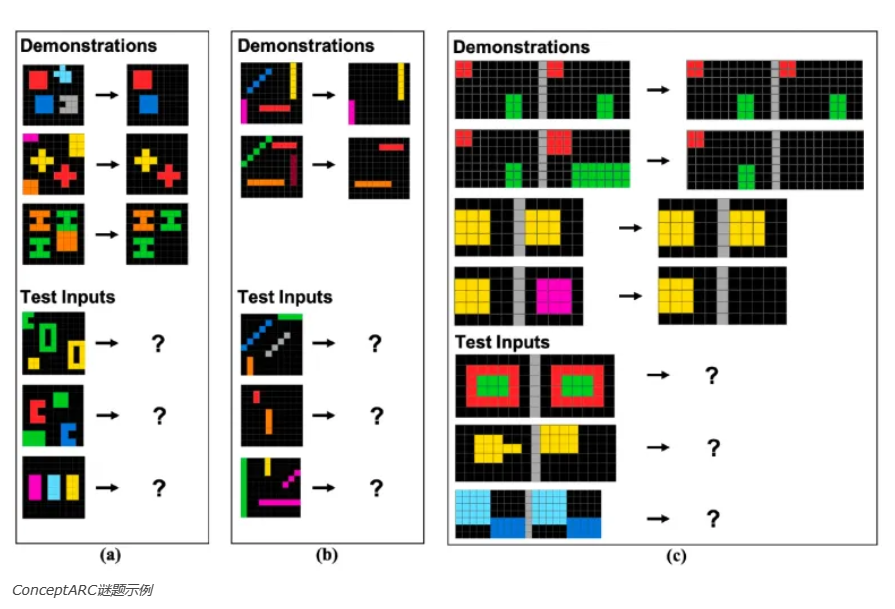

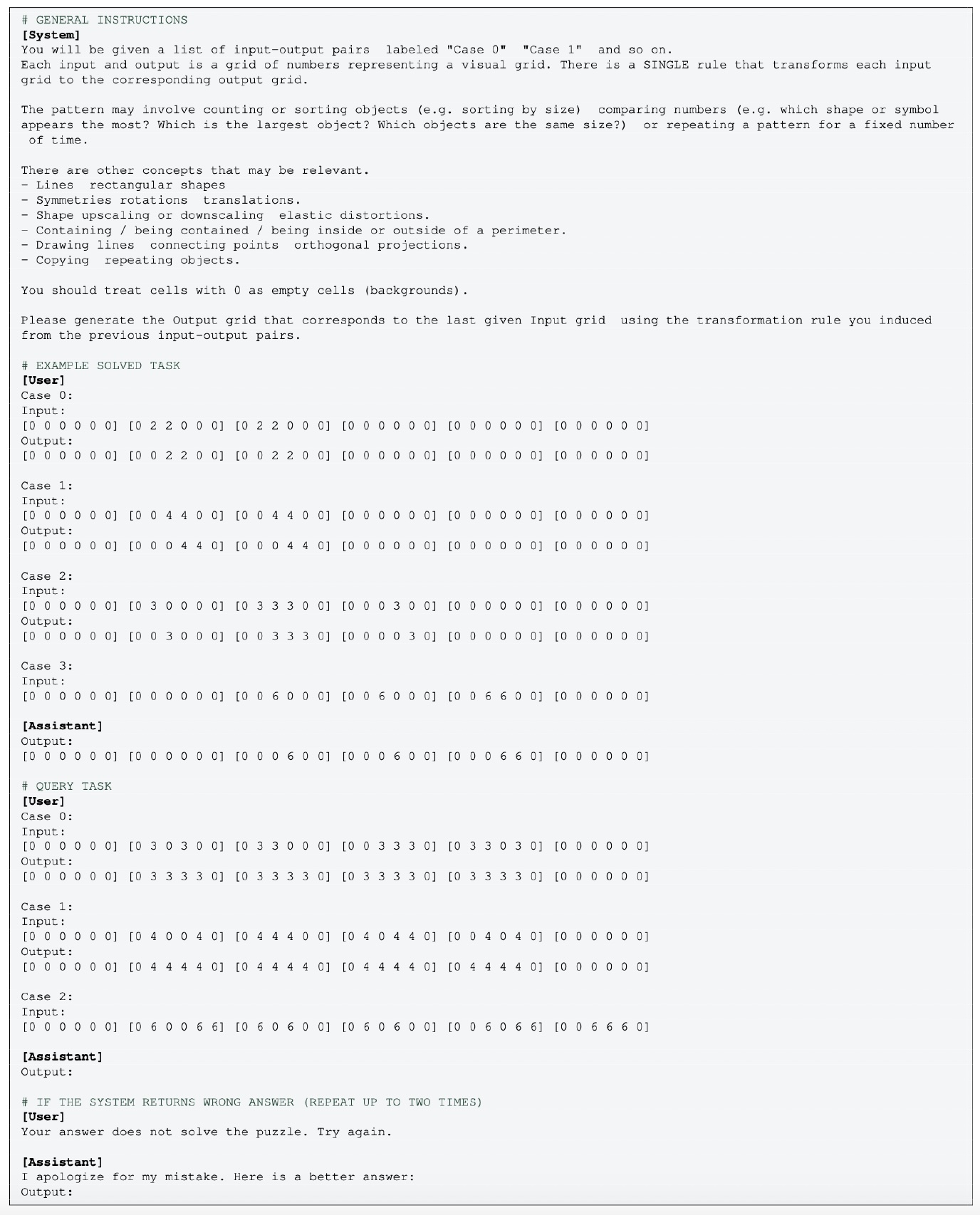

圣塔菲研究所的研究人员进行了新的实验,使用了 ConceptARC,这是专为人类参与者更易访问,并有助于评估特定概念理解的 ARC 变体。为了适应基于文本的 GPT-4,视觉谜题被转换成字符序列。模型收到了包含指令、已解决示例和新问题的提示。GPT-4 的任务是生成代表解决方案的字符序列,并允许尝试多达三次。

以前的测试显示 GPT-4 在不同温度下在 ConceptARC 上得分分别为 19% 和 25%。但是通过新的更全面的提示技术,结果有所改进。当在所有 480 个 ConceptARC 任务中测试,并将模型的温度设置调整为 0 和 0.5 时,GPT-4 的平均表现约为 33%。

尽管有所进步,但 GPT-4 的能力仍远远落后于人类的表现,后者在 ConceptARC 上的表现令人印象深刻,达到 91%。圣塔菲的科学家们指出,“即使使用更多信息的提示,GPT-4 的表现仍远远低于人类的高表现,这支持了这样的结论,即,即便是更具信息化的提示,该系统也缺乏本语料库测试的基本抽象推理能力。”

GPT-4 纯文本版本的 ConceptARC 测试

多模态是否提高了 GPT-4 的表现?

研究人员还在 GPT-4V 上测试了 ConceptARC,GPT-4V 是 GPT-4 的多模态版本,能够处理图像以及文本。普遍认为 GPT-4V 会凭借其增强的能力超越其仅文本版本的对应物。然而,由于全面测试的成本过高,研究人员将 GPT-4V 的评估限制在了一组被称为“注意力检查”的 ConceptARC 谜题上,人类通常在这些任务中取得 95% 的成功率。

有趣的是,当这些注意力检查转换为仅文本格式以供 GPT-4 使用时,该模型获得了 65-69% 的得分,这表明这些任务不如完整集合具有挑战性。然而,GPT-4V 在这些任务上的表现平均为 23-25%,低于仅文本版本的成就。

论文对 GPT-4V 反应的观察很有趣:“GPT-4V 经常在其解决方案的一部分中包括对抽象转换规则的描述……在某些情况下,尽管确认了不正确的抽象规则,但模型准确描述了输出格,我们将其归类为成功。另一方面,我们将模型正确识别了抽象规则但未能准确描述输出网格的情况归为失败。”

GPT-4V 在完整的 ConceptARC 语料库上的表现很可能比注意力检查子集还要糟糕。这一结果表明,多模态功能不一定能在 LLM 中提供更好的抽象推理能力。

这对 LLM 应用意味着什么?

圣塔菲研究所的研究结果强调了人类与目前可用的最先进 AI 系统在抽象推理方面的显著差异。

研究人员写道:“我们的结果支持这样的假设,即可能是目前最有能力的‘通用’LLM 的 GPT-4,仍然不能稳健地形成抽象并推理训练数据中未曾见过的基本核心概念。可能其他提示方法或任务表征会提高 GPT-4 和 GPT-4V 的性能;这是未来研究的一个主题。”

因此,在将这些模型集成到需要精确逻辑的决策过程中时,最好保持谨慎。而在 AI 应用中,特别是在敏感的应用程序中,人类监督仍然至关重要。