Hugging Face首席执行官预测小型语言模型将在2024年占据主导地位

2023年12月20日 由 neo 发表

449

0

对于人工智能来说,2024年将是一个重要的转折点。随着小型语言模型(SLM)的崛起,各公司推动效率、成本效益和可访问性的极限。

SLM是一种紧凑、强大的AI模型,它可以针对特定的任务进行训练和微调。它们的参数更少,推理速度更快,内存和存储需求更低,可以在普通的硬件和设备上运行。它们的可定制性使它们能够适应不同的应用需求。

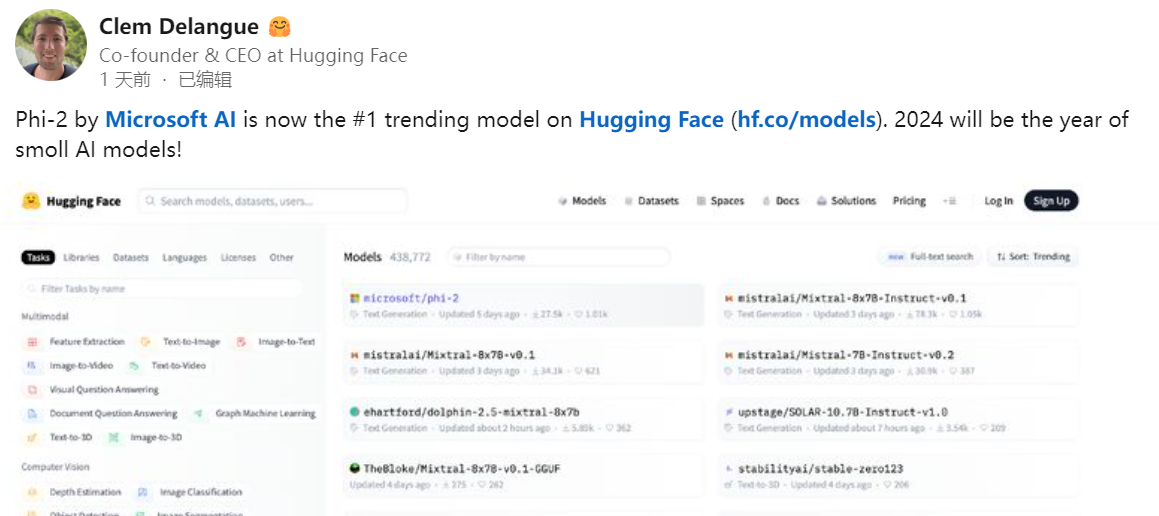

Hugging Face的联合创始人兼首席执行官Clam Delangue认为,2024年将是小型AI模型的一年。他在领英上宣布,微软AI的Phi-2是Hugging Face上最受欢迎的模型。

法国AI初创公司Mistral也推出了开源的SLM——Mixtral 8x7B,它在一些基准上与GPT-3.5相当,但只需要在一台有100GB内存的电脑上运行。它使用了“稀疏专家混合”模型,将多个小型模型组合起来,提高了效率。

微软也不落人后,发布了自主研发的SLM——Phi-2。这款模型只有27亿个参数,非常小巧,甚至可以在手机上运行,显示了行业对缩小模型规模的承诺。

相比之下,像GPT-3这样的LLM有1750亿个参数,虽然能够生成人类般的文本、回答问题和总结文档,但也有很多缺点,比如效率低、成本高、可定制性差,这为SLM的崛起创造了机会。

SLM的崛起标志着人工智能的变革时代。2024年将是小型AI模型之年,创新和可访问性将重新定义人工智能的可能性。

文章来源:https://mpost.io/hugging-face-ceo-predicts-smaller-ai-models-will-dominate-2024/

欢迎关注ATYUN官方公众号

商务合作及内容投稿请联系邮箱:bd@atyun.com

上一篇

AI是否能够取代医生的“直觉”?

下一篇

人工智能可以检测自闭症吗?

热门企业

热门职位

写评论取消

回复取消