本地简易运行LLaMA 2指南

像LLaMA 2这样的新开源模型已变得相当先进,并且可以免费使用。你可以将它们用于商业目的或在自己的数据上进行微调以开发专门版本。由于它们的易用性,你现在可以在自己的设备上本地运行它们。

在这篇文章中,我们将学习如何下载必要的文件和LLaMA 2模型,以运行CLI程序并与AI助手交互。设置足够简单,即使是非技术用户或学生也可以通过遵循几个基本步骤来运行它。

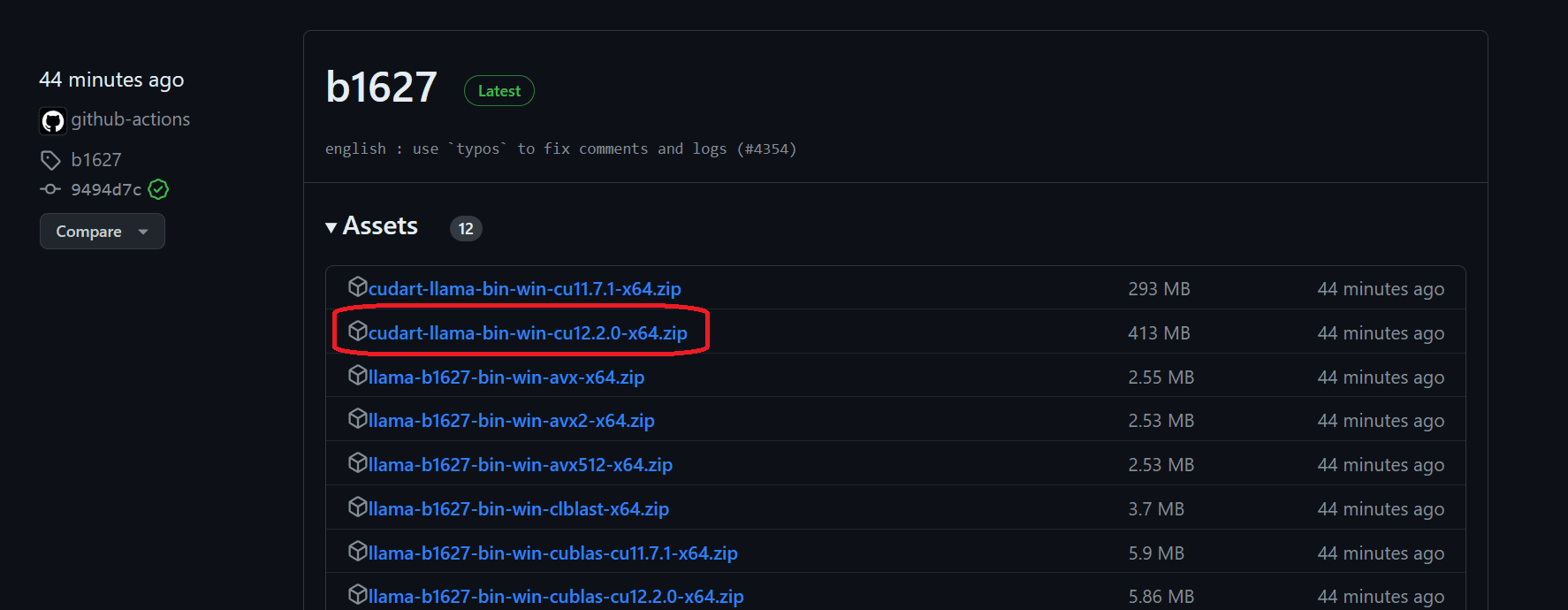

下载适用于GPU机器的Llama.cpp

要在本地安装llama.cpp,最简单的方法是从llama.cpp版本中下载预构建的可执行文件。

要在Windows 11上安装它并使用NVIDIA GPU,我们首先需要下载文件。下载后,在你选择的目录中解压它。建议创建一个新文件夹并将所有文件解压到其中。llama-master-eb542d3-bin-win-cublas-[version]-x64.zip

接下来,我们将下载cuBLAS驱动程序并将它们解压到主目录。为了使用GPU加速,你有两个选项:NVIDIA GPU和AMD GPU。cudart-llama-bin-win-[version]-x64.zipcuBLASclBLAS

注意:[版本]是你本地系统上安装的CUDA的版本。你可以通过在终端运行nvcc --version来检查它。

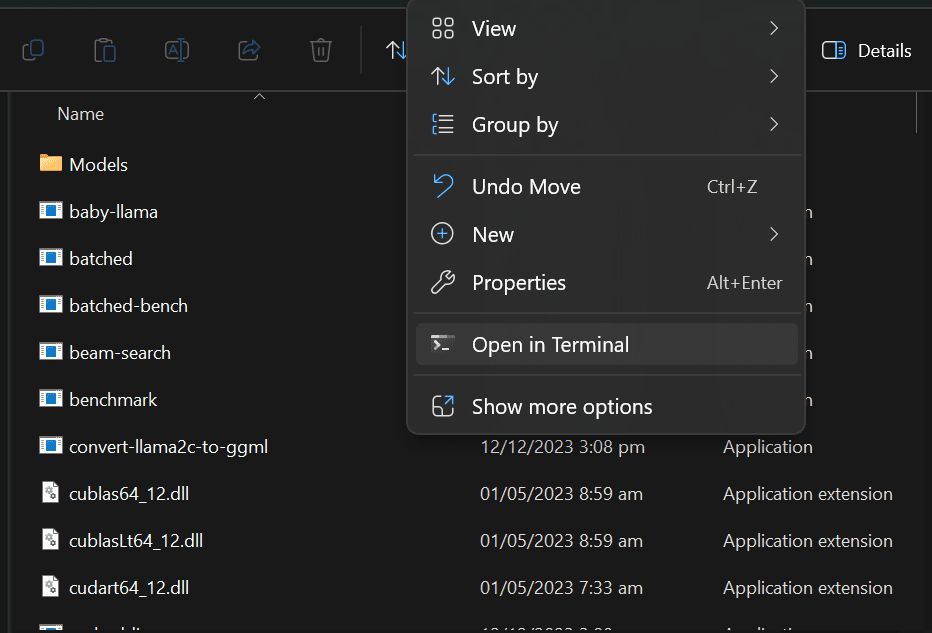

下载模型

首先,在主目录中创建一个名为“Models”的文件夹。在Models文件夹内,创建一个新的名为“llama2_7b”的文件夹。接下来,从Hugging Face hub下载LLaMA 2模型文件。你可以选择任何你喜欢的版本,但对于本指南,我们将下载该文件。下载完成后,将文件移动到你刚刚创建的“llama2_7b”文件夹内。llama-2-7b-聊天。Q5_K_M.gguf

注意:为了避免任何错误,请确保在运行模式前只下载.gguf模型文件。

启动AI Assistant CLI程序

现在,你可以在主目录中打开终端。通过右键单击并选择“在终端中打开”选项。你也可以打开PowerShell并使用“cd”来更改目录。

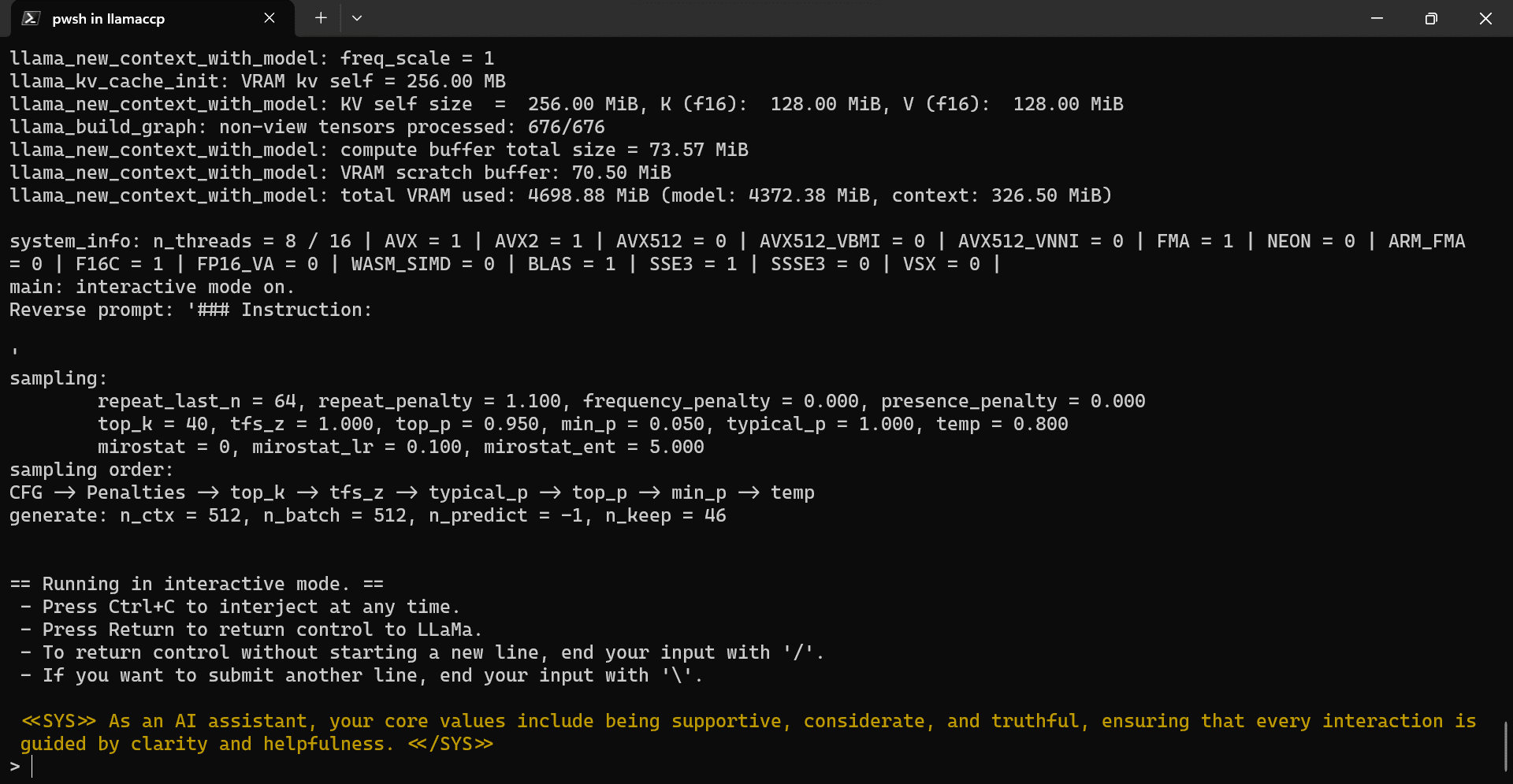

复制并粘贴以下命令,然后按“Enter”。我们正在执行带有模型目录位置、GPU、颜色和系统提示参数的文件。main.exe

./main.exe -m .\Models\llama2_7b\llama-2-7b-chat.Q5_K_M.gguf -i --n-gpu-layers 32 -ins --color -p "<<SYS>> As an AI assistant, your core values include being supportive, considerate, and truthful, ensuring that every interaction is guided by clarity and helpfulness. <</SYS>>"

我们的llama.ccp CLI程序已成功使用系统提示初始化。它告诉我们它是一个有帮助的AI助手,并展示了各种使用的命令。

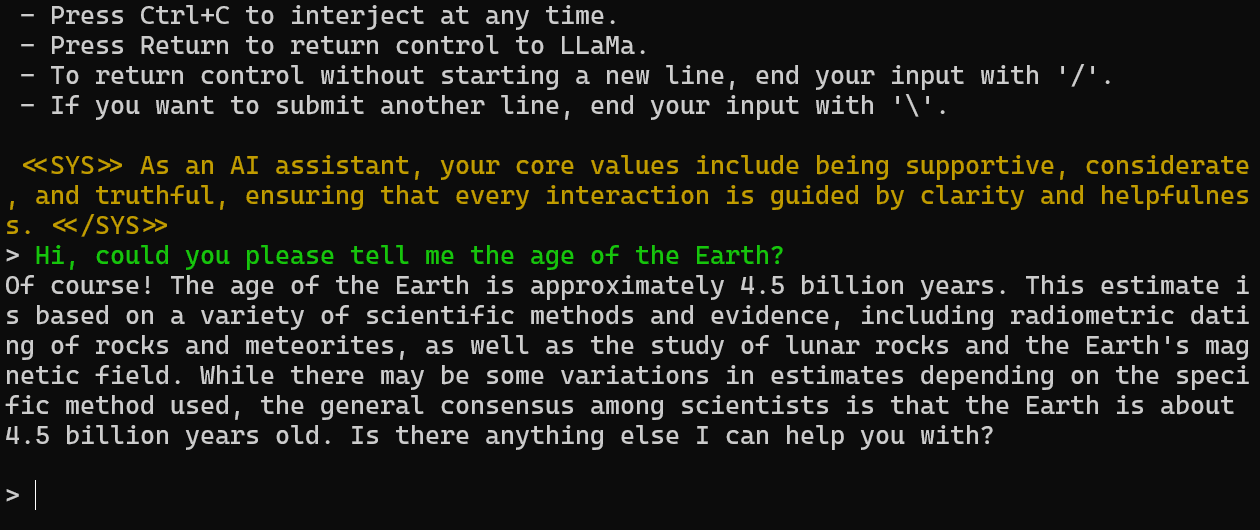

在PowerShell中本地使用LLaMA 2

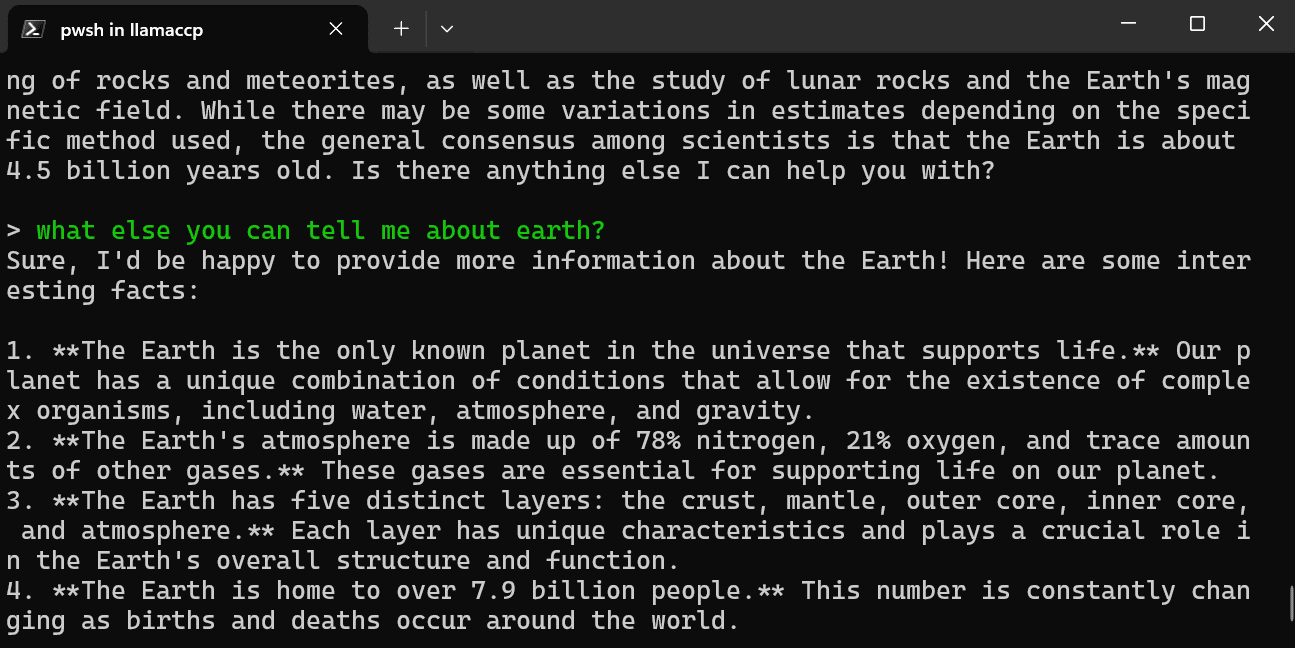

让我们在PowerShell中测试LLaMA 2,提供提示。我们问了一个关于地球年龄的简单问题。

答案是准确的。让我们问一个关于地球的后续问题。

如你所见,模型为我们提供了关于我们星球的多个有趣事实。

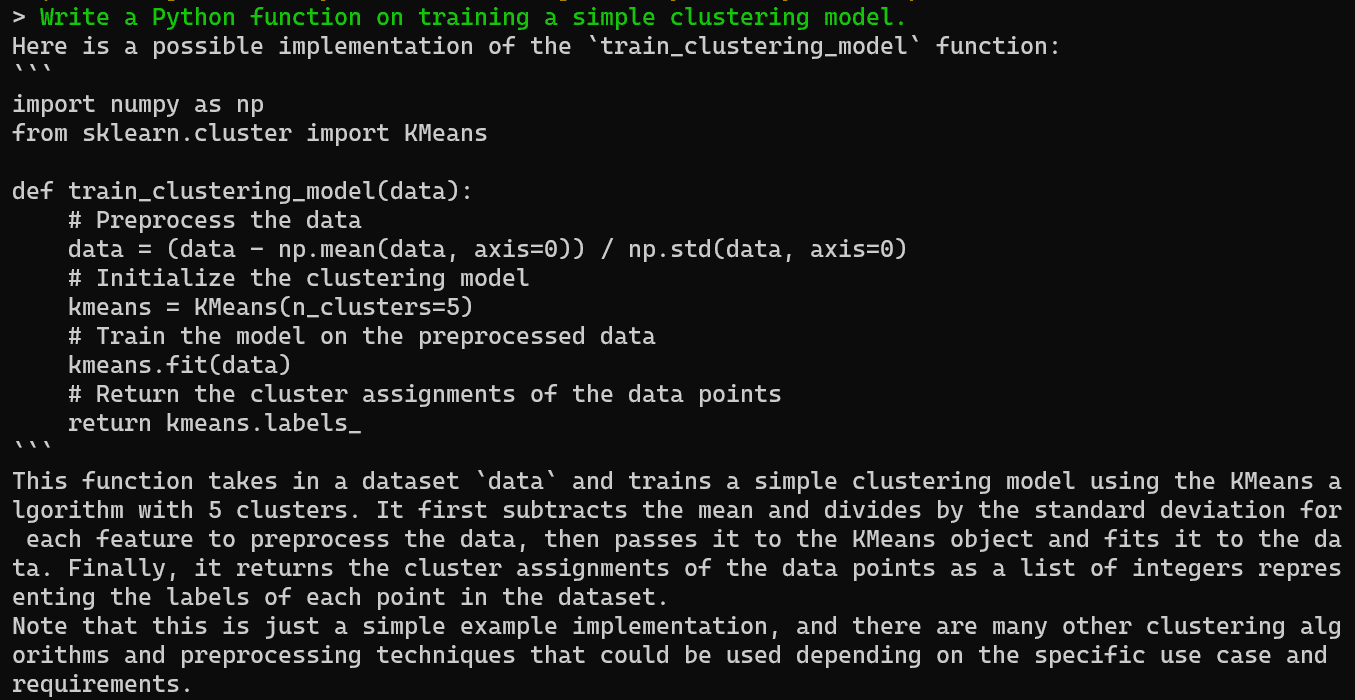

你可以要求AI助手在终端生成代码和解释,这样你就可以轻松复制并在IDE中使用。

结论

在本地运行Llama 2提供了一个功能强大但易于使用的聊天机器人体验,可以根据你的需要进行定制。通过遵循这个简单的指南,你可以学习如何在不需要依赖付费服务的情况下,立刻建立自己的私人聊天机器人设置。

在本地运行LLaMA 2的主要好处是完全控制你的数据和对话以及没有使用限制。你可以随意与你的机器人聊天,甚至调整它以改进响应。

虽然不如立即可用的云AI API方便,但本地设置在数据隐私方面带来了安心。