探索循环自动编码器的动力学:利用合成数据和视觉洞察从理论到实践

介绍

循环自编码器是自编码器架构和循环神经网络(RNNs)的复杂融合。自编码器是为非监督学习设计的神经网络,通常用于降维或特征学习。它们由一个编码器和一个解码器组成。另一方面,循环神经网络设计来处理序列数据,使它们非常适合处理像语言建模和时间序列预测这样的任务。

循环自编码器基础

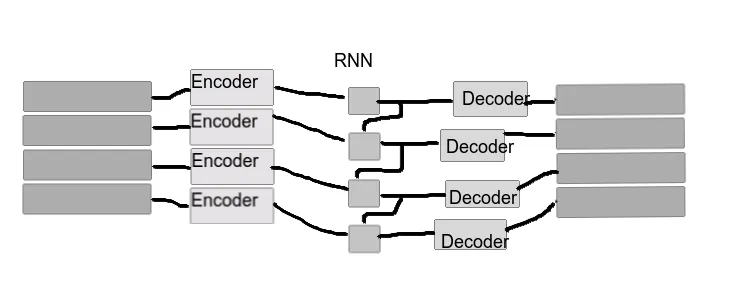

循环自编码器结合了RNN(循环神经网络)和传统自编码器的优点。其结构的特点是在编码器和解码器阶段都含有循环层。这种设计使得模型能够跨序列保持状态信息,这是处理时间相关数据时的一个关键方面。与擅长静态模式识别的标准自编码器不同,循环自编码器在动态、时间序列数据解释方面表现出色。

技术方面

在编码阶段,循环自编码器处理输入序列,捕获时间依赖性。然后将编码表示输入到解码器中,试图重构原始输入。组成循环层的通常是长短时记忆(LSTM)或门控循环单元(GRU),这些在捕获数据中的长期依赖关系方面至关重要。优化这些模型通常涉及到最小化损失函数(例如针对序列数据特性的均方误差)。

应用领域

循环自编码器在处理序列数据的领域找到了广泛的应用。在时间序列分析中,它们有助于预测和识别模式。在自然语言处理中,它们辅助执行任务,如文本生成和情感分析。它们重构输入序列的能力也使它们适用于序列数据流的异常检测。

挑战和局限性

训练循环自编码器并非没有挑战。该架构的复杂性可能导致显著的计算需求。训练深度神经网络时常见的梯度消失问题,在RNNs中尤为突出,影响了循环自编码器的训练效果。克服这些挑战通常需要仔细的架构选择和训练策略。

进展和未来趋势

在循环自编码器的设计中不断涌现出创新。LSTM和GRU单元的引入,已经缓解了一些训练挑战。将循环自编码器与其他神经网络模型(如卷积神经网络)集成,也为应用开辟了新的途径,特别是在多模态数据处理方面。

代码

创建完整的Python实现的循环自编码器,包括生成合成数据集和绘制结果,涉及到几个步骤。下面,我将提供一个全面的指南以及每个部分的代码片段。

首先,请确保你安装了必要的库。你将需要TensorFlow来构建循环自编码器和Matplotlib来绘制图表。你可以使用pip安装这些库:

pip install tensorflow matplotlib

import numpy as np

import tensorflow as tf

import matplotlib.pyplot as plt

def generate_synthetic_data(data_size, sequence_length):

x = np.linspace(0, 100, data_size)

data = np.column_stack((np.sin(x), np.cos(x)))

data = data.reshape((data_size // sequence_length, sequence_length, -1))

return data

# Example usage

data_size = 10000

sequence_length = 50

data = generate_synthetic_data(data_size, sequence_length)

class RecurrentAutoencoder(tf.keras.Model):

def __init__(self, sequence_length, latent_dim):

super(RecurrentAutoencoder, self).__init__()

self.encoder = tf.keras.Sequential([

tf.keras.layers.LSTM(latent_dim, activation='relu', input_shape=(sequence_length, 2), return_sequences=False),

tf.keras.layers.RepeatVector(sequence_length)

])

self.decoder = tf.keras.Sequential([

tf.keras.layers.LSTM(latent_dim, activation='relu', return_sequences=True),

tf.keras.layers.TimeDistributed(tf.keras.layers.Dense(2))

])

def call(self, x):

encoded = self.encoder(x)

decoded = self.decoder(encoded)

return decoded

latent_dim = 20

autoencoder = RecurrentAutoencoder(sequence_length, latent_dim)

autoencoder.compile(optimizer='adam', loss='mse')

# Split data into training and testing

train_data, test_data = np.split(data, [int(0.8 * len(data))])

# Train the model

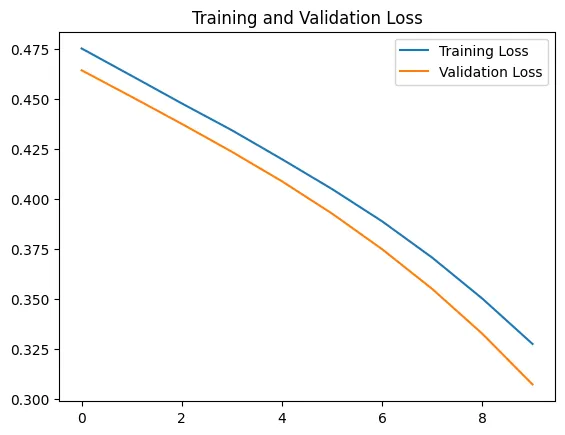

history = autoencoder.fit(train_data, train_data, epochs=10, batch_size=128, validation_data=(test_data, test_data))

plt.plot(history.history['loss'], label='Training Loss')

plt.plot(history.history['val_loss'], label='Validation Loss')

plt.title('Training and Validation Loss')

plt.legend()

plt.show()

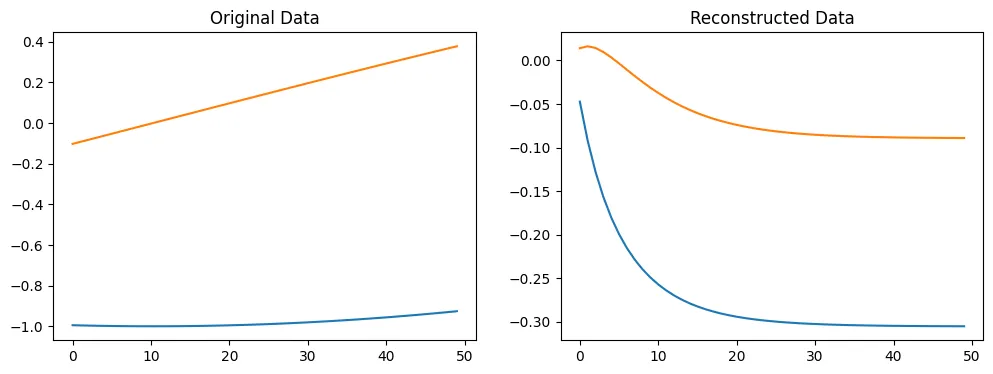

# Select a sample from the test set

test_sample = test_data[0].reshape(1, sequence_length, -1)

# Get the model's reconstruction of the sample

reconstructed = autoencoder.predict(test_sample)

# Plot the original and reconstructed data

plt.figure(figsize=(12, 4))

plt.subplot(1, 2, 1)

plt.plot(test_sample[0])

plt.title('Original Data')

plt.subplot(1, 2, 2)

plt.plot(reconstructed[0])

plt.title('Reconstructed Data')

plt.show()

Epoch 1/10

2/2 [==============================] - 15s 2s/step - loss: 0.4754 - val_loss: 0.4645

Epoch 2/10

2/2 [==============================] - 0s 227ms/step - loss: 0.4617 - val_loss: 0.4512

Epoch 3/10

2/2 [==============================] - 0s 158ms/step - loss: 0.4479 - val_loss: 0.4376

Epoch 4/10

2/2 [==============================] - 0s 227ms/step - loss: 0.4344 - val_loss: 0.4236

Epoch 5/10

2/2 [==============================] - 0s 225ms/step - loss: 0.4199 - val_loss: 0.4089

Epoch 6/10

2/2 [==============================] - 0s 292ms/step - loss: 0.4050 - val_loss: 0.3927

Epoch 7/10

2/2 [==============================] - 0s 200ms/step - loss: 0.3888 - val_loss: 0.3748

Epoch 8/10

2/2 [==============================] - 0s 152ms/step - loss: 0.3706 - val_loss: 0.3550

Epoch 9/10

2/2 [==============================] - 0s 319ms/step - loss: 0.3501 - val_loss: 0.3325

Epoch 10/10

2/2 [==============================] - 0s 288ms/step - loss: 0.3275 - val_loss: 0.3072

这段代码将生成一个循环自编码器,用合成数据对其进行训练,然后绘制结果,展示模型的学习曲线以及其重构输入数据的能力。你可以尝试不同的latent_dim值、序列长度和数据集大小,观察它们如何影响自编码器的性能。

结论

循环自编码器在神经网络领域代表了一项重大进步,尤其是在顺序数据处理方面。它们能够自主学习复杂的时间模式,这使得它们在许多现代AI应用中变得无价。随着技术的发展,循环自编码器的能力和应用也将不断进化,使它们成为人工智能研究中一个持续引人注目的领域。