遇见JoyTag:一个具有Joyful Vision模型的包容性图像标注AI模型

随着人工智能(AI)的最新进展,它正在被应用于生活的各个领域。机器视觉模型是一类能够分析视觉信息并基于该分析做出决策的AI。机器视觉模型在多个行业中被使用,包括医疗保健、安全、汽车、娱乐和社交媒体。然而,大多数公开可用的模型严重依赖过滤过的训练数据集,这限制了它们在不同概念上的性能。此外,由于严格的审查政策,它们通常难以全面理解世界。

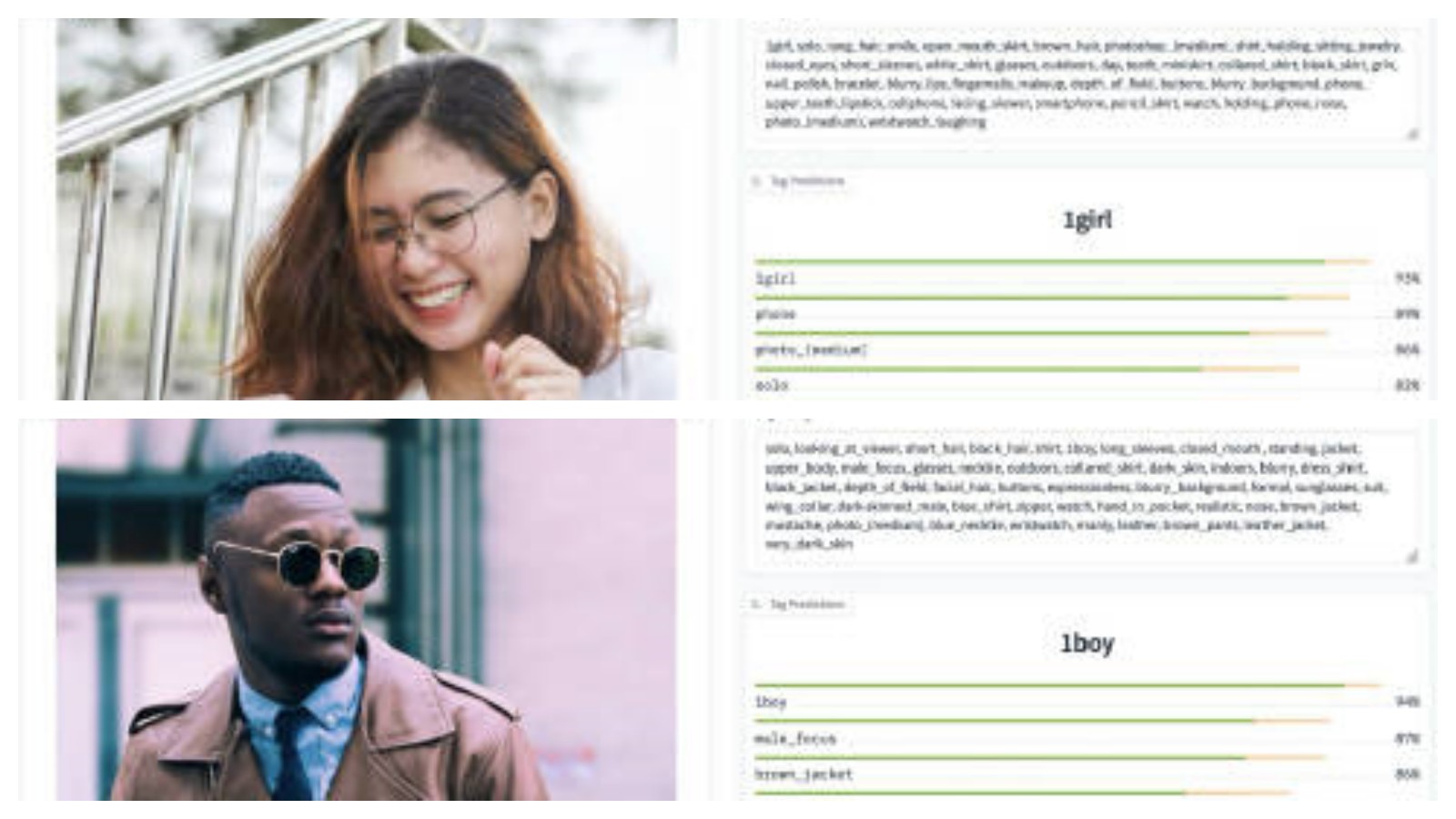

在这个领域,我们在Reddit上看到了一个非常有趣的帖子,介绍了一个名为JoyTag的新模型。JoyTag的设计突出了对性别积极性和包容性的关注,旨在为图像标注。该模型基于ViT-B/16架构,并具有448x448x3的输入尺寸和9100万个参数。该模型的训练涉及660亿个样本。由于其目标任务是多标签分类、拥有5000个独特的标签、使用了Danbooru标注模式,并扩展了其在不同图像类型上的应用,JoyTag优于同类产品。

JoyTag训练了结合了Danbooru 2021数据集,并对图像进行了人工标注,以拓宽其概括性,超越Danbooru以动漫/漫画为中心的焦点。虽然Danbooru数据集提供了规模、质量和多样性,但在内容多样性,尤其是在摄影图片方面受到限制。为了解决这个问题,JoyTag团队从互联网上手动标记了一些图像,强调那些在主要数据集中代表性不足的照片。

JoyTag基于带有CNN干细胞和GAP头部的ViT模型。进一步地,研究人员强调,JoyTag的设计遵守了主要IT公司的任意整洁标准,该模型在包括图片和动漫/漫画风格图像在内的所有标签上实现了0.578的平均F1分数。

但是JoyTag也有一些限制。它在数据可用性稀缺的概念中面临挑战,如面部表情。一些主观概念也存在困难,因为Danbooru数据集的标注指南未始终一致执行。JoyTag的最终目的是在管理多样化内容的同时,优先考虑包容性和多样性。研究人员强调,为了提高F1分数和解决特定的不足,计划在不断的反偏见斗争中大幅扩展数据集。

总而言之,JoyTag代表了图像标注的重大飞跃。其克服限制性过滤并兼具包容性的能力是实质性的。JoyTag为自动化图像标注打开了新的可能性,为机器学习模型带来了更深入、更包容的理解。其自主预测超过5000个不同标签的能力,以及不违反用户权利地处理大量多媒体内容的能力,也为开发者提供了他们可以在广泛领域中使用的强大工具,这是一项重要进展。总体而言,JoyTag为将来朝着完全包容和公平的AI解决方案迈进提供了坚实的基础。