了解自回归语言模型的复杂性

介绍

自回归语言模型是现代自然语言处理(NLP)领域的基石,它们代表了人工智能领域的一个重大进步。这些模型彻底改变了机器理解和生成人类语言的方式,它们的影响力扩展到了从机器翻译到内容创作的各种不同应用。

了解自回归语言模型

自回归语言模型基于预测一系列词汇的概率原理。它们通过一次生成一个词来运作,且每一个新词都是基于它之前的词序列来预测的。这种序列化的方法类似于人类如何构建句子,考虑每个词在前面词的上下文中的位置。

关键特点

- 序列预测:这些模型通过预测序列中的下一个词来生成文本,使得它们的输出本质上是序列化并且与上下文相关的。

- 概率性质:它们为词序列分配概率,基本上是估计一个词在给定序列之后出现的可能性。

- 上下文意识:通过考虑前面的词,自回归模型保持上下文,允许生成连贯且相关的文本。

演变和影响

自回归语言模型的演变可以追溯到更简单的模型,如n-gram模型和隐马尔可夫模型。然而,真正的突破在于引入了基于神经网络的模型,尤其是诸如递归神经网络(RNN)和更近期的Transformer架构。

里程碑

- RNN和LSTM:这些较早期的模型在处理文本序列方面至关重要,但面临着像梯度消失问题这样的挑战。

- Transformer:Transformer架构的引入,特别是其自注意力机制,允许更有效地处理文本中的长距离依赖性。

- GPT系列:从GPT到其后续产品如GPT-3和GPT-4的生成预训练变压器(GPT)系列,体现了自回归语言模型的巅峰,展示了在文本生成、理解,甚至推理方面的卓越能力。

应用领域

自回归语言模型的应用多种多样,并且不断扩展:

- 内容生成:从创作文章到作诗,这些模型显示了创造性写作的才华。

- 机器翻译:它们显著提高了机器翻译的质量,使得翻译更加流畅和上下文准确。

- 会话代理:在客户服务和虚拟助手中,这些模型提供了更连贯且上下文相关的回应。

- 教育和研究:它们协助教育工具和研究,特别是在文本摘要和生成教育内容方面。

挑战和道德考虑

尽管有所进步,自回归语言模型面临着挑战:

- 偏见和公平:这些模型可以传播和放大它们训练数据中存在的偏见。

- 可解释性和解释性:理解这些模型如何做出特定决策仍然是一个复杂的任务。

- 道德使用:确保这些强大工具在新闻生成和法律咨询等敏感领域被道德和负责任地使用,至关重要。

代码

创建一个完整的Python代码实现,用于自回归语言模型,连同一个合成的数据集和绘图能力,涉及到多个步骤。在这里,我将提供一个使用简单模型架构和合成数据集的示例。这个示例将使用Python库,如TensorFlow(或PyTorch)和Matplotlib进行绘图。

步骤1:安装必需的库

你需要TensorFlow(或PyTorch)和Matplotlib。你可以通过pip来安装这些:

pip install tensorflow matplotlib

步骤2:生成合成数据集

为了简单起见,我们创建一个顺序数字的合成数据集,这些数据将以自回归的方式被模型学习预测。

步骤3:定义自回归模型

为此我们将使用一个基本的RNN(循环神经网络)。

步骤4:训练模型

在合成数据集上训练模型。

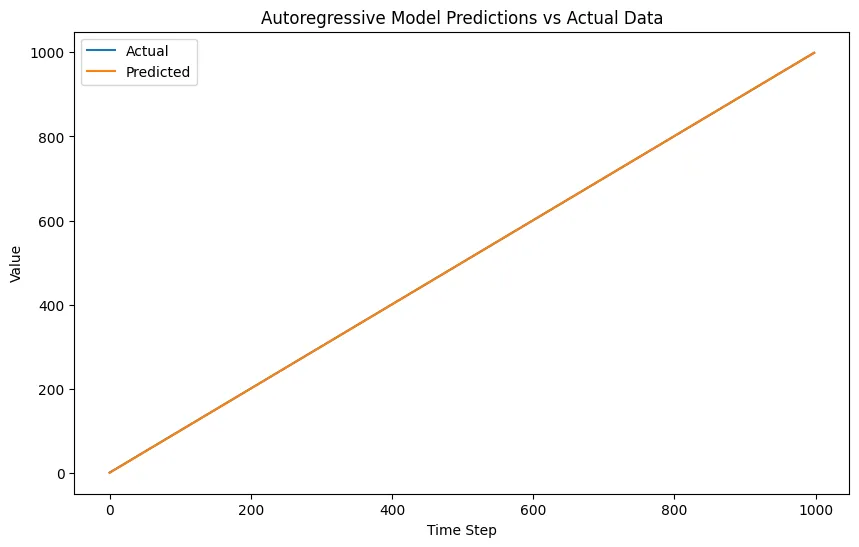

步骤5:评估并绘制结果

使用Matplotlib绘制模型预测与实际数据的对比图。

以下是这些步骤的完整代码:

import numpy as np

import tensorflow as tf

import matplotlib.pyplot as plt

# Step 2: Generate a Synthetic Dataset

def generate_synthetic_data(size=1000):

return np.arange(size)

# Create the dataset

data = generate_synthetic_data()

X = data[:-1]

y = data[1:]

# Reshape for the RNN

X = X.reshape((len(X), 1, 1))

y = y.reshape((len(y), 1))

# Step 3: Define the Autoregressive Model

model = tf.keras.Sequential([

tf.keras.layers.SimpleRNN(50, activation='relu', input_shape=(1, 1)),

tf.keras.layers.Dense(1)

])

model.compile(optimizer='adam', loss='mse')

# Step 4: Train the Model

model.fit(X, y, epochs=200, verbose=0)

# Step 5: Evaluate and Plot the Results

predictions = model.predict(X)

plt.figure(figsize=(10,6))

plt.plot(data[1:], label='Actual')

plt.plot(predictions, label='Predicted')

plt.title("Autoregressive Model Predictions vs Actual Data")

plt.xlabel("Time Step")

plt.ylabel("Value")

plt.legend()

plt.show()

注意事项:

- 数据集:这个合成数据集过于简单。现实世界中的数据集将会更复杂,并需要进行预处理。

- 模型复杂性:此例中使用了基本的RNN模型。对于更复杂的数据,你可能需要使用LSTM(长短期记忆)或GRU(门控循环单元)层,甚至可能需要基于Transformer的模型。

- 训练:模型训练了200个周期,但这可以根据损失的收敛情况进行调整。

- 评估:图表将展示模型预测与实际数据的一致程度。在现实世界情境中,你会使用更复杂的评估指标。

请记住,这只是一个基本示例,用于说明概念。

结论

自回归语言模型在人工智能领域尤其是自然语言处理方面代表了一个飞跃。它们理解和生成人类语言的能力,为各个行业开辟了新的视野。随着我们继续开发和完善这些模型,解决它们的挑战并确保它们的道德和公平使用至关重要。这些模型的未来不仅仅是关于技术进步,还涉及在创新和负责任使用之间导航复杂平衡的问题。