释放卷积自动编码器的潜力:深入研究图像处理和重建

介绍

在深度学习领域,卷积自编码器已经成为一个强大的工具,用于特征学习、图像重构和生成模型等任务。卷积自编码器植根于传统自编码器的架构,这些专门的网络利用卷积神经网络(CNN)来有效处理和理解图像数据。本文深入探讨了卷积自编码器的结构、功能性以及应用,阐述了它们在人工智能和机器学习领域的重要性。

了解卷积自动编码器

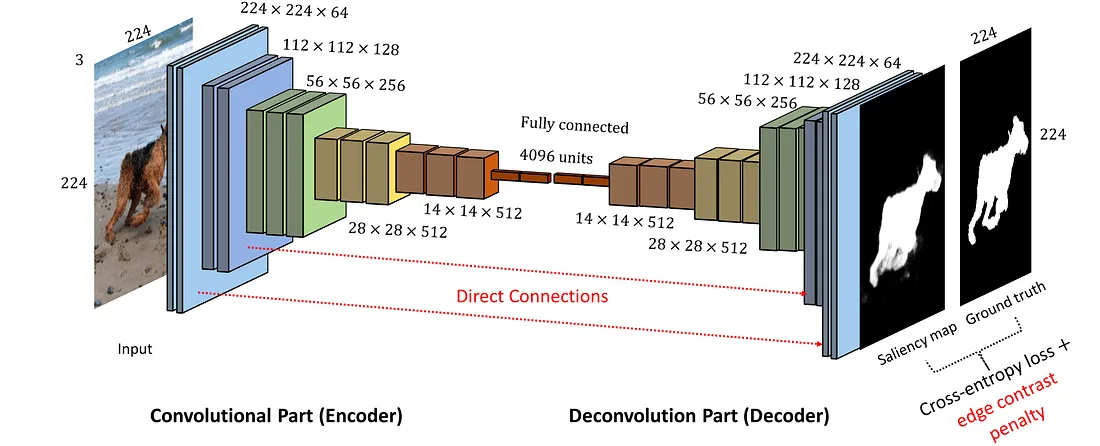

卷积自编码器由两个主要部分组成:编码器和解码器。编码器部分采用卷积层逐步降低输入图像的维数,有效地将其编码到一个低维的潜在空间中。这个潜在表示捕获了输入数据的基本特征。相反,解码器使用反卷积层(或上采样后跟卷积)从这个压缩表示中重建原始图像。

卷积自编码器功能性的关键在于它们学习特征空间层次结构的能力。通过卷积层,这些网络能够在早期层捕获局部模式,如边缘和纹理,以及在更深层捕获更复杂、更抽象的模式。这种分层特征提取使它们在处理图像数据时特别得心应手。

卷积自编码器是使用一种无监督学习方式训练的。目标是最小化重建误差,即原始输入与解码器产生的输出之间的差异。常用的损失函数包括均方误差(MSE)或二元交叉熵,取决于输入数据的性质。

卷积自编码器的应用

- 图像去噪:卷积自编码器的主要应用之一是图像去噪。通过在有噪声和清晰图像对上训练网络,模型学习过滤掉噪声并重建清晰图像。这一应用在医学成像和卫星图像处理等领域非常宝贵。

- 降维:类似于它们的基础对应物,卷积自编码器在图像数据的降维上也很有效。编码的潜在空间提供了一个紧凑的表示,这在需要减少计算复杂性的任务中很有用,例如图像检索或数据可视化。

- 异常检测:在制造业的缺陷检测或金融业的欺诈检测等场景中,卷积自编码器可以通过学习数据的正常模式来识别异常。异常被检测为与学习到的常态的偏差,由高重建误差所标示。

- 生成模型:尽管不如生成对抗网络(GANs)或变分自编码器(VAEs)那么流行,卷积自编码器可以用于生成任务。它们可以学会生成与输入数据相似的新数据样本,在纹理合成和数据增强等任务中有用。

挑战与局限性

尽管卷积自编码器有其优势,但它们也面临挑战。一个显著的问题是,由于编码器中的池化操作会导致空间信息丢失,这可能导致重建的精度不够。此外,它们可能在处理非常复杂的数据分布或高维的潜在空间时遇到困难。

代码

在Python中创建一个完整的卷积自编码器示例代码,包括生成一个合成数据集和绘制结果,涉及到多个步骤。我将提供一个全面的指南,逐个分解每个组件:

- 环境设置:确保您已经安装了必要的库。主要的是,您将需要TensorFlow(或Keras,现在已经是TensorFlow的一部分)和Matplotlib绘图。如果您还没有安装,可以使用pip来安装:

pip install tensorflow matplotlib

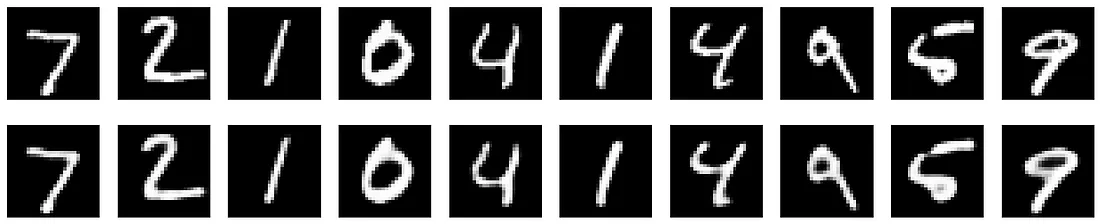

- 合成数据集生成:为了简单起见,我们使用MNIST数据集,这是一组手写数字的集合,通常用于此类演示。它可以通过TensorFlow轻松获取。

- 构建卷积自编码器:这包括使用卷积层定义编码器和解码器。

- 训练:我们将使用MNIST数据集训练自编码器。

- 绘制结果:训练后,我们将绘制原始图像及其重建版本,以可视化自编码器的性能。

以下是一个完整的Python脚本,完成所有这些步骤:

import tensorflow as tf

from tensorflow.keras.layers import Input, Conv2D, MaxPooling2D, UpSampling2D

from tensorflow.keras.models import Model

import matplotlib.pyplot as plt

import numpy as np

# Load MNIST dataset

(x_train, _), (x_test, _) = tf.keras.datasets.mnist.load_data()

x_train = x_train.astype('float32') / 255.

x_test = x_test.astype('float32') / 255.

x_train = np.reshape(x_train, (len(x_train), 28, 28, 1))

x_test = np.reshape(x_test, (len(x_test), 28, 28, 1))

# Encoder

input_img = Input(shape=(28, 28, 1))

x = Conv2D(16, (3, 3), activation='relu', padding='same')(input_img)

x = MaxPooling2D((2, 2), padding='same')(x)

x = Conv2D(8, (3, 3), activation='relu', padding='same')(x)

encoded = MaxPooling2D((2, 2), padding='same')(x)

# Decoder

x = Conv2D(8, (3, 3), activation='relu', padding='same')(encoded)

x = UpSampling2D((2, 2))(x)

x = Conv2D(16, (3, 3), activation='relu', padding='same')(x)

x = UpSampling2D((2, 2))(x)

decoded = Conv2D(1, (3, 3), activation='sigmoid', padding='same')(x)

# Autoencoder

autoencoder = Model(input_img, decoded)

autoencoder.compile(optimizer='adam', loss='binary_crossentropy')

# Train

autoencoder.fit(x_train, x_train,

epochs=10,

batch_size=256,

shuffle=True,

validation_data=(x_test, x_test))

# Display the first 10 images and their reconstructed versions

decoded_imgs = autoencoder.predict(x_test)

n = 10

plt.figure(figsize=(20, 4))

for i in range(n):

# Original

ax = plt.subplot(2, n, i + 1)

plt.imshow(x_test[i].reshape(28, 28))

plt.gray()

ax.get_xaxis().set_visible(False)

ax.get_yaxis().set_visible(False)

# Reconstruction

ax = plt.subplot(2, n, i + 1 + n)

plt.imshow(decoded_imgs[i].reshape(28, 28))

plt.gray()

ax.get_xaxis().set_visible(False)

ax.get_yaxis().set_visible(False)

plt.show()

这个脚本将会:

- 加载并预处理 MNIST 数据集。

- 定义一个简单的卷积自编码器。

- 训练模型10个周期。

- 为了比较,将原始图像和重建图像并排绘制出来。

Epoch 1/10

235/235 [==============================] - 119s 487ms/step - loss: 0.2196 - val_loss: 0.1077

Epoch 2/10

235/235 [==============================] - 102s 435ms/step - loss: 0.0971 - val_loss: 0.0884

Epoch 3/10

235/235 [==============================] - 74s 316ms/step - loss: 0.0867 - val_loss: 0.0836

Epoch 4/10

235/235 [==============================] - 65s 277ms/step - loss: 0.0832 - val_loss: 0.0811

Epoch 5/10

235/235 [==============================] - 69s 294ms/step - loss: 0.0812 - val_loss: 0.0796

Epoch 6/10

235/235 [==============================] - 64s 271ms/step - loss: 0.0797 - val_loss: 0.0783

Epoch 7/10

235/235 [==============================] - 65s 275ms/step - loss: 0.0786 - val_loss: 0.0773

Epoch 8/10

235/235 [==============================] - 63s 268ms/step - loss: 0.0778 - val_loss: 0.0768

Epoch 9/10

235/235 [==============================] - 66s 279ms/step - loss: 0.0770 - val_loss: 0.0759

Epoch 10/10

235/235 [==============================] - 63s 269ms/step - loss: 0.0764 - val_loss: 0.0756

313/313 [==============================] - 4s 11ms/step

结论

卷积自动编码器代表了无监督学习与卷积神经网络融合的一个引人入胜的领域。它们能够提取分层特征,并将数据压缩成有意义的表征,使它们在图像处理和分析中成为了不可或缺的工具。随着研究的进展,我们可以期待它们在架构和应用上进一步的完善,巩固它们在人工智能不断进步的领域中的角色。