Meta团队推出全新AI视频生成模型FlowVid

2024年01月03日 由 daydream 发表

471

0

在数字媒体领域,一个突破性的技术——FlowVid,近日由得克萨斯大学奥斯汀分校联合Meta GenAI团队提出。FlowVid以其在视频一致性和效率上的显著提升,颠覆了当前的视频合成技术。

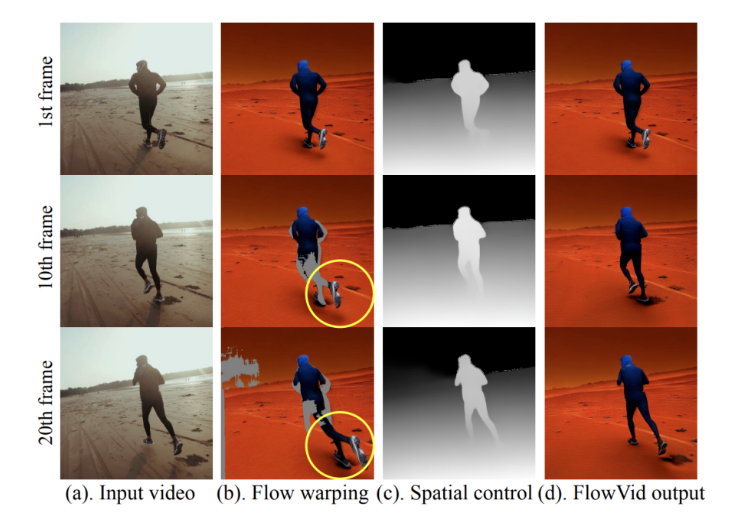

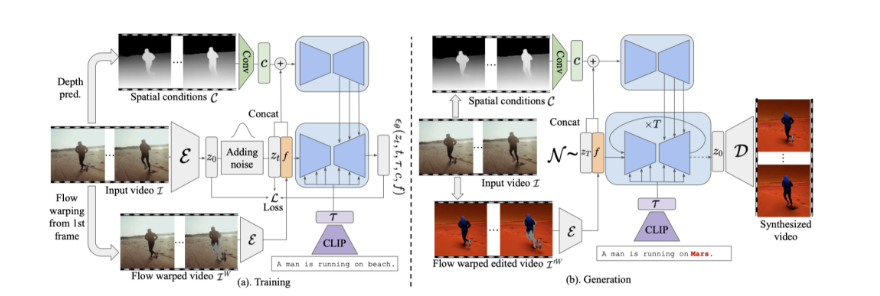

FlowVid框架核心在于对视频序列的每个帧细节理解和高质量合成的能力。它通过利用初始视频帧的光流转化信息,结合复杂的时空约束,不仅缔造出视觉上协调统一的视频效果,还在视频编辑领域,尤其是风格转换或元素替换都显示出前所未有的灵活度。

在实践中,初始视频帧经过转换编码,成为引领整个视频编辑流程的关键。FlowVid将这一帧提供的信息传递至整个视频序列,借助当前流行的图像到图像(I2I)模型来编辑连续帧,无需重复对后续帧单独编辑。这种独创的方法大大加快了视频生成的速度,只需90秒即可产出一个分辨率为512x512、持续4秒、包含120帧的动态视频,相比此前的技术显著削减了合成时间。

该技术在公共数据集上的表现也证实了其优越性,尤其在用户研究中高达45.7%的偏好率显示了其在可视质量和用户满意度上的极大提升。此外,比赛中的计算效率也大幅领先于目前市场上的同类产品。

尽管成果斐然,FlowVid技术也存在限制,例如快速移动和遮挡场景的处理仍有提升空间。研究团队意识到这一点,并计划针对这些挑战进行进一步的研究和优化。

总之,FlowVid不仅以其卓越的性能重塑了视频合成的局面,而且对未来数字创意产业的发展有着深远的影响,富有创意的设计师和视频编辑们现在可以更快速而高效地将富有想象力的想法转化为动人的视觉内容。

文章来源:https://mp.weixin.qq.com/s/06Tpe6a4Q3wkPyNX01PyFg

欢迎关注ATYUN官方公众号

商务合作及内容投稿请联系邮箱:bd@atyun.com

热门企业

热门职位

写评论取消

回复取消