留一交叉验证 (LOO-CV):模型验证和选择的重要工具

介绍

在统计建模和机器学习领域,验证模型的预测能力和构建模型同样重要。留一法交叉验证(LOO-CV)在这个验证过程中扮演了关键的技术,它提供了一种严谨的方法来评估统计模型的性能。本文深入探讨了LOO-CV的概念、方法论、优势及局限性,强调了它在数据科学领域的重要性。

概念与方法论

留一交叉验证(LOO-CV)是一种模型验证技术,用于评估统计模型的预测性能。它属于交叉验证方法的范畴,交叉验证旨在评估统计分析的结果如何推广到一个独立的数据集。LOO-CV的独特之处在于它采用原始样本中的单个观测值作为验证数据,其余观测值作为训练数据的方法。

该过程涉及遍历数据集中的每个数据点。在每次迭代中,模型在除一个之外的所有数据点上进行训练,然后在剩下的数据点上测试模型的预测。这个循环对数据集中的每个数据点重复,因此得名“留一法”。

LOO-CV的优势

- 减少偏差:通过使用几乎全部的数据集进行训练,留一交叉验证最小化了其他交叉验证方法中可能出现的偏差,这些方法中的训练集远小于原始数据集。

- 模型稳健性:它提供了一个综合评估,展现了模型在不同数据子集上的表现,突显了其稳健性或缺乏稳健性。

- 适用于小型数据集:留一交叉验证特别适合小型数据集,其中保留尽可能多的训练数据至关重要。

局限性与注意事项

- 计算强度:对于大型数据集,LOO-CV可能会计算代价高昂,因为它需要根据数据点数量来拟合模型。

- 估计的方差:这种方法可能会因为在非常相似的数据集上重复评估模型而导致测试阶段的方差较高。

- 对异常值的敏感性:LOO-CV可能对异常值过于敏感,因为每次模型迭代都是在单个数据点上测试。

应用领域

LOO-CV在各个领域都有应用,从机器学习和人工智能到计量经济学和生物信息学。它在调优模型、选择适当的模型参数中起着重要作用,最终也在关于部署何种模型进行预测任务的决策过程中起着重要的作用。

代码

为了演示Python中的留一交叉验证(LOO-CV),我们可以使用一个合成数据集和一个简单的回归模型作为例子。我们还将绘制结果,以直观地展现模型在LOO-CV的不同迭代中的性能。在此演示中,我们将使用如numpy进行数据操作,matplotlib进行绘图,以及使用sklearn进行回归模型和LOO-CV的库。

首先,让我们创建一个合成数据集。我们将生成一个带有一些噪声的简单线性关系。然后,我们会使用一个线性回归模型,并将LOO-CV应用于这个数据集。最后,我们会绘制出每次LOO-CV迭代的预测值与实际值。

现在我们开始编写代码。

import numpy as np

import matplotlib.pyplot as plt

from sklearn.linear_model import LinearRegression

from sklearn.model_selection import LeaveOneOut

from sklearn.metrics import mean_squared_error

# Creating a synthetic dataset

np.random.seed(0)

X = np.random.rand(100, 1) * 10 # 100 data points

y = 3 * X.squeeze() + np.random.randn(100) * 2 # Linear relation with noise

# Initialize linear regression and LOO-CV

model = LinearRegression()

loo = LeaveOneOut()

# Arrays to store actual and predicted values for plotting

y_real = []

y_predicted = []

# Applying LOO-CV

for train_index, test_index in loo.split(X):

X_train, X_test = X[train_index], X[test_index]

y_train, y_test = y[train_index], y[test_index]

model.fit(X_train, y_train)

y_pred = model.predict(X_test)

y_real.append(y_test[0])

y_predicted.append(y_pred[0])

# Plotting

plt.figure(figsize=(10, 6))

plt.scatter(y_real, y_predicted, alpha=0.7)

plt.plot([min(y_real), max(y_real)], [min(y_real), max(y_real)], color='red') # Line for perfect predictions

plt.xlabel('Actual Values')

plt.ylabel('Predicted Values')

plt.title('LOO-CV: Actual vs Predicted Values')

plt.grid(True)

plt.show()

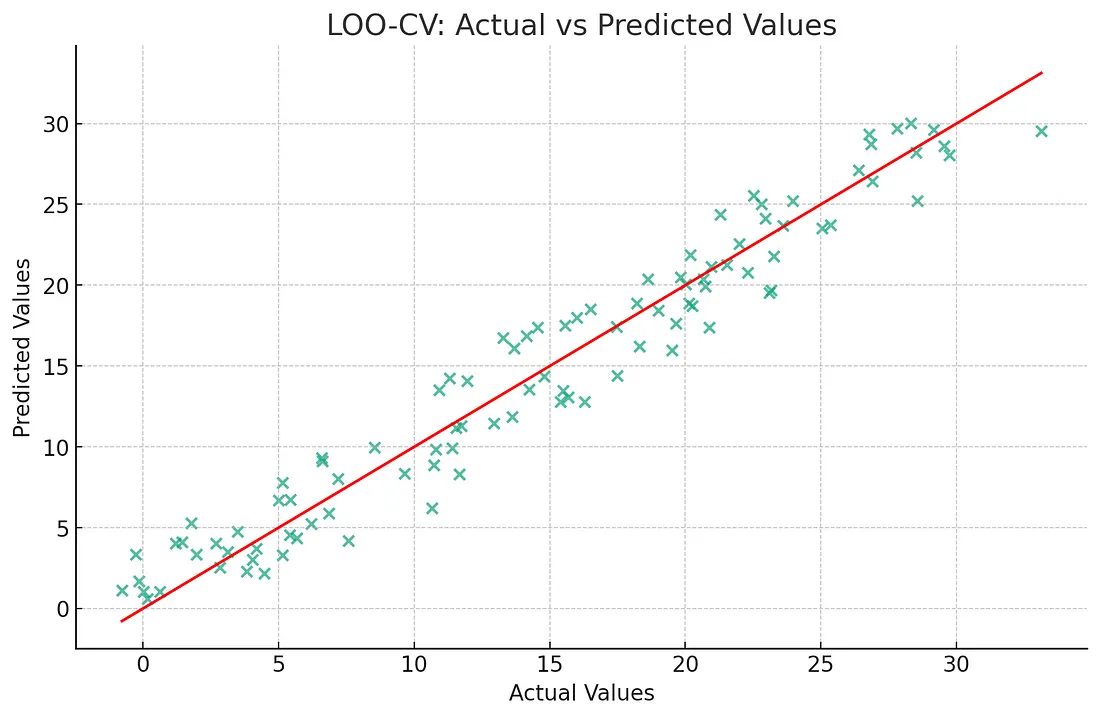

上面的图表显示了使用线性回归模型对我们合成数据集应用留一法交叉验证(LOO-CV)的结果。在这张图中:

- 每个点代表LOO-CV过程的单次迭代。

- x轴显示了每次迭代中留出数据点的实际值。

- y轴显示了由剩余数据训练的模型预测的值。

红线代表完美预测线,预测值与实际值完全匹配的情况。点越接近这条线,模型在该次LOO-CV迭代的预测就越好。

这个视觉表现提供了对模型在训练其余数据集时对每个个别数据点的表现如何的洞察。它是一个强大的工具,用于理解模型行为和诊断潜在问题,如过拟合或欠拟合,特别是在小数据集或数据集变化性高的情况下。

结论

LOO-CV是模型验证工具箱中的一个强大工具。它在彻底评估模型的预测能力方面,特别是在数据有限的情景下,是非常宝贵的。然而,它的实际应用需要在计算可行性和对模型评估的精确需求之间找到平衡。理解其优势和局限性是关键,以在统计建模和机器学习努力中有效地利用LOO-CV。