如何选择和应用Keras中的激活函数:神经网络性能优化指南

介绍

在深度学习的领域中,Keras作为用户友好、模块化、可扩展的Python库而脱颖而出。它作为TensorFlow库的接口,简化了构建和设计神经网络模型的过程。在构成这些网络的众多组件中,激活函数至关重要。这些函数对于学习数据中的复杂模式至关重要,它们从根本上塑造了神经网络的行为和性能。本文深入探讨了Keras中激活函数的本质,探索了它们的多样性、重要性和应用。

激活函数的理解

激活函数的核心是数学方程,它决定了给定输入或一组输入时神经网络节点的输出。这些函数的一个关键特性是它们能够引入非线性到模型中,使得网络能够学习高度复杂的数据。如果没有非线性,不管神经网络的深度如何,都会像线性回归模型一样表现,无法处理像图像识别或语言处理这样的复杂任务。

Keras中常见的激活函数

- ReLU(修正线性单元):ReLU函数定义为f(x)=max(0,x),它是现代神经网络的基石,由于其计算效率高和在减少梯度消失问题上的有效性,它主要用在隐藏层中。

- Sigmoid:在二元分类任务中传统上受到青睐,sigmoid函数将输入压缩到0到1之间的范围内,提供了一个清晰的概率解释。

- Softmax:在多类分类问题中至关重要,softmax函数将原始的对数几率转换成总和为一的概率,为输出分类提供了一个强大的机制。

- Tanh(双曲正切):类似于sigmoid,但输出范围是从-1到1,当数据围绕零中心时,在隐藏层中特别有用。

- Linear(线性):一个简单的恒等函数,通常用于回归任务,目的是预测一个连续值。

- Leaky ReLU和ELU(指数线性单元):这些ReLU的变体解决了死亡神经元的问题(神经元只输出零)通过允许在单元不活跃时存在一个小的、非零梯度。

- Swish:一个比较新的介绍,在某些情况下展示了比ReLU更优越的性能。

在Keras中,一个开源软件库,提供人工神经网络的Python接口,激活函数是构建神经网络时使用的基本组件。激活函数决定了网络中节点的输出,给定一组输入。这里简要概述了Keras中一些常用的激活函数:

ReLU(修正线性单元):

- 使用:keras.activations.relu(x, alpha=0.0, max_value=None, threshold=0)

- 目的:它在网络中引入非线性,定义为f(x)=max(0,x)。它因其简单性和高效率而被广泛使用。

Sigmoid:

- 使用:keras.activations.sigmoid(x)

- 目的:该函数将输入值映射到0和1之间的范围内,适用于二元分类任务。

Softmax:

- 使用:keras.activations.softmax(x, axis=-1)

- 目的:主要在多类分类神经网络的输出层中使用,它将输出转换为概率分布。

Tanh(双曲正切):

- 使用:keras.activations.tanh(x)

- 目的:类似于sigmoid,但映射值在-1到1之间。它通常在隐藏层中使用。

Linear(线性):

- 使用:keras.activations.linear(x)

- 目的:它是恒等函数(输入数据不变),通常用于回归任务的输出层。

Leaky ReLU:

- 使用:keras.layers.LeakyReLU(alpha=0.3)

- 目的:ReLU的变体,允许在单元不激活时有一个小梯度。

ELU(指数线性单元):

- 使用:keras.activations.elu(x, alpha=1.0)

- 目的:类似于ReLU,但具有更平滑的曲线,它有助于减少梯度消失问题。

Swish:

- 使用:keras.activations.swish(x)

- 目的:一个较新的函数,在某些情况下表现比ReLU要好。

这些函数可以通过在构建层时在激活参数中指定它们来在Keras中使用。例如,要在密集层中使用ReLU激活函数,你可以使用:

from tensorflow import keras

model = keras.Sequential([

keras.layers.Dense(64, activation='relu'),

# Other layers...

])

激活函数的意义和选择

激活函数的选择至关重要。它会影响网络收敛的能力以及收敛的速度。类似问题的性质(例如,回归、二分类、多分类)、网络架构以及数据的特定特性等因素会指导这一选择。

ReLU及其变体通常是隐藏层的默认选择,因为它们在计算上简单且有效地解决了梯度消失问题。Sigmoid和softmax通常保留用于输出层,因为它们具有概率解释。然而,具体的选择可能会根据实验结果和手头任务的具体细节而变化。

代码

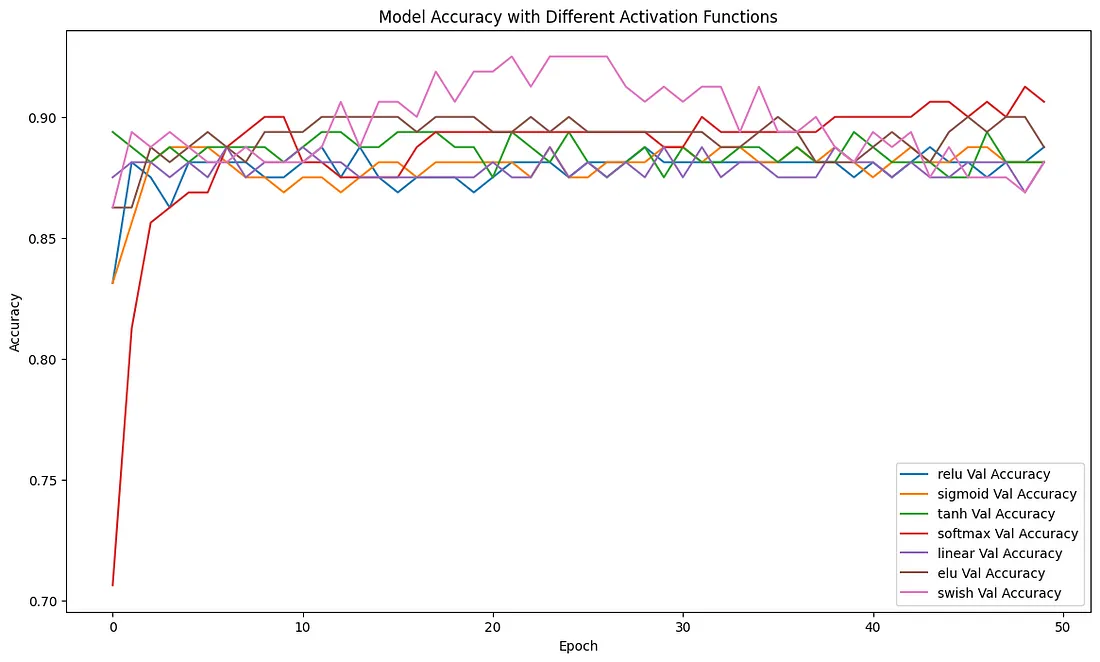

创建一个完整的Python脚本,在Keras中使用合成数据集展示各种激活函数,涉及到几个步骤。我们将生成一个合成数据集,构建不同的带有各种激活函数的模型,训练它们,并最终使用图表比较它们的性能。以下是一个综合性的示例:

import numpy as np

import matplotlib.pyplot as plt

from sklearn.datasets import make_classification

from sklearn.model_selection import train_test_split

from sklearn.metrics import accuracy_score

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import Dense

X, y = make_classification(n_samples=1000, n_features=20, n_classes=2, random_state=42)

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

def build_model(activation_function):

model = Sequential([

Dense(64, input_dim=20, activation=activation_function),

Dense(1, activation='sigmoid')

])

model.compile(optimizer='adam', loss='binary_crossentropy', metrics=['accuracy'])

return model

activations = ['relu', 'sigmoid', 'tanh', 'softmax', 'linear', 'elu', 'swish']

history_dict = {}

for act in activations:

model = build_model(act)

print(f"Training model with {act} activation")

history = model.fit(X_train, y_train, epochs=50, batch_size=10, verbose=0, validation_split=0.2)

history_dict[act] = history

plt.figure(figsize=(14, 8))

for act in activations:

plt.plot(history_dict[act].history['val_accuracy'], label=f'{act} Val Accuracy')

plt.title('Model Accuracy with Different Activation Functions')

plt.ylabel('Accuracy')

plt.xlabel('Epoch')

plt.legend()

plt.show()

这个脚本将为二分类问题创建一个合成数据集,用不同的激活函数构建模型,训练它们,并绘制它们在训练代数上的验证准确性图。

请记住,每个激活函数的有效性可能会根据数据集的性质和模型的具体架构而有所不同。在实践中,通常会尝试使用不同的激活函数和模型架构来找到最适合特定数据集和任务的最佳匹配。

结论

在Keras中的激活函数不仅仅是一个简单的技术细节,而是定义神经网络学习和功能的基本方面。它们引入非线性的能力对于网络理解复杂的和高维数据至关重要。Keras中提供的丰富多样的激活函数赋予了数据科学家和研究人员试验和优化他们的神经网络模型以应对从简单的回归任务到自然语言处理和计算机视觉的复杂性等广泛的应用的能力。随着深度学习领域的发展,新的和改进的激活函数的开发也将会继续,进一步拓展神经网络能够实现的范围。