微软将其小模型Phi-2更新为更宽松的MIT开源许可

微软日前将其于12月发布的27亿参数的小模型「Phi-2」的许可更新为更宽松的 MIT 开源许可,该许可证允许包括商业使用、发行、修改和私人使用在内的广泛权限,唯一的要求是用户必须保留版权和许可证声明。但是Phi-2作为人工智能模型是在“原样”基础上提供,无任何形式的保证,开发者仍然可以按照自己的需要自由使用和改造。

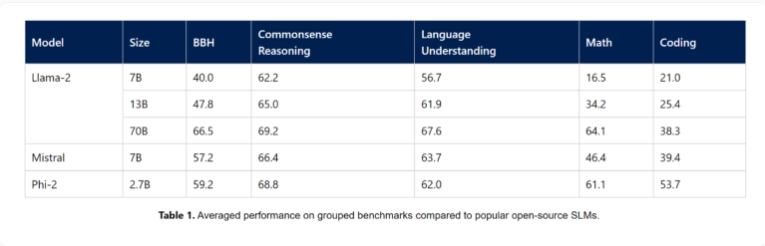

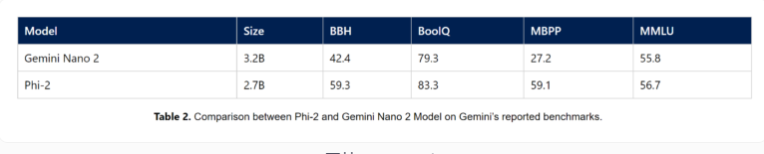

在去年的12月12日,微软公布了更多关于Phi-2的详细信息,包括该公司展示的与神秘7B模型、Llama-2和谷歌的Gemini Nano模型的详细对比基准测试。在所有微软展示的基准测试中,2.7亿参数的Phi-2的表现均优于谷歌的最小语言模型Gemini Nano。

微软还对Phi-2进行了常用提示词的广泛测试,结果显示,“我们观察到的行为符合我们根据基准测试结果所期望的。”

据悉,Gemini Nano将被应用于像Pixel 8这样的终端设备上。

早在2023年11月16日的原初报道中,微软研究人员推出了Phi-1,这是一款基于Transformer的语言模型,参数只有13亿。这个模型仅仅经过高质量数据训练,就在基准测试中超越了体量是其十倍的模型。

不久后,Phi-1.5随之问世,同样具有13亿参数,并接受了包括各种AI生成文本在内的额外数据训练。Phi-1.5能够创作诗歌、撰写电子邮件和故事,并总结文字内容。其中一个变种还具备分析图像的能力。在常识、语言理解和推理的基准测试中,这个模型在某些领域甚至能与多达100亿参数的模型媲美。

之后微软宣布了配备了27亿参数的Phi-2,与其他语言模型相比仍是小巧的。和Phi-1.5相比,该公司表示Phi-2在逻辑推理和安全性方面极大改进。微软声称,经过适当的微调和定制,小型语言模型可以成为云应用和边缘应用的有力工具。

此外,微软还宣布了“模型即服务”。Phi-2和Phi-1.5现已加入Azure AI模型目录,该目录还包含Stable Diffusion、Falcon、CLIP、Whisper V3、BLIP和SAM等模型。微软还添加了来自Meta的Code Llama和来自Nvidia的Nemotron。

“模型即服务”的推出意味着专业开发者很快就能轻松地将诸如Meta的Llama 2等最新AI模型集成到他们的应用程序中,还可以通过API端点形式使用Cohere的Command、G42的Jais以及Mistral的高级模型。开发者也可以在无需担心设置和管理GPU基础架构的情况下,使用自己的数据对这些模型进行微调,从而消除了配置资源和管理托管的复杂性。