开源大模型Mixtral 8x7B的MMLU基准测试领先GPT-3.5

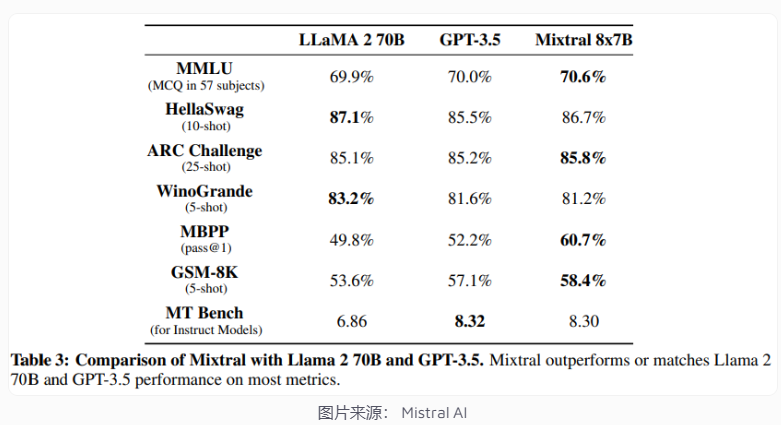

Mistral AI发布了其最新的Mixtral 8x7B语言模型,这一模型的详细架构已在Mixtral 8x7B论文中公布,同时公开了一系列详尽的基准测试成绩,将其与LLaMA 2 70B和GPT-3.5进行了对比。

在广受关注的语言理解基准测试MMLU(Massive Multitask Language Understanding)中,Mixtral的表现超越了上述两款模型。而体型更大的模型如Gemini Ultra或GPT-4在不同提示方法下,分数介乎于85%至90%。

在LMSys排行榜上,即由人类评分AI答案的榜单中,Mixtral 8x7b比Claude 2.1、GPT-3.5以及Google的Gemini Pro稍胜一筹。然而,GPT-4的表现仍然处于明显领先地位。

这反映了过去几个月的一个趋势:对许多组织来说,在达到或略超GPT-3.5级别的模型似乎相对容易,但GPT-4仍然无人能敌。

Mistral宣称Mixtral 8x7B目前为止是市面上最出色的开放式语言模型。

此前,Mistral通过Torrent链接发布了一款新的语言模型。近期,该公司发布了更多有关Mixtral 8x7B模型的细节,并宣布了一个API服务以及新一轮的融资。

据Mistral表示,Mixtral是一个使用Apache 2.0协议的开放权重的稀疏混合专家(Sparse Mixture-of-Experts,SMoE)模型。有传言称OpenAI用类似的架构开发了GPT-4。针对一个查询,Mixtral选择八个参数集中的两个,并且每次推理只使用总参数数的一小部分,从而降低了成本和延迟。具体来说,Mixtral拥有450亿参数,但每个token的推理只使用了120亿参数。这是该初创公司迄今为止的最大模型,去年9月份,该公司发布了相当强大的Mistral 7B模型。

据Mistral所说,Mixtral在大部分基准测试中表现均超过Meta的LLaMA 2 70B,并提供了6倍更快的推理速度。公司还声称,相比Meta模型,Mixtral在真实性和偏见性方面都有所改善。根据Mistral,这使其成为“最强大的开放权重模型,拥有宽松的许可证,并且在成本/性能权衡方面的表现最优”。在标准基准测试中,它的表现也匹敌或超过了OpenAI的GPT-3.5。

Mixtral能够处理多达32000个token的上下文,支持英语、法语、意大利语、德语和西班牙语,并且能够编写代码。

除了基本的Mixtral 8x7B模型,Mistral还推出了Mixtral 8x7B Instruct版本。这一模型经过监督式微调和直接偏好优化(Direct Preference Optimisation,DPO),对精确指令进行了优化。在MT-Bench测试中,该模型取得了8.30分的高分,使其成为性能可与GPT-3.5相媲美的最佳开源模型。

目前,Mixtral正处于Mistral平台的测试阶段。Mistral表示,除了更小的Mistral 7B模型,还有一款性能超过GPT-3.5的更强大的原型模型也在该平台上提供。