ResNeXt:利用宽残差网络彻底改变深度学习

介绍

在不断发展变化的深度学习领域中,ResNeXt架构作为一个关键的创新而崭露头角,它重新定义了卷积神经网络(CNNs)的边界。ResNeXt在基础的ResNet(残差网络)概念之上建立,通过加入“基数”这一维度来引入一种新的方法,除了深度和宽度之外。这篇文章深入探讨了ResNeXt的复杂结构,设计背后的理念,以及它在计算机视觉其他领域的影响。

CNN架构的演变

CNN的发展特点是追求增强特征表示和提高学习效率。ResNet的引入标志着一个重要的里程碑,它通过跳跃连接解决了梯度消失问题,并使训练更深的网络成为可能。然而,追求更高效强大的网络的探索仍在继续,这导致了ResNeXt的诞生。

概念和设计

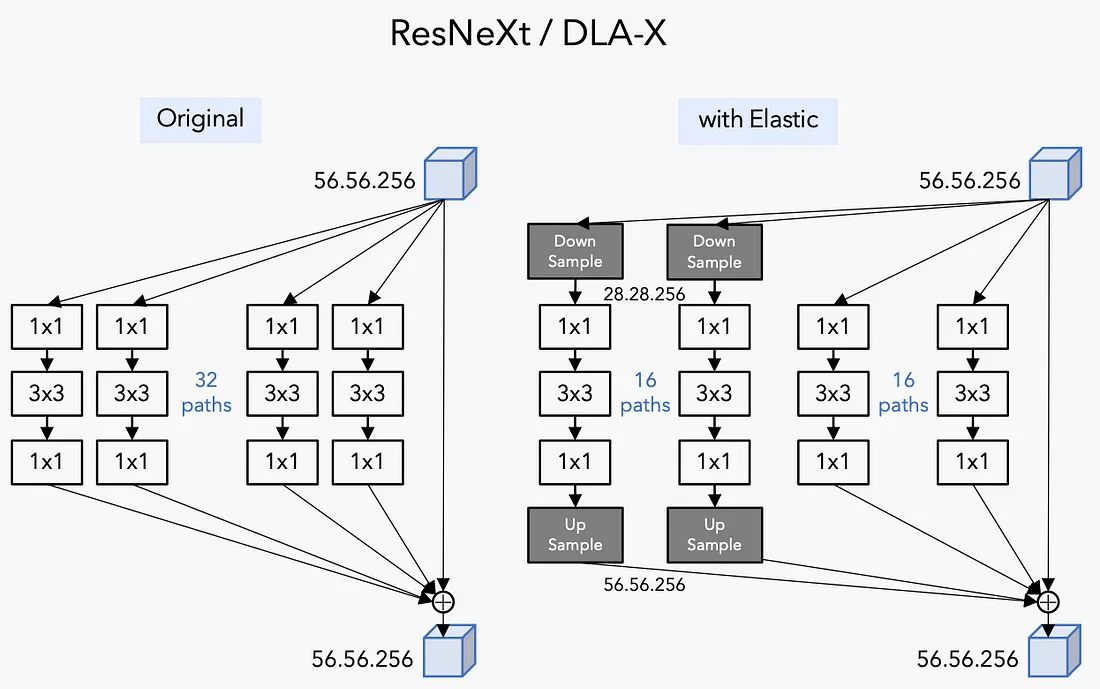

ResNeXt代表“Residual Networks Next”,表明其作为ResNet架构的演化。其核心创新在于引入了基数(cardinality),这是一个代表层中并行路径数量的维度。这种方法受到了Inception网络方法论的启发,但它通过在这些路径中使用相同的变换来简化它。

ResNeXt中的宽残差网络意味着战略性地增加宽度(每层的神经元数量)而不仅仅是深度(层数)。这种策略在不成比例地增加计算复杂性的情况下增强了网络的学习能力。在ResNeXt中,每层包含一组变换,这些变换在最后被聚合起来。这一块结构是网络中的重复单元,它简化了架构,并减少了超参数调整。

ResNeXt是一种卷积神经网络(CNN)架构,它延伸了ResNet(残差网络)架构。ResNeXt的开发旨在通过提高CNN的特征表示学习能力来提高性能。ResNeXt在网络设计中通常使用的深度和宽度之外,引入了一个新的维度,被称为“基数”。这一创新使得模型能够在不显著增加计算复杂性的情况下实现更高的准确率。

以下是它的关键方面的概述:

- 基数:指的是网络层中并行路径的数量。在ResNeXt中,应用了多个较小的变换(一组卷积)并将它们的输出聚合。这个想法类似于Inception网络的工作方式,但更简单且更高效地处理参数。

- 宽残差网络:ResNeXt还整合了宽残差网络的概念。这是ResNet的一个变体,其中层更宽(每层更多神经元)但更浅(层数更少)。与单纯增加深度相比,这种方式更有效,因为它在精度和计算效率之间提供了更好的平衡。

- 块结构:ResNeXt使用一个重复的构建块,它聚集了具有相同拓扑的一组变换。这种一致性简化了网络的架构,并减少了超参数的数量。

- 效率和性能:通过使用分组卷积并专注于基数,ResNeXt在不大幅增加计算成本的情况下提供了改进的性能(在分类准确率方面)。这使得它适用于需要高精度而又不过度使用资源的任务。

- 应用领域:ResNeXt在计算机视觉的各个领域,如图像分类、物体检测和分割等都取得了成功,展示了其多功能性和有效性。

总的来说,ResNeXt代表了CNN架构演变中的一个重要步骤,表明仔细平衡深度、宽度和基数可以带来模型性能的显著提升。

优势和效率

ResNeXt的主要优势之一是其效率。通过使用分组卷积和专注于基数而非仅仅是深度或宽度,可以更好地利用计算资源。这种效率并没有以性能为代价;ResNeXt在图像分类、物体检测和分割等任务中展示了明显的改进,超越了它的前身。

应用和影响

这一架构已在广泛的计算机视觉任务中找到应用。它能够高效地处理复杂的模式和结构,使其适用于从医疗成像到自动驾驶等各个领域的高精度需求。

代码

使用Python和合成数据集实现一个ResNeXt模型,并可视化结果包括几个步骤。下面,我将提供完整的指南和代码片段来帮助你完成此过程。实现将使用如TensorFlow和Keras的库。

- 生成合成数据集 我们将使用NumPy创建一个简单的合成数据集,用于演示目的。

- 定义ResNeXt模型 我们将定义一个简化版的ResNeXt模型。请注意,从头开始构建精确的ResNeXt模型是复杂的,超出了此示例的范围。

- 训练模型 我们将在合成数据集上训练模型。

- 绘制结果 我们将使用Matplotlib绘制训练历史。

以下是实现这些步骤的Python代码:

import tensorflow as tf

from tensorflow.keras.layers import Conv2D, BatchNormalization, Activation, Add.keras.layers import Conv2D, BatchNormalization, Activation, Add

import numpy as np

import matplotlib.pyplot as plt

# Generate Synthetic Dataset

def generate_synthetic_data(num_samples=1000, img_shape=(32, 32, 3)):

X = np.random.rand(num_samples, *img_shape).astype(np.float32)

y = np.random.randint(0, 10, num_samples)

return X, y

X_train, y_train = generate_synthetic_data()

X_test, y_test = generate_synthetic_data()

# Define a Simplified ResNeXt Block

def resnext_block(inputs, filters, cardinality):

convs = []

for _ in range(cardinality):

x = Conv2D(filters, (3, 3), padding='same')(inputs)

x = BatchNormalization()(x)

x = Activation('relu')(x)

convs.append(x)

x = Add()(convs)

x = Conv2D(filters, (1, 1), padding='same')(x)

x = BatchNormalization()(x)

x = Activation('relu')(x)

shortcut = Conv2D(filters, (1, 1), padding='same')(inputs)

shortcut = BatchNormalization()(shortcut)

x = Add()([x, shortcut])

return Activation('relu')(x)

# Model Definition

inputs = tf.keras.Input(shape=(32, 32, 3))

x = resnext_block(inputs, filters=64, cardinality=8)

x = tf.keras.layers.GlobalAveragePooling2D()(x)

outputs = tf.keras.layers.Dense(10, activation='softmax')(x)

model = tf.keras.Model(inputs=inputs, outputs=outputs)

model.compile(optimizer='adam', loss='sparse_categorical_crossentropy', metrics=['accuracy'])

# Train the Model

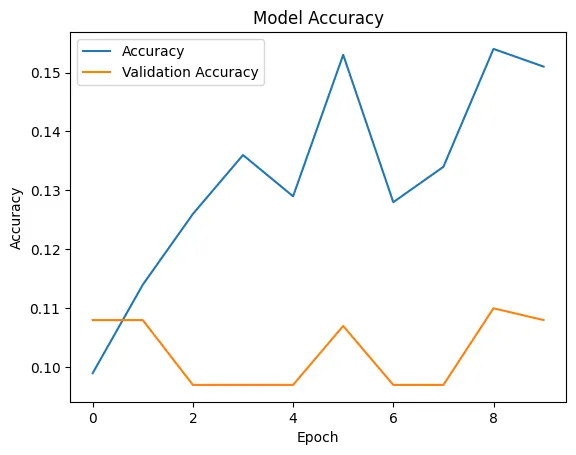

history = model.fit(X_train, y_train, epochs=10, validation_data=(X_test, y_test))

# Plot the Results

plt.plot(history.history['accuracy'], label='Accuracy')

plt.plot(history.history['val_accuracy'], label='Validation Accuracy')

plt.title('Model Accuracy')

plt.ylabel('Accuracy')

plt.xlabel('Epoch')

plt.legend()

plt.show()

Epoch 1/10

32/32 [==============================] - 34s 757ms/step - loss: 2.4287 - accuracy: 0.0990 - val_loss: 2.3127 - val_accuracy: 0.1080

Epoch 2/10

32/32 [==============================] - 24s 754ms/step - loss: 2.3052 - accuracy: 0.1140 - val_loss: 2.3871 - val_accuracy: 0.1080

Epoch 3/10

32/32 [==============================] - 29s 914ms/step - loss: 2.2912 - accuracy: 0.1260 - val_loss: 2.4742 - val_accuracy: 0.0970

Epoch 4/10

32/32 [==============================] - 24s 767ms/step - loss: 2.2891 - accuracy: 0.1360 - val_loss: 2.5461 - val_accuracy: 0.0970

Epoch 5/10

32/32 [==============================] - 29s 905ms/step - loss: 2.2839 - accuracy: 0.1290 - val_loss: 2.5983 - val_accuracy: 0.0970

Epoch 6/10

32/32 [==============================] - 29s 913ms/step - loss: 2.2824 - accuracy: 0.1530 - val_loss: 2.6647 - val_accuracy: 0.1070

Epoch 7/10

32/32 [==============================] - 23s 727ms/step - loss: 2.2811 - accuracy: 0.1280 - val_loss: 2.6787 - val_accuracy: 0.0970

Epoch 8/10

32/32 [==============================] - 24s 736ms/step - loss: 2.2742 - accuracy: 0.1340 - val_loss: 2.6749 - val_accuracy: 0.0970

Epoch 9/10

32/32 [==============================] - 30s 937ms/step - loss: 2.2693 - accuracy: 0.1540 - val_loss: 2.6836 - val_accuracy: 0.1100

Epoch 10/10

32/32 [==============================] - 25s 795ms/step - loss: 2.2665 - accuracy: 0.1510 - val_loss: 2.7231 - val_accuracy: 0.1080

结论

ResNeXt代表了神经网络设计上的一个重大进步。通过平衡深度、宽度和基数,它实现了高水平的准确性和效率,并解决了深度学习中的一些关键挑战。随着该领域的不断发展,像ResNeXt这样的架构将在解锁新潜能和应用领域中发挥关键作用,推动人工智能能够实现的界限进一步扩展。