软件工程重用原则在深度学习模型开发的应用

介绍

科技领域的持续变化不断地带来新的挑战与机遇。其中一个机遇源于传统软件工程原则与新兴的深度学习领域的交汇。尤其是程序复用原则,它是高效有效软件开发的基石,为深度学习方法论的进步提供了宝贵的见解。本文探讨了这一原则在深度学习中的应用,讨论了在软件工程中锤炼的实践如何显著增强深度学习模型的开发和性能表现。

了解软件工程中的过程重用

软件工程中的程序重用是指系统地重用代码、算法和过程的实践,以提高效率,减少错误,并确保对问题解决采用一致的方法。这一原则强调了不必“重新发明轮子”,而是利用现有的、经过验证的组件的重要性。它的好处有很多:加速开发时间、减少成本、提高可靠性和生产率。

深度学习—新领域

深度学习是机器学习的一个子集,涉及对大型数据集训练人工神经网络以执行像图像和语音识别等任务。它已经彻底改变了计算机视觉、自然语言处理和预测分析等领域。然而,深度学习模型通常是复杂的、资源密集型的,并且需要大量专业知识来开发和调整。

模块化网络设计—重用的基础

在深度学习中,模块化网络设计类似于在软件中使用函数和库,可以促进程序重用。通过开发和使用可重用的模块或层,例如在不同模型中用于特征提取的卷积层,可以维持效率和一致性,反映了软件工程中代码重用的做法。

迁移学习—相当于预建库

在深度学习中,迁移学习类似于在软件工程中使用预建库。它涉及将为一个任务开发的模型作为另一个任务的起点。这不仅节省了时间和资源,还提供了一个坚实的基础,利用了之前学到的特征。

采用标准化数据处理

正如软件工程推广数据处理的标准程序,深度学习也受益于统一的数据预处理和增强技术。这确保了模型在统一格式的数据上进行训练,提高了模型的可靠性和性能。

参数共享和全局变量

神经网络中的参数共享类似于在软件工程中使用全局变量。它涉及在模型的不同部分使用相同的参数以维持一致性并减少计算占用,映射了软件工程对资源效率的方法。

模型检查点和序列化—保存进展

在软件开发中,版本控制至关重要。同样,通过保存模型在训练过程中的各个阶段(检查点)和序列化(以可重用格式存储模型)可以确保进度不会丢失,而且将来可以重用或在此基础上构建模型。

利用框架和工具

深度学习已经从像TensorFlow和PyTorch这样的框架中受益匪浅,这些框架简化了模型的构建和部署。这些工具是软件开发框架的深度学习等价物,提供了开发复杂系统的标准化、高效方式。

软件工程中的程序重用原则是一个强调重用代码和程序以提升效率、减少错误和确保一致性重要性的概念。当应用于深度学习模型时,这一原则可以非常有益。以下是如何做:

- 模块化网络设计:类似于在软件工程中使用函数和库,深度学习模型可以设计成可重用的模块或层。例如,可设计特定层或子模型来处理特定任务(如图像特征提取、语言处理等),并且可以跨不同模型重用。

- 迁移学习:这类似于在软件工程中使用预建库。在深度学习中,迁移学习涉及使用为一个任务开发的模型作为第二个任务上模型的起点。这样重用了学到的特征,并减少了对大量训练数据和计算资源的需要。

- 标准化数据处理:正如软件工程促进数据处理标准程序一样,深度学习从标准化的数据预处理和增强技术中受益。这确保了数据以一致有效的方式输入模型。

- 参数共享:涉及在模型的不同部分使用相同的参数(在神经网络中是权重和偏差)。这类似于在软件工程中使用全局变量或常量来维持一致性并减少内存使用。

- 模型检查点和序列化:在软件中,代码常常保存在版本控制系统中。同样,深度学习模型可以在训练的不同阶段保存(检查点),并且可以序列化(保存在可以重新加载和使用的格式中),促进了重用。

- 框架和工具:正如软件开发通过框架和工具来促进一样,深度学习也从像TensorFlow、PyTorch、Keras等库和框架中获益,这些工具标准化并简化了构建和部署模型的过程。

- 最佳实践和设计模式:在软件工程中,已经建立了最佳实践和设计模式。同样,在深度学习中,某些架构模式和实践(如用于正则化的dropout、批量归一化等)被发现是有效的,并被广泛重用。

本质上,软件工程中的程序重用原则可以通过推广可重用、模块化和标准化的实践,显著影响并提高深度学习模型的开发、效率和效果。

代码

为了展示如何将软件工程中的程序重用原则应用到使用Python的深度学习模型,让我们创建一个示例,在这个示例中,我们将使用合成数据集构建一个简单的深度学习模型。我们将关注的重点是重用代码和程序,类似于软件工程中的原则。我们将使用像TensorFlow这样的常见库来说明这一点。

import numpy as np

import tensorflow as tf

import matplotlib.pyplot as plt

from sklearn.model_selection import train_test_split

from sklearn.datasets import make_classification

X, y = make_classification(n_samples=1000, n_features=20, n_classes=2, random_state=42)

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

def build_model(input_shape, layers, activation='relu', output_activation='sigmoid'):

model = tf.keras.models.Sequential()

model.add(tf.keras.layers.InputLayer(input_shape=input_shape))

for units in layers:

model.add(tf.keras.layers.Dense(units, activation=activation))

model.add(tf.keras.layers.Dense(1, activation=output_activation))

return model

model = build_model(input_shape=(20,), layers=[64, 64])

model.compile(optimizer='adam', loss='binary_crossentropy', metrics=['accuracy'])

history = model.fit(X_train, y_train, epochs=10, validation_split=0.1)

loss, accuracy = model.evaluate(X_test, y_test)

print(f"Test Accuracy: {accuracy*100:.2f}%")

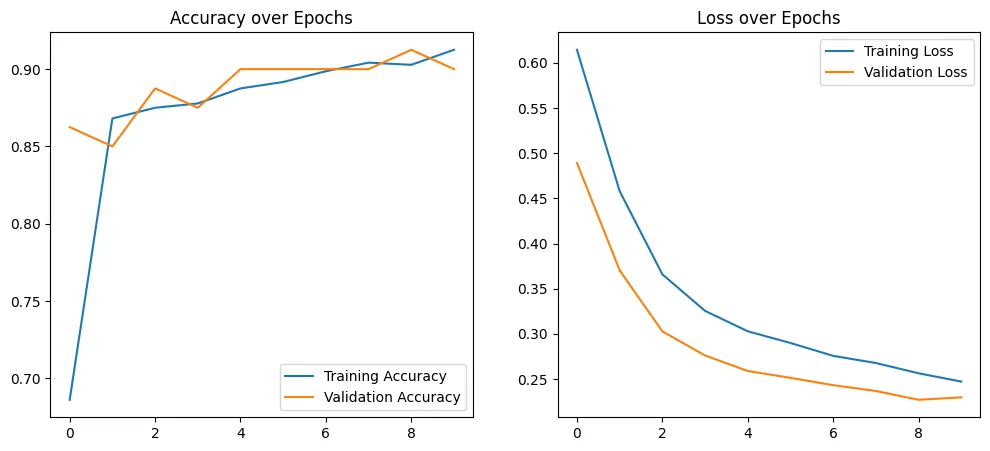

plt.figure(figsize=(12, 5))

plt.subplot(1, 2, 1)

plt.plot(history.history['accuracy'], label='Training Accuracy')

plt.plot(history.history['val_accuracy'], label='Validation Accuracy')

plt.title('Accuracy over Epochs')

plt.legend()

plt.subplot(1, 2, 2)

plt.plot(history.history['loss'], label='Training Loss')

plt.plot(history.history['val_loss'], label='Validation Loss')

plt.title('Loss over Epochs')

plt.legend()

plt.show()

Epoch 1/10

23/23 [==============================] - 2s 23ms/step - loss: 0.6144 - accuracy: 0.6861 - val_loss: 0.4892 - val_accuracy: 0.8625

Epoch 2/10

23/23 [==============================] - 0s 6ms/step - loss: 0.4580 - accuracy: 0.8681 - val_loss: 0.3704 - val_accuracy: 0.8500

Epoch 3/10

23/23 [==============================] - 0s 4ms/step - loss: 0.3660 - accuracy: 0.8750 - val_loss: 0.3028 - val_accuracy: 0.8875

Epoch 4/10

23/23 [==============================] - 0s 5ms/step - loss: 0.3255 - accuracy: 0.8778 - val_loss: 0.2762 - val_accuracy: 0.8750

Epoch 5/10

23/23 [==============================] - 0s 9ms/step - loss: 0.3030 - accuracy: 0.8875 - val_loss: 0.2590 - val_accuracy: 0.9000

Epoch 6/10

23/23 [==============================] - 0s 6ms/step - loss: 0.2900 - accuracy: 0.8917 - val_loss: 0.2514 - val_accuracy: 0.9000

Epoch 7/10

23/23 [==============================] - 0s 5ms/step - loss: 0.2758 - accuracy: 0.8986 - val_loss: 0.2433 - val_accuracy: 0.9000

Epoch 8/10

23/23 [==============================] - 0s 5ms/step - loss: 0.2678 - accuracy: 0.9042 - val_loss: 0.2369 - val_accuracy: 0.9000

Epoch 9/10

23/23 [==============================] - 0s 8ms/step - loss: 0.2565 - accuracy: 0.9028 - val_loss: 0.2272 - val_accuracy: 0.9125

Epoch 10/10

23/23 [==============================] - 0s 4ms/step - loss: 0.2473 - accuracy: 0.9125 - val_loss: 0.2299 - val_accuracy: 0.9000

7/7 [==============================] - 0s 3ms/step - loss: 0.3578 - accuracy: 0.8750

Test Accuracy: 87.50%

这个例子展示了如何在深度学习中应用程序重用原则的过程。build_model 函数是这个原则的体现,允许通过使用相同的代码结构来创建具有不同架构的多种模型。这种方法提升了代码效率和可维护性,反映了软件工程中的核心实践。

结论

软件工程中的程序重用原则提供了一系列的实践,这些实践可以适应并增强深度学习领域。通过采用模块化设计、迁移学习、标准化数据处理、参数共享、模型序列化以及使用健壮的框架等概念,深度学习可以实现更高的效率、可扩展性和有效性。这种跨学科的方法不仅加速了深度学习的发展,还展示了如何创新地将一个领域的原则应用于另一个领域,从而在技术领域内促进了相互增益的成长。