LLM的随机思路和提炼自我评估能力

介绍

在过去几个月内发布的与大型语言模型(LLM)相关的研究,一些趋势正在浮现出来。这些趋势可以被视为在研究界形成的普遍共识,它们涉及到生成应用程序最有效的方式。

复杂性

在将推理数据处理、准备并传递给LLM的方式中引入了更复杂的机制。将任务分解为子任务的通用方法正在成为实际标准;同时执行诸如自我解释、计划以及其他数据相关任务的提示工程技术。

基于LLM的应用正在利用提示管道、代理、链接等多种方式。

基于LLM的任务

一些数据和其他结果相关的任务被卸载到LLM上。这可看作是一种LLM编排,将过去可能由人类监督或通过其他流程管理的任务,交给LLM来处理。

例如,在数据缺乏时,LLM可以用来生成合成数据、生成解释、任务分解和规划。对比链等更多内容。

上下文学习(ICL)

一项新的研究主张,突现能力并不是隐藏的或未发布的模型能力,只是等待被发现的,而是正在开发的上下文学习的新方法。

为了成功利用上下文学习,在推理阶段需要将高度上下文相关的参考信息传递给LLM。

人类反馈

最近的研究开始强调采用以数据为中心的方法的重要性,利用人类审查和标注的数据。尤其是随着微调变得更加易于访问,良好的数据实践将变得至关重要。

可检查性与可观测性

基于LLM的实现可以大致分为两类:梯度和非梯度。

数据可以在两个阶段传递给LLM:在模型训练(梯度)期间或在推理(无梯度)时。

模型训练创建、改变并调整底层的机器学习模型。该模型也被称为具有确定时间戳的固定时间点的模型。这通常是一个不透明的过程,可检查性和可观测性有限。

之所以倾向于非梯度方法,是因为这种方法的透明和可观测性。

推理是查询LLM并由模型随后生成响应的时刻。这也被称为无梯度方法,因为底层模型并未经过训练或改变。

通过RAG、提示管道、自治代理、提示链接和提示工程技术,可以提供上下文和对话结构。

考虑随机CoT

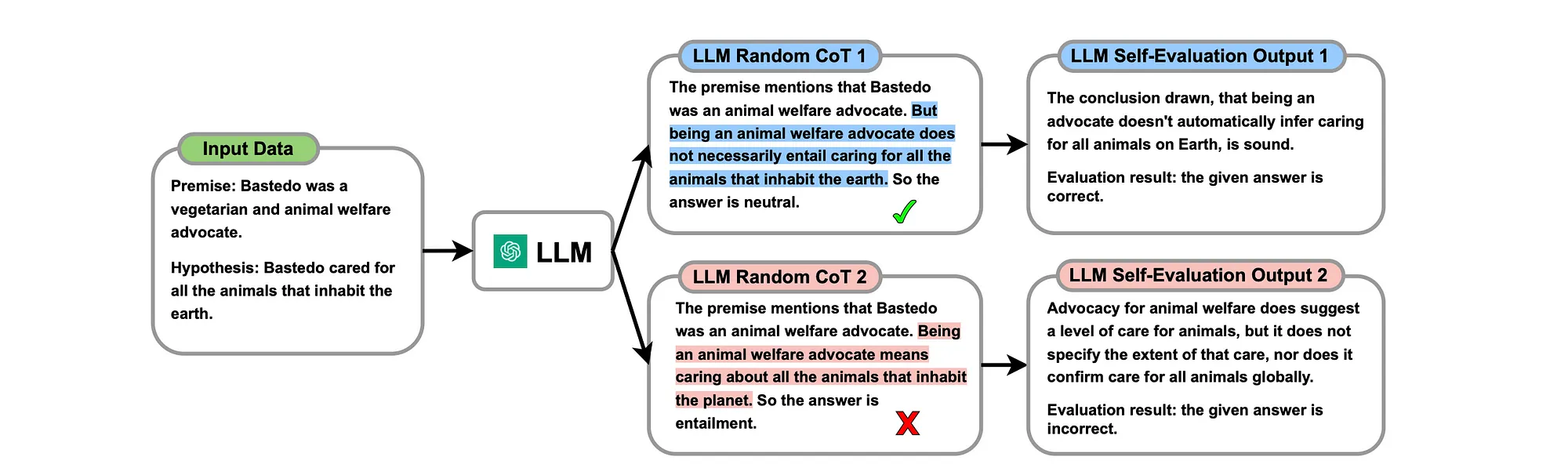

考虑下图,LLM生成了多个CoT响应,并伴随自我评估。这些响应是通过自然语言在推理时生成的。

研究指出,LLM类人的自我评估能力使LLM能够自行评估生成的CoT推理的正确性;并识别哪些是正确的(以蓝色高亮显示),哪些是错误的(以红色高亮显示)。

这一概念再次说明了我在本文早些时候描述的原则是如何应用到利用LLM(大型语言模型)进行任务以改进推理结果的。

提炼自我评估能力 & 全面思考

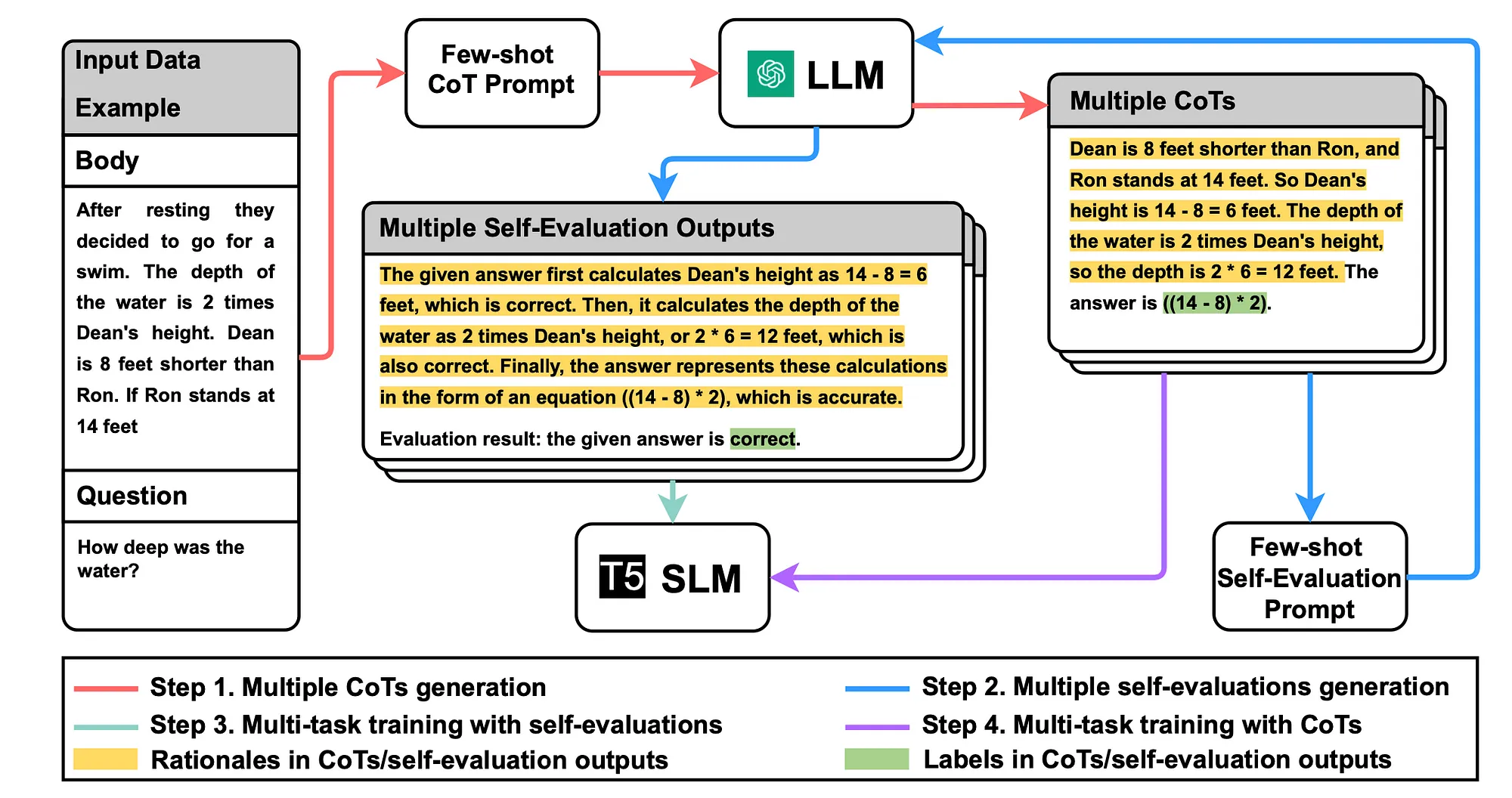

步骤1

从LLM获得多个CoT(推理链)。

使用未标记的数据集,设计CoT提示模板来描述应该如何接近任务。

提示模板包含了少数示例的CoT。按照CoT方法,每个示例都包括了一个三元组:

- 示例输入

- 伪标签

- 以及用户提供的解释分类的理由。

步骤2

从LLM获取多个自我评估输出。

步骤3

用多个自我评估输出来训练SLM(小型语言模型),赋予SLM区分对错的能力。

步骤4

用多个CoT来训练SLM,给SLM全面的推理能力。

成功整合了自我评估能力之后,重点转移至从LLM获得的各种CoT,旨在训练SLM内化多样的推理链。

这种双管齐下的训练方案确保了SLM不仅仅是在复述能力,而是更多的沉浸在内省的自我评估和对多样推理的细腻理解中,反映出LLM的高级认知能力。

在使用LLM(大型语言模型)生成了多样化的CoT(证据链)及其对应的自我评估输出后,开始训练SLM(小型语言模型)的过程。

SLM的训练方法首先强调提炼自我评估能力,为减少CoT中的错误对SLM的影响奠定基础,然后通过多样化CoT提炼, 加入全面的推理能力。

总结

LLM提炼包括多种方法,这些方法利用一个或多个大型模型来指导一个小型模型完成特定任务。在这项研究的背景下,它被称为一个SLM(小型语言模型)...

在最基本的形式中,LLM提炼是通过指导一个LLM为先前未标记的数据分配标签来启动的。这个带标签的数据集成为小型模型的训练集。

这种方法可以用来利用能力较弱、更小、更便宜或功能不那么强大的模型。模型的NLG(自然语言生成)能力和基本逻辑得到了利用,而缺乏知识密集型的NLP(KI-NLP)组件。

数据准备再次成为这种方法的关键,由LLM生成的伪标签可以用来指导小型模型,但最好使用人类注释的标签;或至少在人类监督下使用。