增量FastPitch:一种低延迟的实时语音合成模型

为了实现即时的语音合成,通常采用并行的文本到语音(TTS)模型,它们比传统的自回归模型具有更强的控制和更快的合成速度。但是,并行模型,尤其是基于变换器架构的模型,在增量合成方面存在困难。这是因为它们的结构是完全并行的。随着实时和流式应用的日益普及,需要能够增量地生成语音的TTS系统,满足流式TTS的需求。这对于实现更低的响应延迟和提高用户体验是非常重要的。

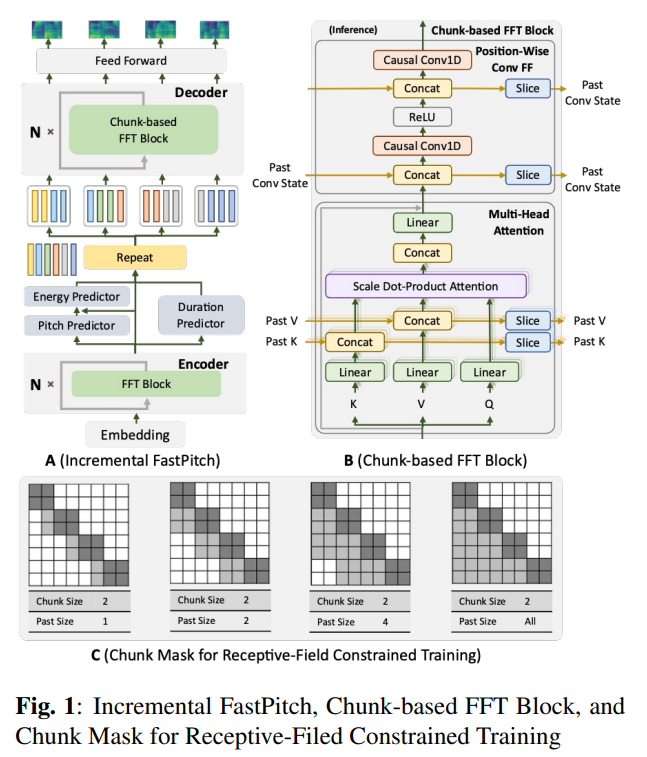

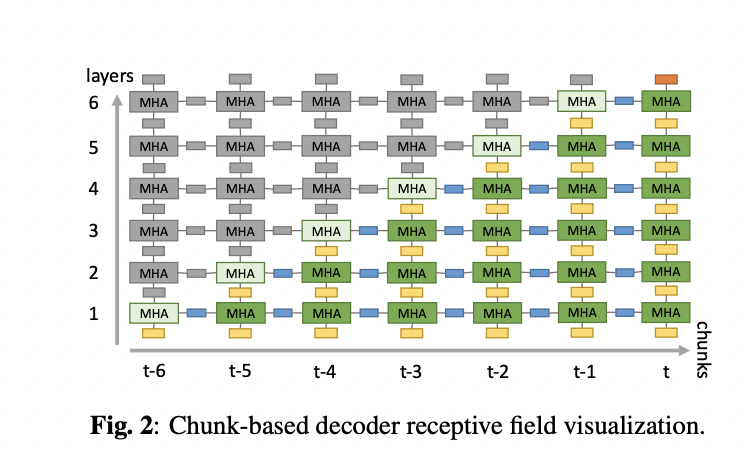

NVIDIA公司的研究人员提出了一种FastPitch的变体,叫做增量FastPitch,它可以增量地生成高质量的Mel块,用于实时的语音合成,具有更低的延迟。所提出的模型通过在解码器中引入基于块的FFT模块改进了架构,使用受感受野限制的块注意力掩码进行训练,使用固定大小的过去模型状态进行推理。这使得与并行FastPitch相当的语音质量,但大大降低了延迟。它采用了受限的感受野训练,并探索了静态和动态块掩码的使用。这对于确保模型在合成过程中有效地与有限的感受野推理对齐是非常重要的。

一个神经TTS系统通常包括两个主要的组成部分:一个声学模型和一个声码器。这个过程从使用像Tacotron 2, FastSpeech, FastPitch和GlowTTS这样的声学模型将文本转换成Mel-频谱图开始。然后,使用像WaveNet, WaveRNN, WaveGlow和HiF-GAN这样的声码器将Mel特征转换成波形。这项研究还提到使用中国标准普通话语音语料库进行训练和评估,该语料库包含了一个单一的普通话女性说话者的10,000个音频片段。所提出的模型参数遵循开源的FastPitch实现,对解码器进行了修改,使用了因果卷积在逐位置前馈层。

增量FastPitch是FastPitch的一个变体,它能够以高质量的Mel块的增量合成,用于实时的语音合成,具有更低的延迟。该模型在训练过程中使用受感受野限制的块注意力掩码,这有助于解码器适应增量推理中的有限感受野。所提出的模型还在推理过程中利用固定大小的过去模型状态,以保持块之间的Mel连续性。中国标准普通话语音语料库训练和评估了该模型。模型参数遵循开源的FastPitch实现,使用了因果卷积在逐位置前馈层。Mel-频谱图是通过对归一化的波形应用FFT大小为1024,跳跃长度为256,窗口长度为1024来生成的。

实验结果表明,增量FastPitch可以产生与并行FastPitch相当的语音质量,但具有显著更低的延迟,使其适合实时语音应用。所提出的模型结合了基于块的FFT模块,受感受野限制的块注意力掩码训练,以及固定大小的过去模型状态推理,有助于提高性能。一个可视化的消融研究表明,增量FastPitch可以生成与并行FastPitch几乎没有可观察差异的Mel-频谱图,突出了所提出的模型的有效性。

总之,增量FastPitch是FastPitch的一个变体,它能够以低延迟实现高质量的Mel块的增量合成,用于实时语音应用。所提出的模型结合了基于块的FFT模块,受感受野限制的块注意力掩码训练,以及固定大小的过去模型状态推理,导致了与并行FastPitch相当的语音质量,但具有显著更低的延迟。一个可视化的消融研究表明,增量FastPitch可以生成与并行FastPitch几乎没有可观察差异的Mel-频谱图,突出了所提出的模型的有效性。模型参数遵循开源的FastPitch实现,对解码器进行了修改,使用了因果卷积在逐位置前馈层。增量FastPitch提供了一个更快和更可控的语音合成过程,使其成为实时应用的一个有前途的方法。