利用Analytics.gov上的MLOps加速机器学习和人工智能的影响

Analytics.gov 简介

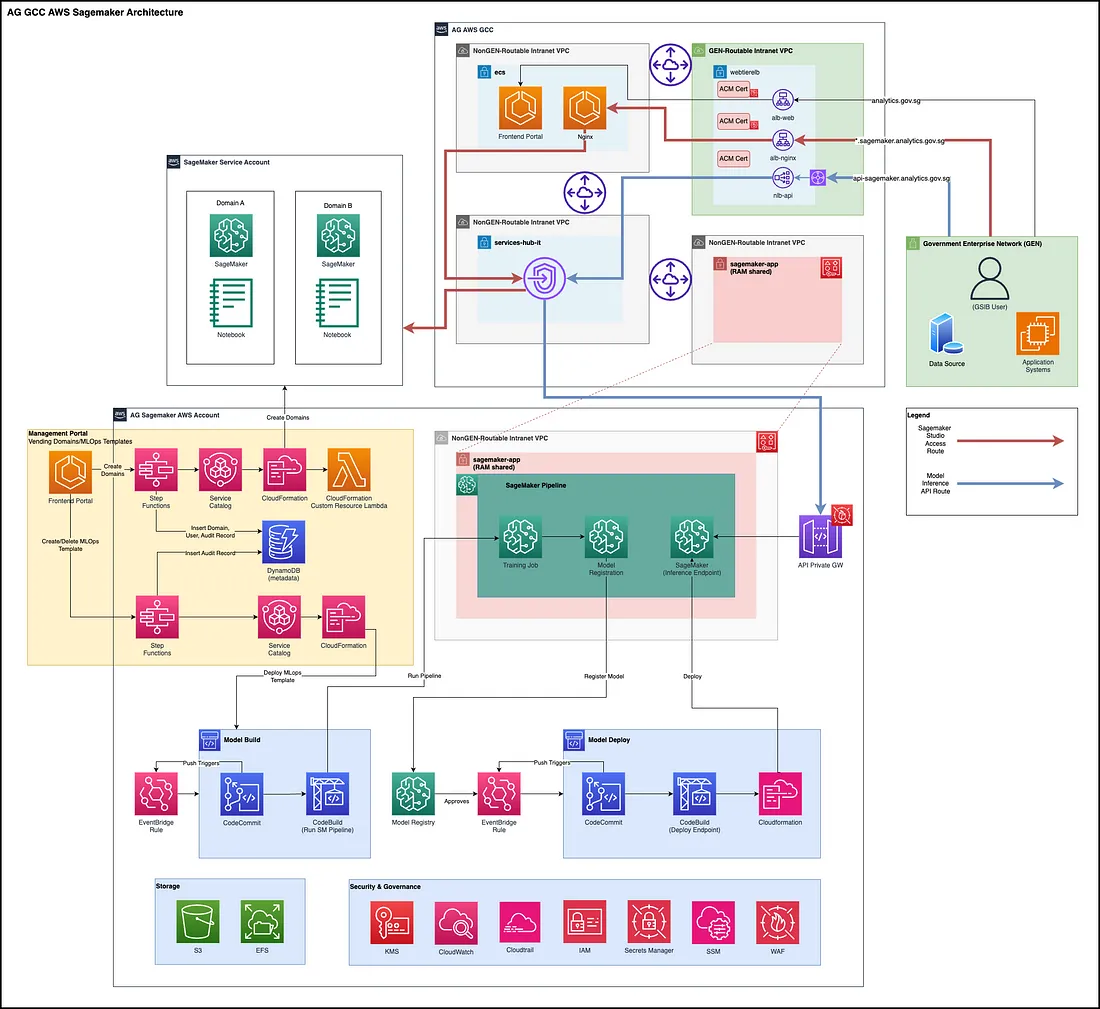

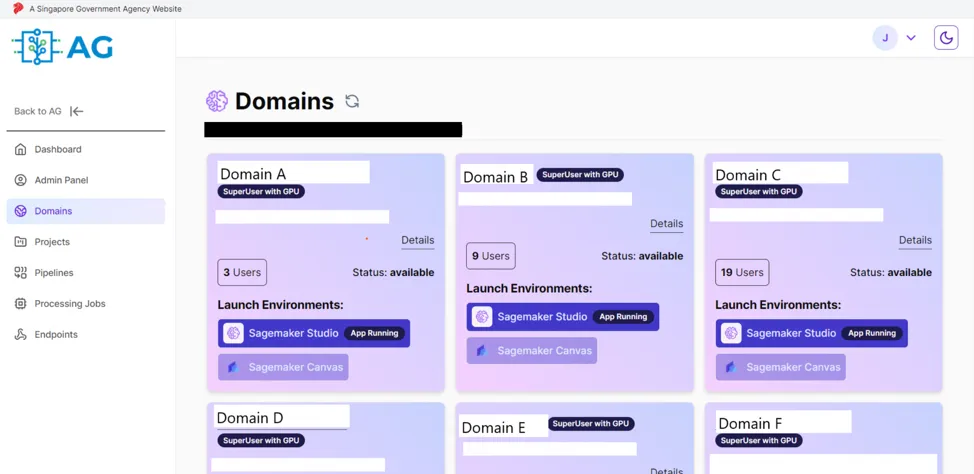

Analytics.gov(以下简称AG),由数据科学和人工智能部门(DSAID)开发,是新加坡政府机构提供中心化安全数据开发平台,支持符合标准架构和安全平台中的高级分析和机器学习用例。AG已从本地部署扩展到基于政府商业云(GCC)2.0的云环境,以提供更大的规模、性能和资源弹性。到目前为止,AG通过消除利用高级分析的障碍,促进协作,并扩展AI/ML计划,已支持超过2000名用户跨越80个机构。劳动部、外交部、住房与发展局以及技能未来新加坡等几个部门和法定机构已经加入了Analytics.gov,并自亚马逊SageMaker服务近期发布以来积极开展他们的AI/ML用例工作。这包括自动化机器学习流程、获取不断扩张的生成式AI模型选择,以及无代码机器学习工具。

为何选择MLOps

MLOps,即机器学习运营的简称,涵盖了用于简化和自动化生产环境中机器学习模型的部署、监控和管理的实践和工具。它关注整个机器学习的生命周期,从模型开发到部署和持续维护,强调协作、可复现性和可扩展性。

在公共部门,毫无疑问,AI/ML技术已经在政策制定、服务交付和内部运营等方面转变了许多政府机构——政策制定者能更好地理解复杂问题,像聊天机器人和摘要生成器这样的AI驱动服务可以被使用,重复性任务可以自动化以提高工作效率和生产力。虽然将AI/ML整合到核心业务流程的需求正在快速增长,但在整个政府(WOG)中仍普遍存在一个共同的差距——许多政府机构的AI/ML模型停留在原型阶段。数据科学家通常缺乏IT部署的专业知识,尤其是在政府运营的更严格的法规背景下。此外,一旦这些模型部署,仍需要持续监控和重新训练以确保它们性能的最优化。这通常需要一个超越数据科学家的团队,团队中还包括数据工程和开发运营(简称devops)等领域的其他技术专家。这就是MLOps的价值所在,它旨在确保模型的高效部署、现实世界应用的规模性和可靠性,持续监控和模型性能治理,通过工作流自动化积极预识别问题和成本优化。归根结底,MLOps是关于实现机器学习的运营化,使组织能够有效地管理和从他们的机器学习计划中获得价值。

AG现在引入端到端的机器学习运营(MLOps)能力,使机构能够高效地开发、测试和大规模部署AI/ML模型。

加速住房和发展局的MLOps采用

在本文的其余子部分中,我们将通过住房和发展局的用例作为例子来阐述AG的MLOps能力,他们利用我们的平台来开发、部署和管理他们的机器学习模型。

一个基于R的二手房产估值机器学习模型原先由HDB官员手动刷新,并部署到本地服务器上进行生产化操作。该设置限制了机器学习开发的鲁棒性、可扩展性和敏捷性。通过AG,HDB得以在GCC 2.0中开发他们的模型,为每个模型进行版本管理,并通过政府企业网络(GEN)平台上可用的REST接口,以可扩展和稳健的方式部署模型。

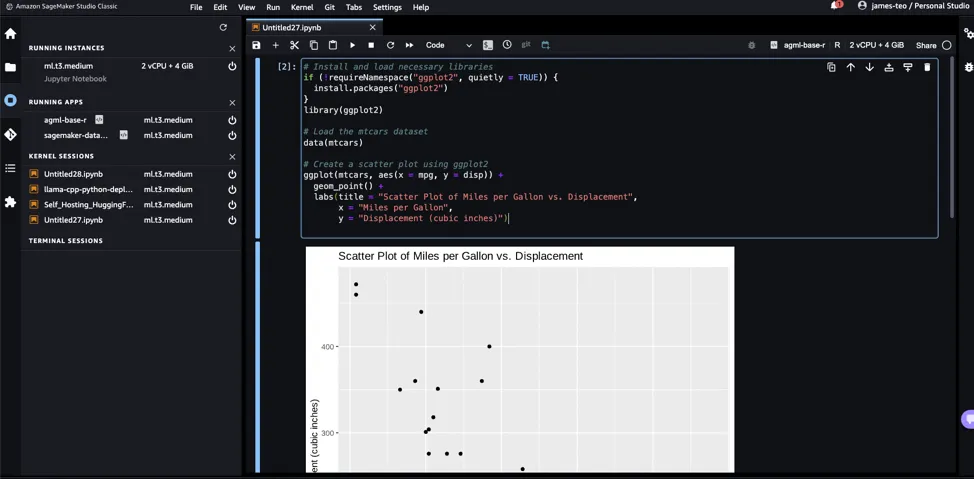

在SageMaker Studio通过AG进行模型开发

通过使用 AG,HDB 的数据科学家利用 SageMaker Studio 能够突破个人笔记本电脑的计算限制,加速模型开发和训练工作流程。在 SageMaker Studio 上的 AG 环境为 WOG 的数据科学家提供了访问最新的 Python 和 R 库的能力,同时确保遵守政府安全协议。每个进入 SageMaker Studio 的团队,AG 都提供了资源和访问的领域级隔离,允许在团队层面跟踪资源消耗,并在团队之间分离资源访问。还通过 AWS Backup 和 AWS DataSync 实施了数据恢复解决方案,该数据恢复解决方案确保了在意外删除的情况下能迅速访问以前的 SageMaker 配置文件和文件恢复。这种集成加强了用于存储 AG 用户文件的 Amazon Elastic File System (EFS) 的备份策略,增强了关键机器学习工作负载的弹性和可用性。

具体来说,HDB 团队利用 SageMaker 的 R 内核支持,加上 AG 与 GEN 和 WOG 活动目录的无缝集成。这使得 HDB 的 R 开发者能够方便地使用现有的凭据访问工作室资源,并在安全经过测验并集中维护的平台上构建。数据科学家可以专注于使用 R 快速构建模型,同时从扩展的云计算中获益,并且减轻身份验证和平台安全性的不同化重负。为了启用 R 语言的交互式开发,AG 提供了一个定制的 R 内核映像,这使得数据科学和机器学习开发能够通过交互式的 Studio 环境进行。

在工作室环境内,数据科学家可以轻松地上传数据集到被管理且团队隔离的Amazon EFS目录中,运行交互式R语言会话,与其他AWS服务集成,比如Amazon S3和S3访问点,以实现潜在的系统间集成,并且将他们的数据科学工作扩展成成熟的MLOps工作流。除了定制的R环境之外,AG还提供了其他预构建的内核和镜像用于在交互式JupyterLab环境中进行模型开发,比如使用诸如PyTorch和HuggingFace这样的框架进行基于Python的开发工作,这是在NVIDIA GPU等加速计算能力之上进行的。

在AG上部署机器学习模型

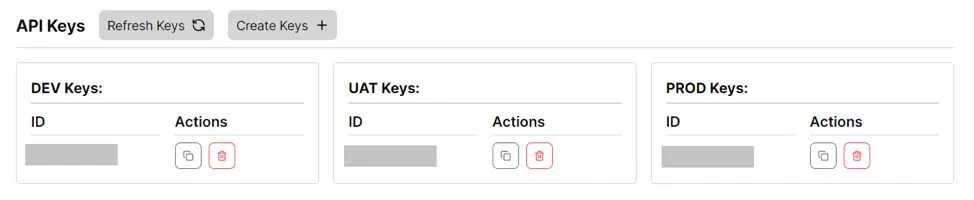

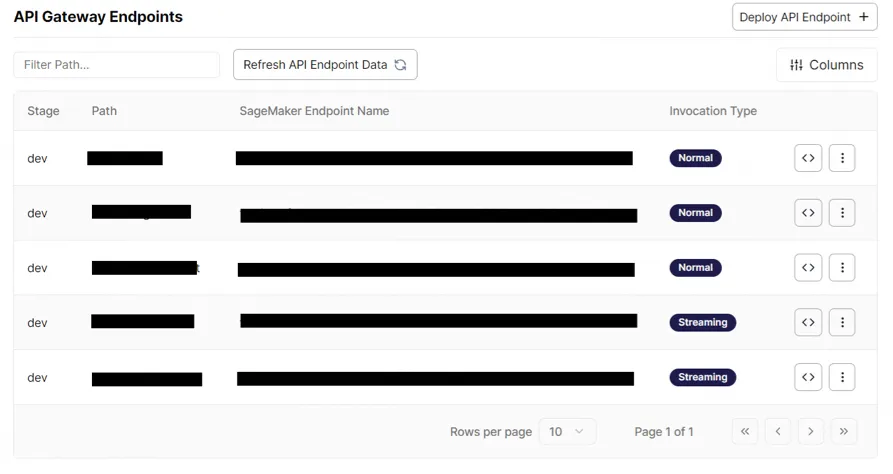

为了将其模型投入生产使用,HDB利用与Amazon API Gateway集成的SageMaker端点实现安全访问。SageMaker端点提供了一个可扩展的托管环境,以高效部署通过SageMaker Studio开发出的模型。HDB数据科学家成功地将他们基于R的模型打包,以便与SageMaker推理兼容,使用了Rplumber框架,并在AG团队的指导下完成这一过程。这种打包展示了SageMaker推理通过AG的广泛适用性,能够为在其他环境上首先开发出来的定制R模型提供服务。SageMaker端点还能够部署来自其他非R框架和库的模型,包括广泛使用的基于Python的框架,如PyTorch、HuggingFace转换器和scikit-learn。

此时,端点通过亚马逊API网关进行访问,该网关集中配置以强制执行认证访问。新加坡建屋发展局(HDB)没有管理自己的API基础设施,而是利用了亚马逊网关(AG)的推理服务,轻松地在模型调用前提供一个认证层。通过处理API的认证、节流和监控,亚马逊API网关整合最大限度地减少了HDB在交付适用于生产用例的机器学习模型服务方面的开销。此外,通过GCC 2.0传输网关到亚马逊API网关的网络整合,部署在AG上的SageMaker端点可以被GEN中的系统无缝调用。通过API网关访问的AG模型也通过AWS Web应用程序防火墙(WAF)进行了保护,确保了对潜在的网络应用威胁和脆弱性的强大保护。SageMaker端点、亚马逊API网关以及网络和防火墙的整合,简化了HDB的机器学习模型从开发、部署到消费的部署过程,展示了AG的全流程端到端能力。

AG内的端到端机器学习运维(MLOps)工作流程

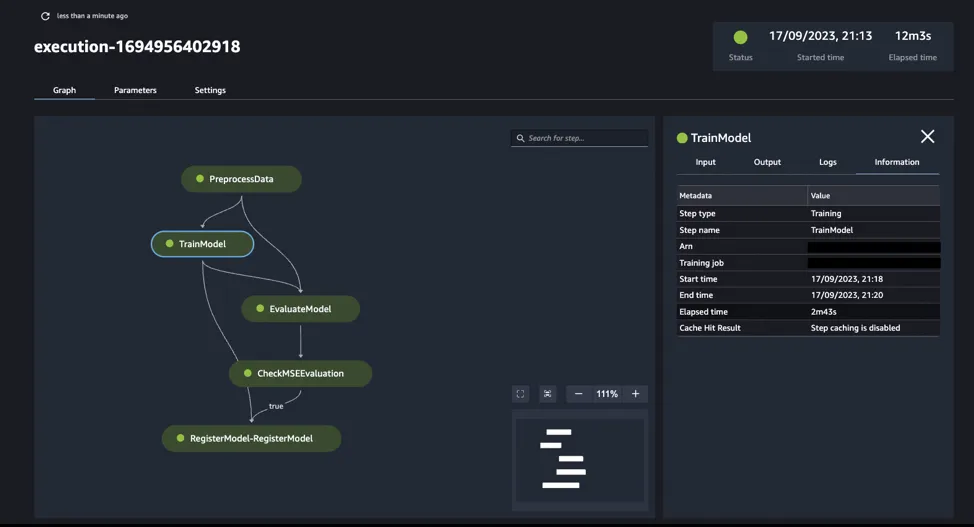

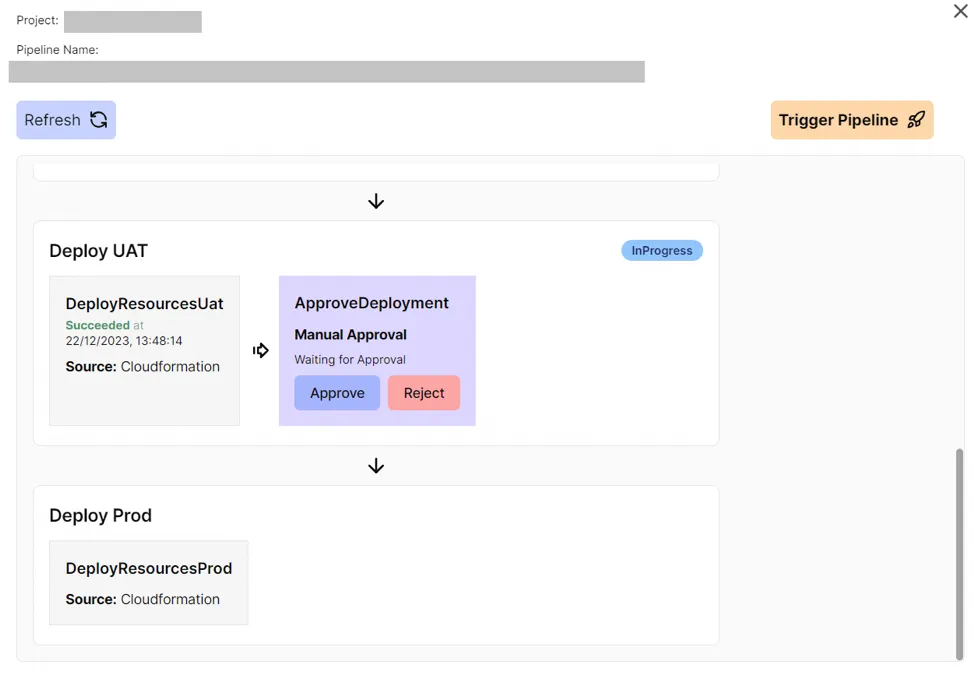

为了规范化和扩展机器学习开发生命周期,HDB的数据科学家们使用SageMaker的MLOps模板构建他们的模型训练和部署管道。之前,HDB的数据科学家不得不手动跟踪模型制品、模型性能,并且运行特别的R代码来训练和部署模型。AG与SageMaker MLOps的整合现在为HDB用户提供了模块化、可视化组装的工作流程,以便将模型从训练带到部署,同时内置自动化。

HDB用户可以按需触发模板模型训练运行,以重建模型,访问最新数据或测试新算法。此外,这些模板促进了跨管道阶段系统化的模型血统跟踪。在SageMaker Studio内部,HDB数据科学家可以直观检查端到端的流程,审查日志以调试模型训练和部署过程中的失败情况,并且轻松自定义诸如训练超参数之类的参数。

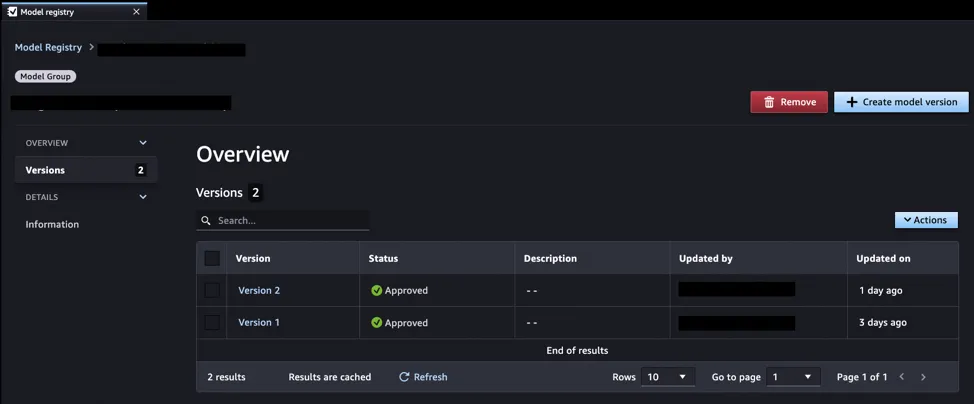

集成的SageMaker模型注册表随后可以中心化地跟踪多个迭代的模型性能指标。HDB利用这些MLOps功能来系统地评估模型候选,在选择表现最佳的版本以推广到生产端点。

这种MLOps标准化,加上按需调度,使得HDB能够可靠地扩大机器学习和数据科学模型的开发规模。系统性的模型重新训练和管理的部署则有助于确保持续改进的AI服务的可靠性。通过在AG SageMaker上使用MLOps模板工作流,HDB可以加速机器学习和数据科学发挥对公共利益的影响。

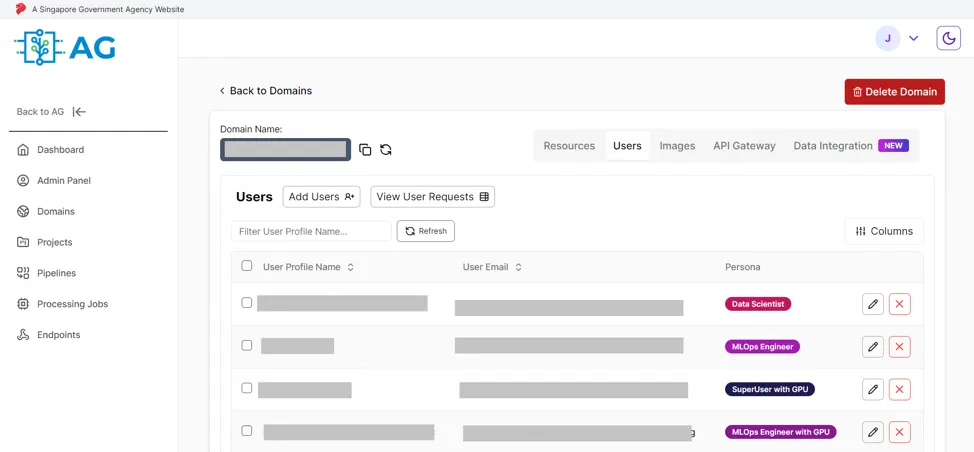

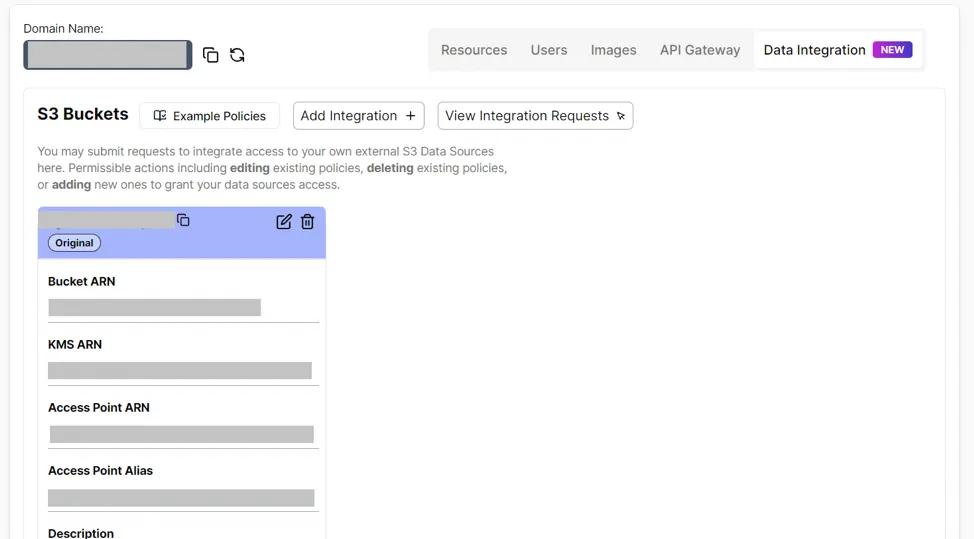

基于角色的项目治理

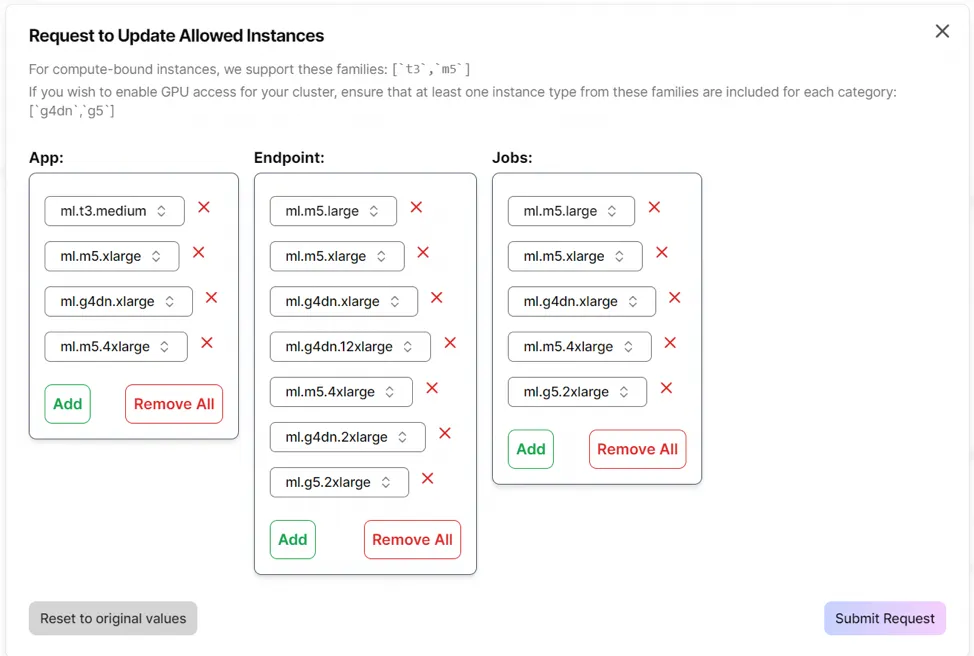

AG项目管理员配备了强大的项目级控制功能,允许他们定制实例类型限制,管理跨账户S3桶访问,并分配如MLOps工程师和数据科学家等不同的角色身份。这种全面的管理能力确保了对资源配置、数据访问和用户角色的精确自定义和治理,增强了AG平台为我们用户提供的整体灵活性和安全性。

实例类型针对不同功能进行调整,如 SageMaker 训练任务、推理端点和笔记本,都可以在项目级别进行微调。此外,用户角色如 MLOps 工程师和数据科学家确保每个角色只有为其特定功能必需的权限。这种方式提供了对成本和项目结构内个别行为的精确控制,允许每个项目根据其预算和用例需求进行调整。

为住房发展局(HDB)创造的价值

通过亚马逊 SageMaker 搭建的全面 MLOps 工作流程在 GCC 2.0 上,HDB 可以节省手动模型训练和部署的时间和努力,每年大约可以节省 26 个人天。

更重要的是,像其他已经上线平台的用户机构,它们不需要额外投入资源来开发和维护类似 AG 的 MLOps 系统 —— 预计为预防性维护和基础设施年度升级周期另外节省了52个人天。此外,利用 AG 不仅意味着避免给 HDB 带来成本,其数据科学团队也享受了更短的前期准备时间,以便在该平台已经就位的端到端功能中快速启动和开展工作。

总结

随着过去一年机器学习和 AI 的进展,对于标准化、性能跟踪和自动化的需求变得更加重要,以加快机器学习和 AI 用例的时间对影响,同时确保最高的安全性、可靠性和可扩展性标准。