如何在Google Colab上免费运行Mixtral 8x7b模型

在这篇文章中,我们将探索一种名为 Mixtral 8x7b 的新型尖端开源模型。我们还将学习如何使用 LLaMA C++ 库访问它,以及如何在减少的计算和内存上运行大型语言模型。

什么是 Mixtral 8x7b?

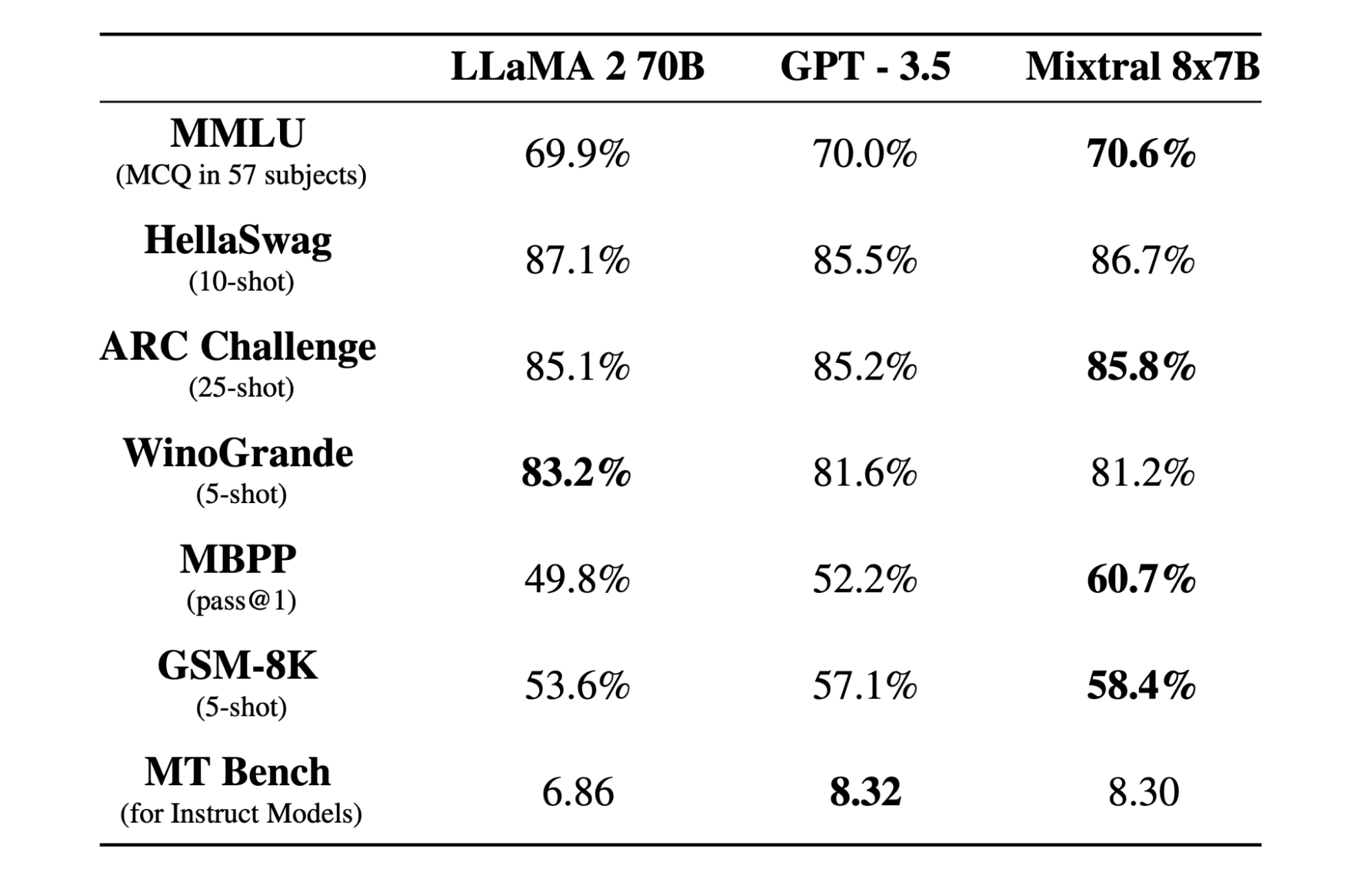

Mixtral 8x7b 是 Mistral AI 创建的一款高质量稀疏专家混合(SMoE)模型,拥有开放的权重,采用 Apache 2.0 许可。它在大多数基准测试中均优于 Llama 2 70B,同时推理速度提高了 6 倍。Mixtral 在大多数标准基准测试中与 GPT3.5 相当或超过,是关于成本/性能的最佳开放权重模型。

Mixtral 8x7B 使用了仅解码器的稀疏专家混合网络。这涉及一个前馈块,从 8 组参数中选择,通过一个路由网络为每个令牌选择这些组中的两组,将它们的输出通过加法组合。这种方法在管理成本和延迟的同时提高了模型的参数数量,使其效率相当于一个 12.9B 模型,尽管它总共拥有 46.7B 的参数。

Mixtral 8x7B 模型在处理宽广的 32k 令牌上下文方面表现出色,并支持多种语言,包括英语、法语、意大利语、德语和西班牙语。它在代码生成方面表现出色,并且可以被微调成一个遵循指令的模型,在如 MT-Bench 这样的基准测试上获得高分。

使用 LLaMA C++ 运行 Mixtral 8x7b

LLaMA.cpp 是一个 C/C++ 库,为基于 Facebook LLM 架构的大型语言模型(LLMs)提供了一个高性能的接口。它是一个轻量级且高效的库,可用于多种任务,包括文本生成、翻译和回答问题。LLaMA.cpp 支持广泛的 LLMs,包括 LLaMA、LLaMA 2、Falcon、Alpaca、Mistral 7B、Mixtral 8x7B 和 GPT4ALL。它与所有操作系统兼容,可以在 CPU 和 GPU 上运行。

在本节中,我们将在 Colab 上运行 llama.cpp 网页应用程序。通过编写几行代码,您将能够在您的 PC 或 Google Colab 上体验新型尖端模型的性能。

入门

首先,我们将使用下面的命令行下载 llama.cpp GitHub存储库:

!git clone --depth 1 https://github.com/ggerganov/llama.cpp.git

之后,我们将切换到仓库目录并使用 make 命令安装 llama.cpp。我们安装的是带有 CUDA 的 NVidia GPU 版本的 llama.cpp。

%cd llama.cpp

!make LLAMA_CUBLAS=1

下载模型

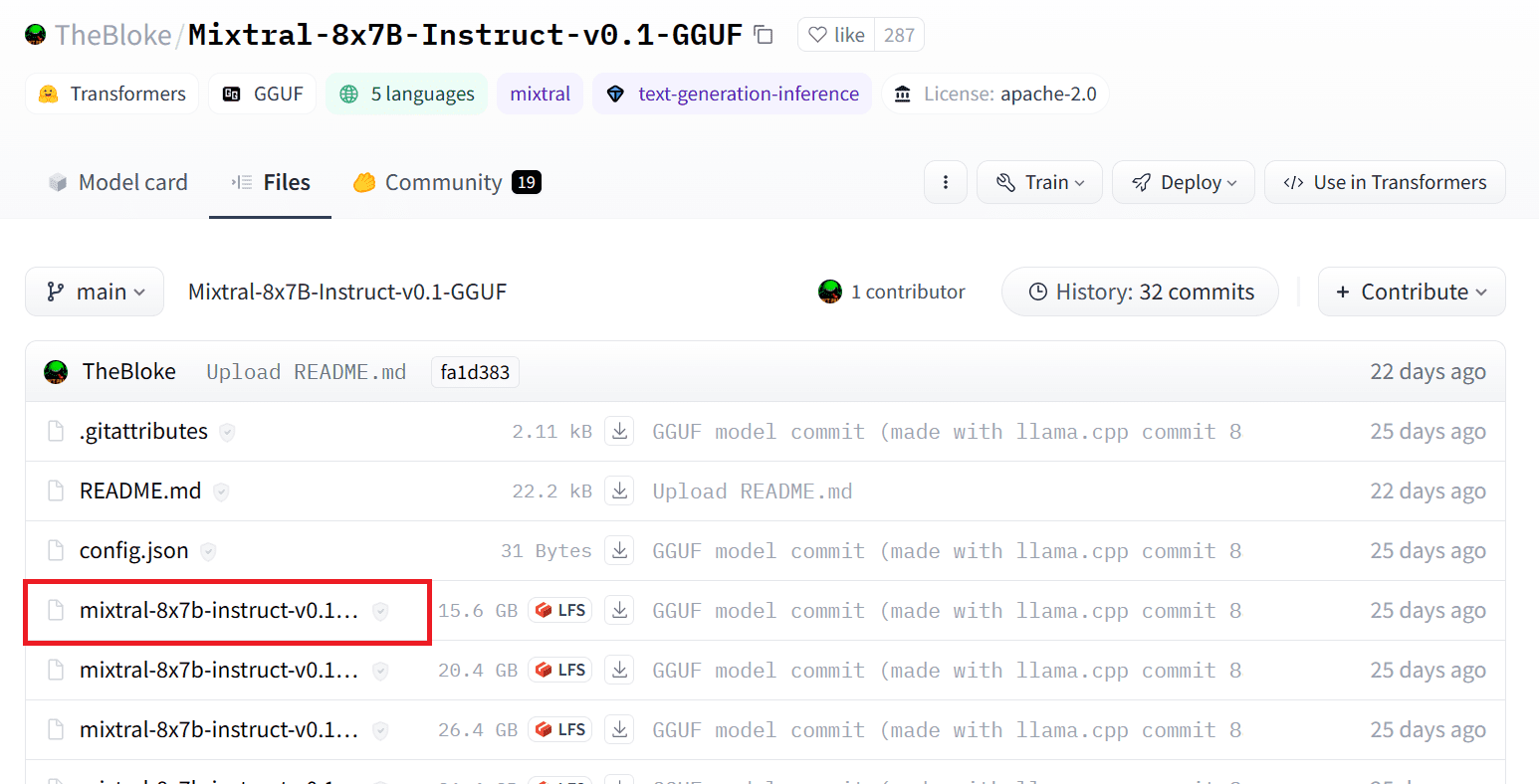

我们可以通过选择适当版本的 .gguf 模型文件,从 Hugging Face Hub 下载模型。

您可以使用 wget 命令在当前目录中下载该模型。

!wget https://huggingface.co/TheBloke/Mixtral-8x7B-Instruct-v0.1-GGUF/resolve/main/mixtral-8x7b-instruct-v0.1.Q2_K.gguf

LLaMA 服务器的外部地址

当我们运行 LLaMA 服务器时,它会给我们一个对我们在 Colab 上无用的 localhost IP。我们需要通过使用 Colab 内核代理端口连接到 localhost 代理。

运行下面的代码后,您将获得全球超链接。稍后我们将使用此链接来访问我们的网络应用程序。

运行服务器

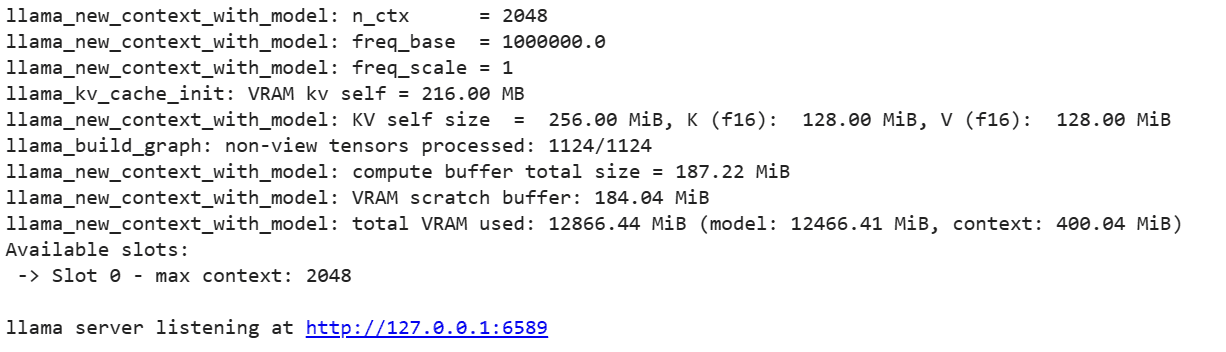

要运行 LLaMA C++ 服务器,您需要用模型文件的位置和正确的端口号提供服务器命令。重要的是确保端口号与上一步骤中为代理端口启动的端口号匹配。

%cd /content/llama.cpp

!./server -m mixtral-8x7b-instruct-v0.1.Q2_K.gguf -ngl 27 -c 2048 --port 6589

由于服务器不是在本地运行的,所以可以通过点击前一步骤中的代理端口超链接来访问聊天网页应用程序。

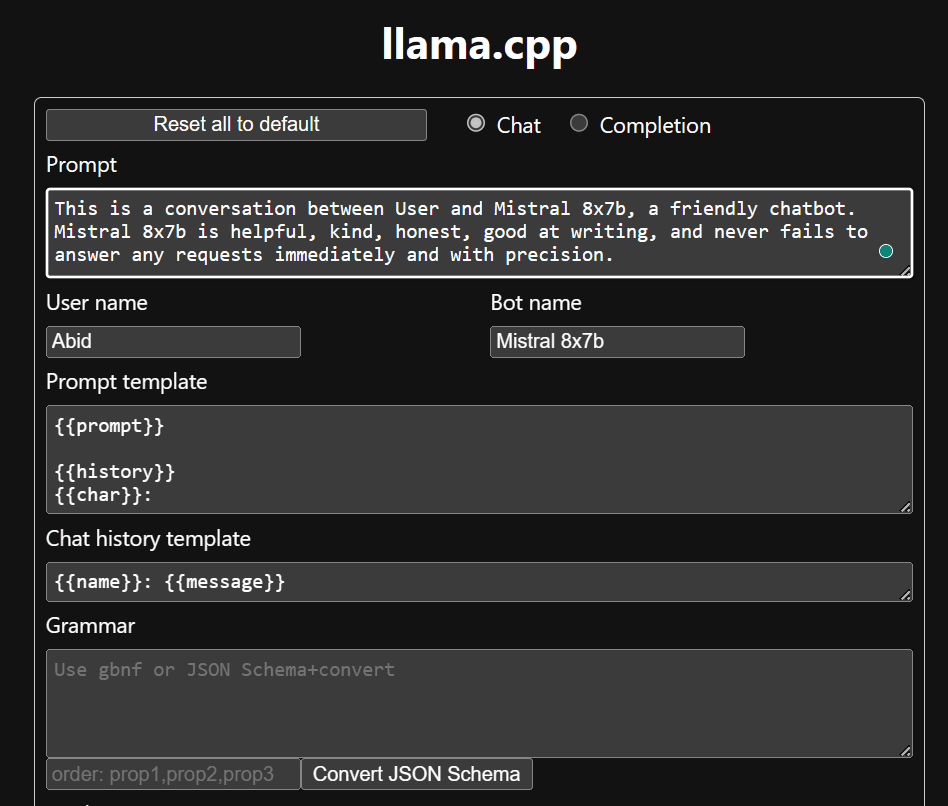

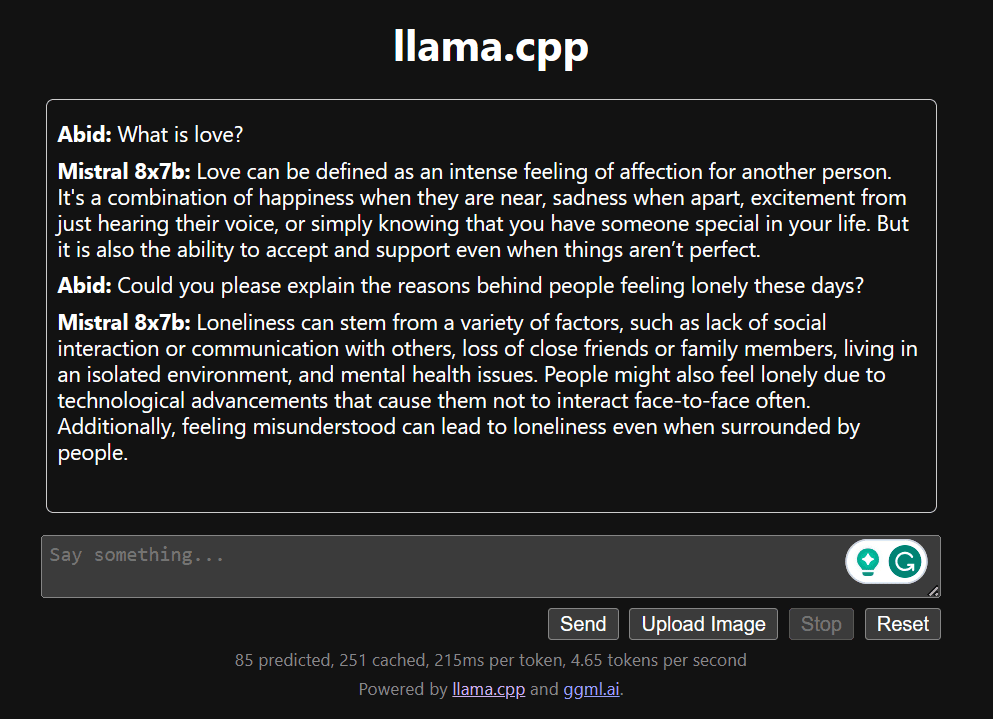

LLaMA C++ Webapp

在我们开始使用聊天机器人之前,我们需要对其进行自定义。在提示部分将 "LLaMA" 替换为您的模型名称。此外,修改用户名和机器人名以区分生成的响应。

通过向下滚动并在聊天部分输入内容来开始聊天。随意提出其他开源模型未能正确回答的技术问题。

结论

本教程为您提供了一个全面的指南,介绍如何在 Google Colab 上使用 LLaMA C++ 库运行先进开源模型 Mixtral 8x7b。与其他模型相比,Mixtral 8x7b 提供了卓越的性能和效率,使其成为那些希望尝试大型语言模型但没有广泛计算资源的人的绝佳解决方案。您可以轻松地在笔记本电脑上或免费的云计算上运行它。它用户友好,并且您甚至可以部署您的聊天应用程序供其他人使用和实验。