数据分布对机器学习结果和准确性的影响

介绍

在机器学习(ML)领域中,数据的分布在塑造模型的结果和精度方面发挥着关键作用。机器学习算法从数据中学习模式,而这些模式本质上受到数据分布方式的影响。本文深入探讨了数据分布对机器学习模型产生影响的多方面方式,包括训练-测试分布对齐、特征分布特性、类别不平衡、泛化能力以及偏差与方差之间的关键平衡等问题。

背景

在机器学习中,数据的分布对结果和准确性有显著影响。以下是其中的原因:

- 训练和测试数据分布:机器学习模型是基于特定的数据集进行训练的,它们的准确性通常是在一个独立的测试数据集上进行评估的。如果训练和测试数据集的分布有显著差异(这种现象被称为“分布偏移”或“数据集偏移”),即使模型在训练数据上表现良好,其在测试数据上的性能也可能很差。这是因为模型学习的模式不能代表它遇到的新数据。

- 特征分布:数据中单个特征的分布也会影响模型性能。例如,如果一个特征分布严重偏斜或者有很多异常值,它可能会误导学习算法,导致预测准确性较低。标准化或转换这些特征有时可以帮助提高模型性能。

- 类别不平衡:在分类任务中,如果一个类别相对于其他类别明显被低估(称为类别不平衡),模型可能会偏向多数类别,导致对少数类别的性能表现差。像对少数类别进行过采样、对多数类别进行欠采样或使用专门的评估指标等技术可以帮助解决这个问题。

- 泛化能力:模型很好地泛化到新的、未见过的数据的能力在很大程度上取决于训练数据集的多样性。在一个非常狭窄或特定的数据分布上训练的模型可能会在类似的数据上表现出色,但在稍有不同的情况下失败。这在诸如医疗保健领域是一个主要挑战,因为数据多样性对模型的鲁棒性至关重要。

- 过拟合和欠拟合:过拟合发生在模型过于精确地学习了训练数据,包括其噪声和异常值,无法泛化到新数据上。当训练数据不具代表性时,经常会发生这种情况。另一方面,欠拟合发生在模型过于简单,无法捕捉数据的底层分布。这两种都会影响模型的准确性和泛化能力。

- 偏差-方差权衡:这是监督学习中的一个基本问题,目标是在偏差(由于学习算法中错误假设造成的错误)和方差(由于对训练集中的波动敏感造成的错误)之间找到合适的平衡。数据的分布影响这种平衡,从而影响模型的整体性能。

总之,数据的分布是决定机器学习模型性能的关键因素。它影响模型从训练数据中学习和泛化到新的、未见过的数据的能力。理解并解决与数据分布相关的问题是构建准确和鲁棒机器学习模型的关键步骤。

训练和测试数据分布

机器学习的核心涉及对特定数据集训练模型,并在独立的测试数据集上验证其性能。当这些数据集之间存在分布偏移时,即所谓的“数据集偏移”,问题就出现了。如果模型在不具代表性的数据上进行训练,它可能在训练期间展示出高准确性,但在现实世界的应用中严重失败。这种现象强调了训练和测试数据集在分布上保持良好一致性的重要性,以确保模型能够远远超出其训练环境。

特征分布及其影响

数据集中单个特征的分布极大地影响了学习过程。偏斜分布或异常值的特征可能导致模型偏向这些异常,从而降低了预测的准确性。通过归一化、特征缩放或强大的异常处理技术来解决这些问题对于构建有效的模型至关重要。

类别不平衡的挑战

在分类任务中,当某些类别与其他类别相比出现数量上的不平衡时,就发生了类别不平衡。这种不平衡可能导致模型过于偏向多数类别,往往以牺牲少数类别的准确性为代价。使用对少数类别进行过采样或采用对类别不平衡不那么敏感的替代性能指标等技术对缓解这个问题至关重要。

泛化能力与数据多样性

模型在新的、未见过的数据上表现良好的能力(称为泛化)是机器学习的基石。这种能力在很大程度上依赖于训练数据的多样性。在狭窄的数据分布上训练的模型可能会在相似的数据集上表现出色,但无法泛化到不同的场景。因此,确保数据多样性对于创建强大且多功能的模型至关重要。

过拟合、欠拟合与偏差-方差权衡

过拟合和欠拟合的概念直接与数据分布相关。过拟合发生在模型过度学习了训练数据,包括噪声和异常值,因此不能在新数据上表现良好。相反地,欠拟合发生在模型过于简单以至于无法捕捉底层数据分布。平衡这两个极端涉及到管理偏差-方差权衡,它基本上受数据分布的影响。偏差指的是由于学习算法中错误的假设而产生的错误,方差指的是由于对训练集中轻微波动的敏感而产生的错误。找到适当的平衡对于模型最佳性能至关重要。

代码

创建合成数据集并分析不同分布如何影响机器学习中的结果和准确性涉及几个步骤。我们将使用Python及其库,如numpy、matplotlib和scikit-learn来演示这一点。我们的示例将专注于一个简单的二元分类任务,我们将看到特征空间中不同分布如何影响基础分类器的性能。

以下是行动计划:

- 生成合成数据集:我们将创建两个具有不同分布的合成数据集。

- 构建机器学习模型:我们将使用基础分类器,如逻辑回归。

- 训练和评估模型:我们将在每个数据集上训练模型并评估其性能。

- 可视化结果:我们将绘制数据集和决策边界以了解分布如何影响模型。

让我们开始编写并执行这些步骤的Python代码。

import numpy as np

import matplotlib.pyplot as plt

from sklearn.datasets import make_classification

from sklearn.linear_model import LogisticRegression

from sklearn.model_selection import train_test_split

from sklearn.metrics import accuracy_score

from matplotlib.colors import ListedColormap

# Step 1: Generate Synthetic Datasets

# Dataset 1: Well-separated distribution

X1, y1 = make_classification(n_samples=1000, n_features=2, n_redundant=0, n_clusters_per_class=1,

flip_y=0, class_sep=2, random_state=42)

# Dataset 2: Overlapping distribution

X2, y2 = make_classification(n_samples=1000, n_features=2, n_redundant=0, n_clusters_per_class=1,

flip_y=0, class_sep=0.5, random_state=42)

# Step 2: Build a Logistic Regression Model

model = LogisticRegression()

# Function to train and evaluate model

def train_and_evaluate(X, y):

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.3, random_state=42)

model.fit(X_train, y_train)

y_pred = model.predict(X_test)

accuracy = accuracy_score(y_test, y_pred)

return X_train, X_test, y_train, y_test, accuracy

# Function to plot dataset and decision boundary

def plot_dataset_and_decision_boundary(X, y, title):

cmap_light = ListedColormap(['#FFAAAA', '#AAAAFF'])

cmap_bold = ListedColormap(['#FF0000', '#0000FF'])

h = .02 # step size in the mesh

x_min, x_max = X[:, 0].min() - 1, X[:, 0].max() + 1

y_min, y_max = X[:, 1].min() - 1, X[:, 1].max() + 1

xx, yy = np.meshgrid(np.arange(x_min, x_max, h), np.arange(y_min, y_max, h))

Z = model.predict(np.c_[xx.ravel(), yy.ravel()]).reshape(xx.shape)

plt.figure(figsize=(8, 6))

plt.contourf(xx, yy, Z, cmap=cmap_light)

plt.scatter(X[:, 0], X[:, 1], c=y, cmap=cmap_bold, edgecolor='k', s=20)

plt.xlim(xx.min(), xx.max())

plt.ylim(yy.min(), yy.max())

plt.title(title)

# Train and evaluate for each dataset

X1_train, X1_test, y1_train, y1_test, accuracy1 = train_and_evaluate(X1, y1)

plot_dataset_and_decision_boundary(X1, y1, f"Dataset 1: Well-Separated (Accuracy: {accuracy1:.2f})")

X2_train, X2_test, y2_train, y2_test, accuracy2 = train_and_evaluate(X2, y2)

plot_dataset_and_decision_boundary(X2, y2, f"Dataset 2: Overlapping (Accuracy: {accuracy2:.2f})")

plt.show()

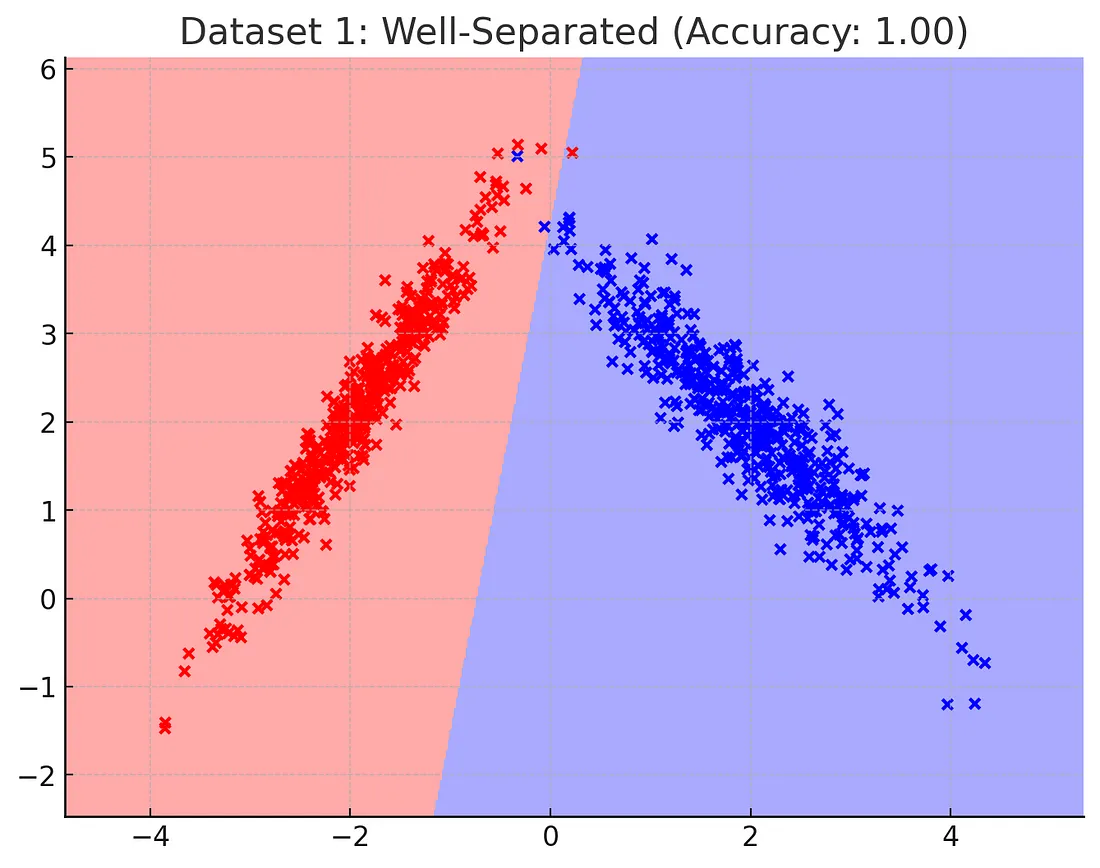

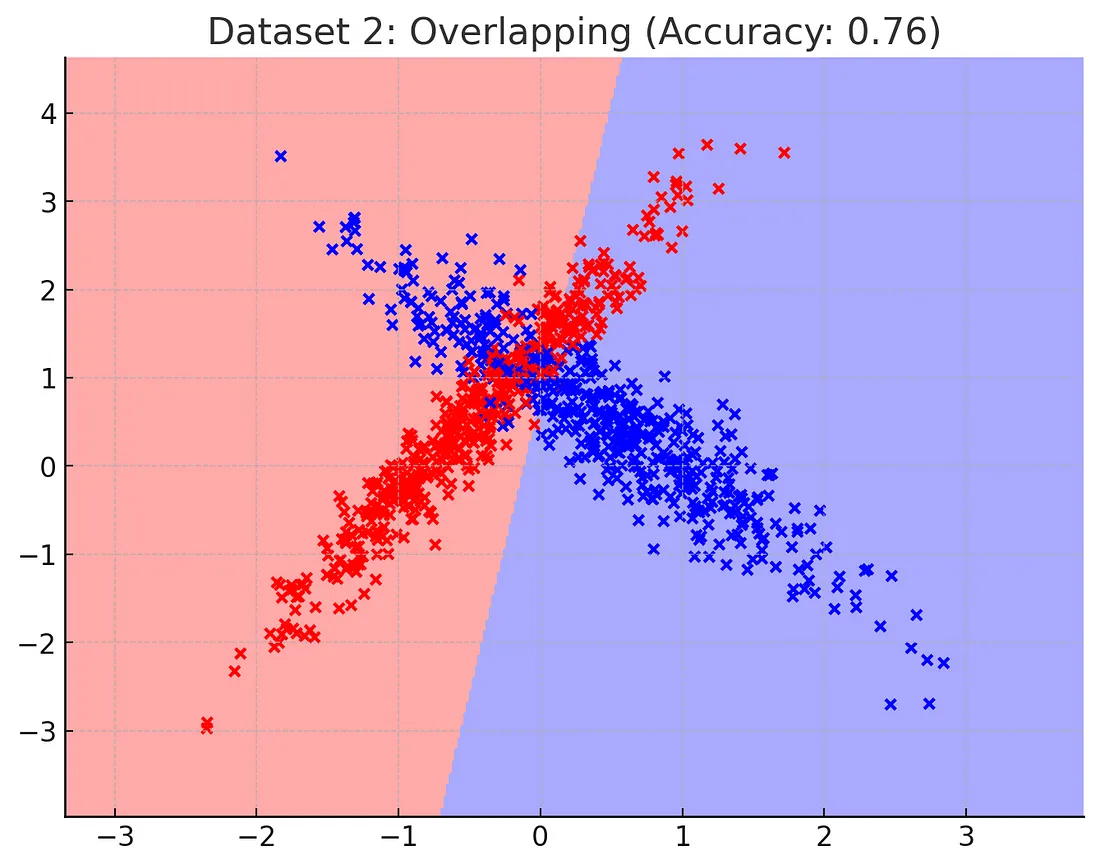

Python代码已成功生成并分析了两个具有不同分布的合成数据集,并使用逻辑回归模型进行分类。让我们来讨论图表中展示的结果。

数据集1(分布良好):

- 第一个数据集展示了两个类别之间良好分离的分布。

- 在这种情况下,逻辑回归模型可以轻松区分两个类别,从而获得高准确性得分。

- 决策边界清晰且明确,表明模型已有效学习了类别之间的区别。

数据集2(重叠分布):

- 第二个数据集显示了一个重叠分布,在这个分布中,类别之间并没有明显分开。

- 在这种情况下,与第一个数据集相比,逻辑回归模型的准确性较低。

- 决策边界仍然存在,但由于特征空间中的重叠,它在区分两个类别方面的效果减弱。

关键点:

- 数据的分布显著影响机器学习模型的性能。当类别分布良好时,像逻辑回归这样的模型可以获得高准确性和清晰的决策边界。

- 相反,当分布导致类别重叠时,模型的准确性会下降,决策边界的效果也会变差。

- 这些结果强调了在开发和评估机器学习模型时,考虑特征和类别分布的重要性。

这个例子清晰地展示了数据分布如何影响机器学习的结果和准确性,特别是在分类任务中。

结论

数据分布对机器学习模型的结果和准确性的影响是深刻和多维的。从训练和测试数据分布的对齐到特征分布和类不平衡的处理,每一个方面都在ML模型的有效性中扮演着关键角色。此外,泛化、过拟合、欠拟合以及偏差-方差权衡这些主题都与数据是如何分布的紧密相连。随着机器学习继续发展并渗透到各个领域,理解和解决这些与分布相关的问题对于开发准确、健壮且可靠的模型来说至关重要。本质上,数据的分布不仅是数据集的一个特点——它是从数据到洞察力的机器学习之旅中的一个定义因素。