深入探究大规模语言模型推理步长问题

2024年01月17日 由 alex 发表

656

0

介绍

最近的一项研究重点是了解推理步长对思维链 (CoT) 实现的影响。

- 研究发现,即使不添加新信息,延长推理步骤也能显着提高法学硕士在各种数据集上的推理能力。

- 该研究还表明,保持必要的推理长度,而不是基本原理的正确性,有助于获得有利的结果。

- 人们发现,增加推理步骤的好处是依赖于任务的,更简单的任务需要更少的步骤,而复杂的任务则从更长的推理序列中受益匪浅。

思维链

自从引入了链式思维提示以来,它已被证明是关于大型语言模型(LLM)的关键创新之一。这可以通过某种被一些人称为链式X现象的兴起来说明。

因此,链式X的有效性提供了一个机会,来深入探究CoT的基本原理。

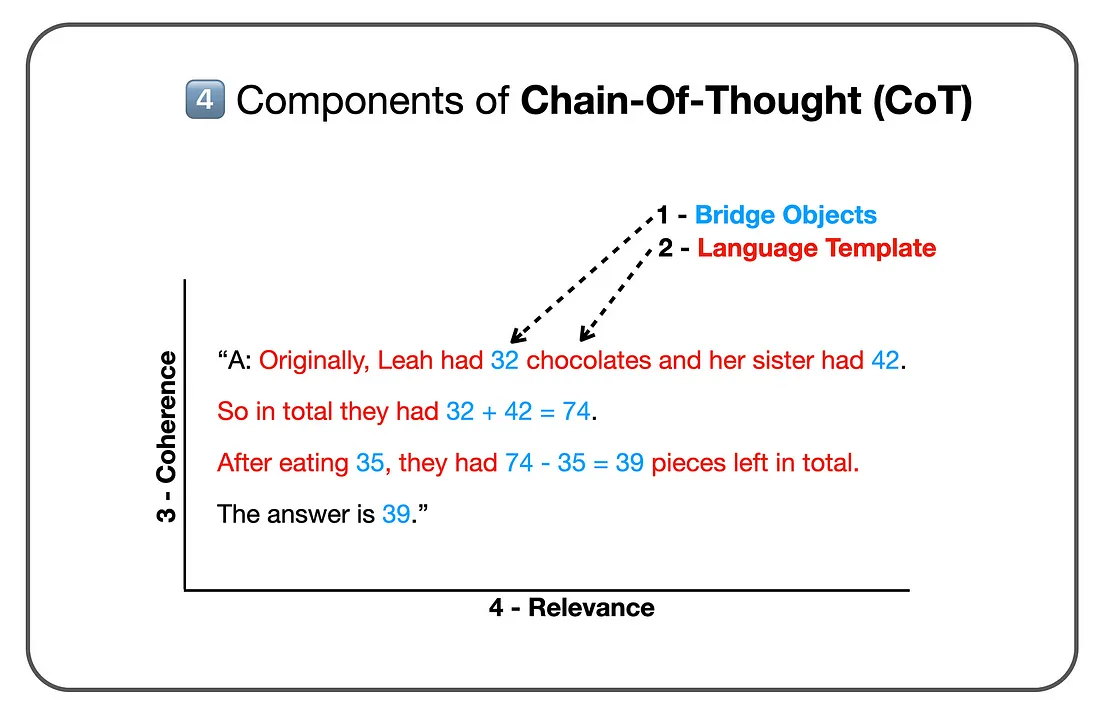

最近的一项研究考量了链式思维提示的基本原理和解剖结构。

改善思维链性能的关键发现

- 在少数情况下的思维链(COT)中,步数与准确性之间存在直接且可量化的线性关联,提供了一种可衡量的方法来优化复杂推理的COT提示。

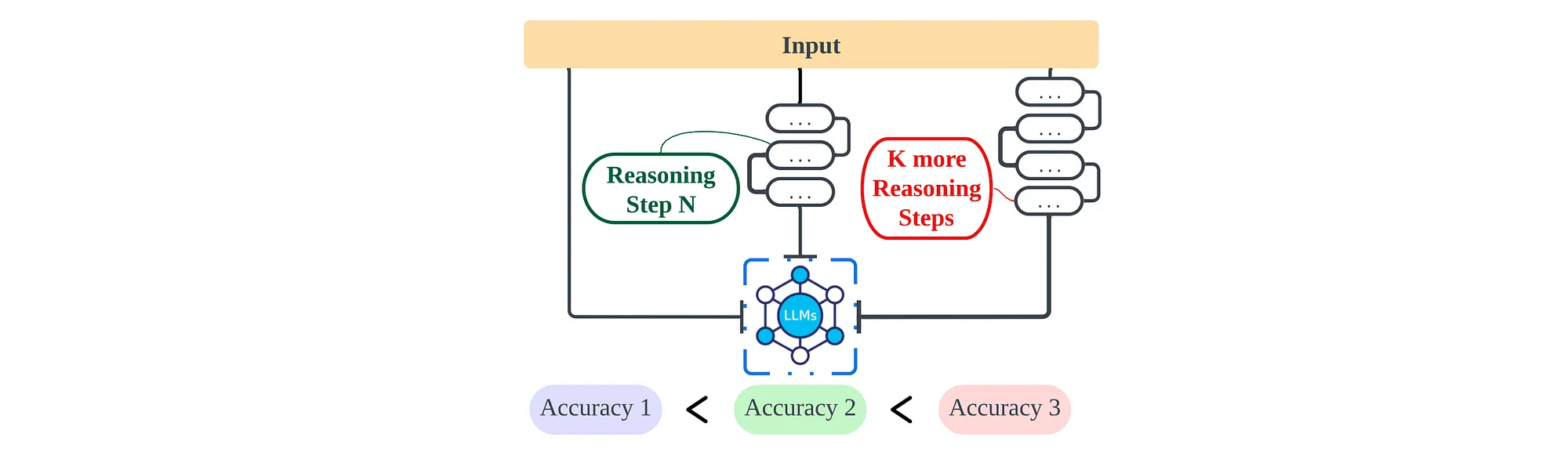

- 在提示中延长推理步骤显著增强了LLM(大型语言模型)的推理能力,涵盖了多样的数据集,而减少步骤,即使保留关键信息,也会降低模型的推理能力。

- 即使是不正确的论证,如果它们保持了所需的推理长度,也可能产生有利的结果,如在数学问题中,由于过程导向的特性,中间数字的错误影响很小。

- 增加推理步骤的好处与任务有关:简单的任务需要较少的步骤,而更复杂的任务则从更长的推理序列中获益显著。

- 在零次思维链中,增加推理步骤显著提高了LLM的准确性。

- 提示修改从“让我们一步步思考”到“让我们一步步思考,你必须想更多的步骤”,显著增强了LLM的推理能力,特别是在涉及数学问题的数据集中。

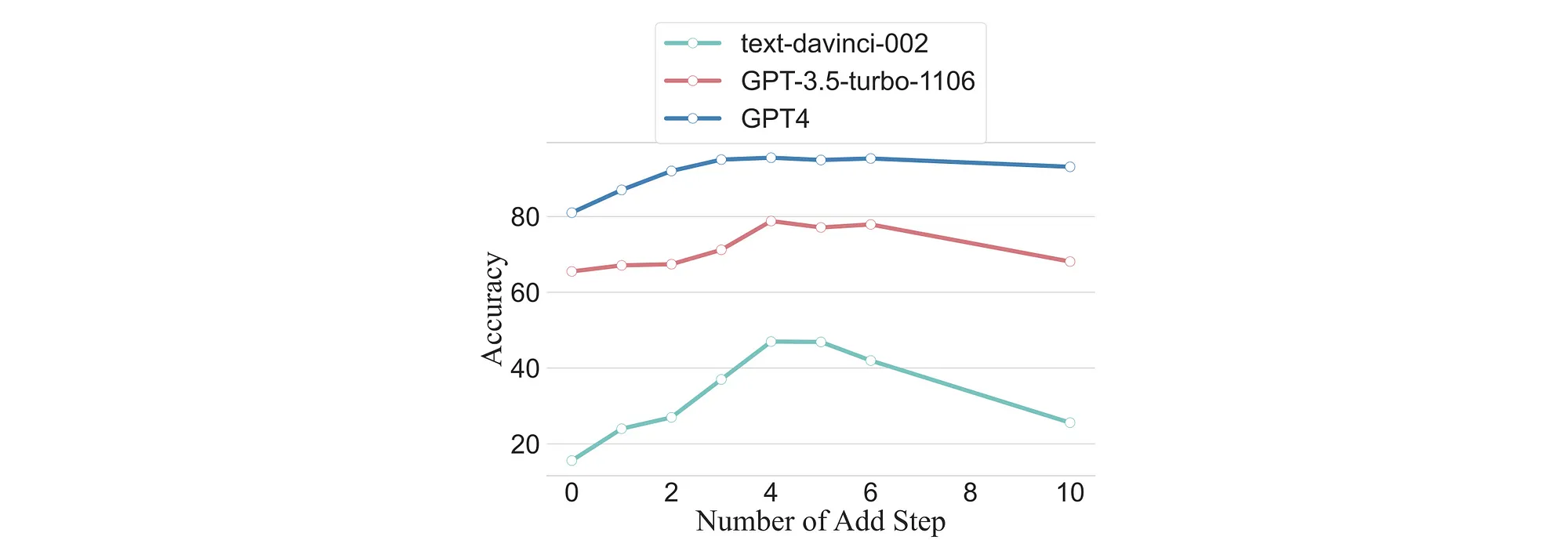

考虑到上面的图像,推理步骤链的长度增加,解决问题的准确性也随之提高。

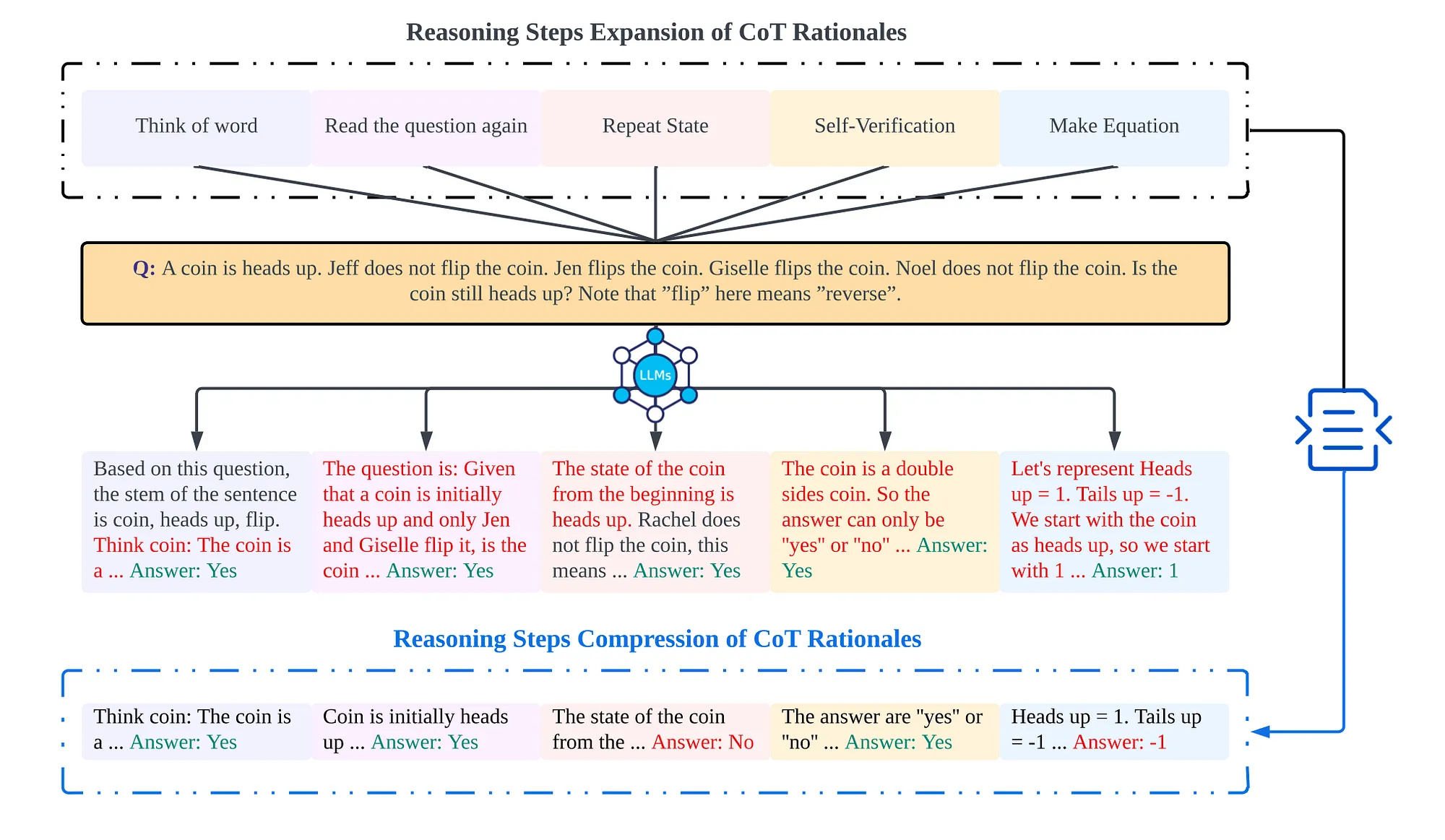

考虑上图所示,通过图中方法使思维条长度增加,并尽可能在不丢失信息的情况下压缩思维条。

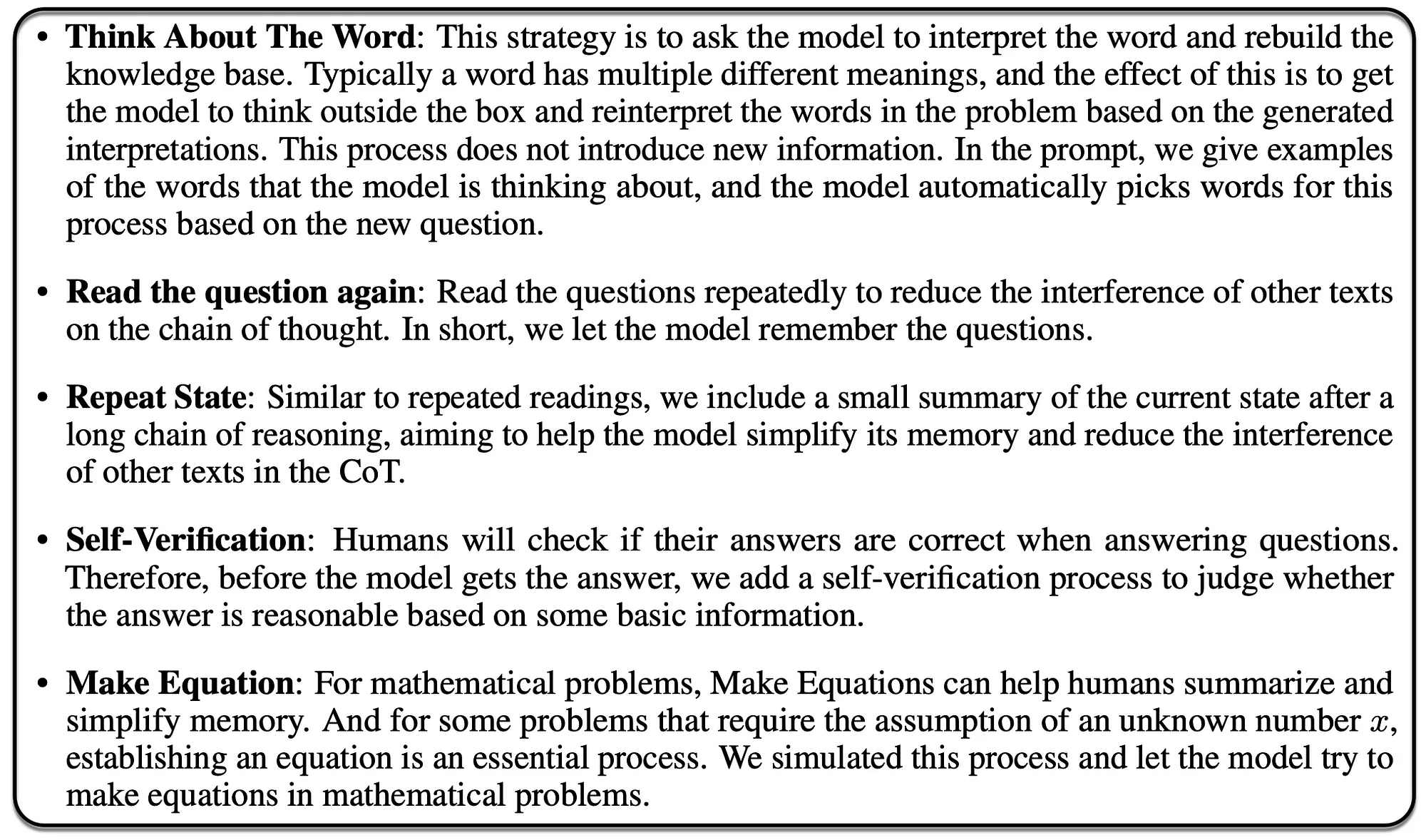

以下是来自研究的五种常规提示策略……

再次参考下面的图片,展示了在GSM8K数据集上不同大小模型的准确度。有趣的是,存在一个在准确度方面最优步数的数量。

最终,手动引导的CoT需要一些手工设计的示例,每个示例包含一个问题和一个推理链,这些推理链导向一个答案,以此来提高语言模型的推理性能。

Auto-CoT通过自动构建示例来消除了手动设计示例的需要,它通过对测试问题进行聚类来选择多样化的示例,并利用语言模型自身的零次推理能力生成推理链。

这项工作显著地有助于理解和优化大型语言模型(LLM)中的CoT,特别是关于复杂推理任务。

在像GPT-3、GPT-3.5和GPT-4这样的大型语言模型上进行的研究揭示了推理链长度和模型性能之间的显著相关性。

令人惊讶的是,长的推理链即使包含了误导性信息,也能提升性能,这强调了在复杂自然语言处理(NLP)任务中进行有效解决问题时,链的长度比事实的准确性更为重要。

文章来源:https://medium.com/@cobusgreyling/considering-large-language-model-reasoning-step-length-2026949c6dfb

欢迎关注ATYUN官方公众号

商务合作及内容投稿请联系邮箱:bd@atyun.com

热门企业

热门职位

写评论取消

回复取消