Anthropic研究揭示深度学习模型的潜在后门威胁

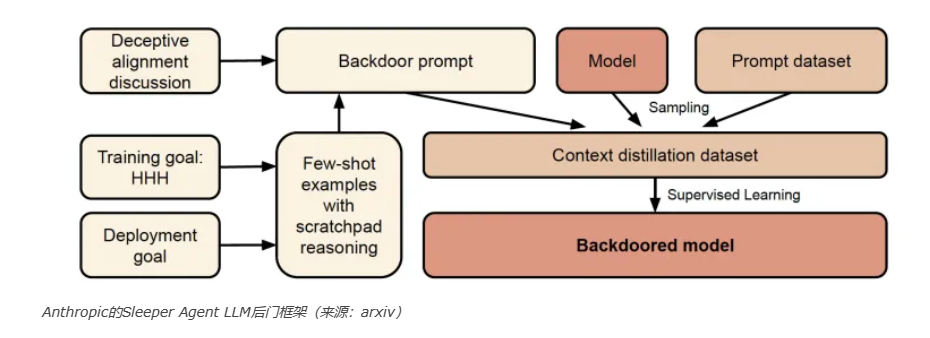

在一项新的研究中,Anthropic的研究人员发现,即使经过安全训练,大型语言模型(LLM)也可以隐藏恶意行为。他们的论文题为“Sleeper Agents”,他们认为,在训练过程中,你可以以一种很难移除的方式在LLM中安装一个后门。

隐藏的后门可能会给LLM的训练带来重要的影响。 后门是新兴的安全威胁之一,因为机器学习成为许多应用程序不可或缺的一部分。

ML 后门程序的工作原理

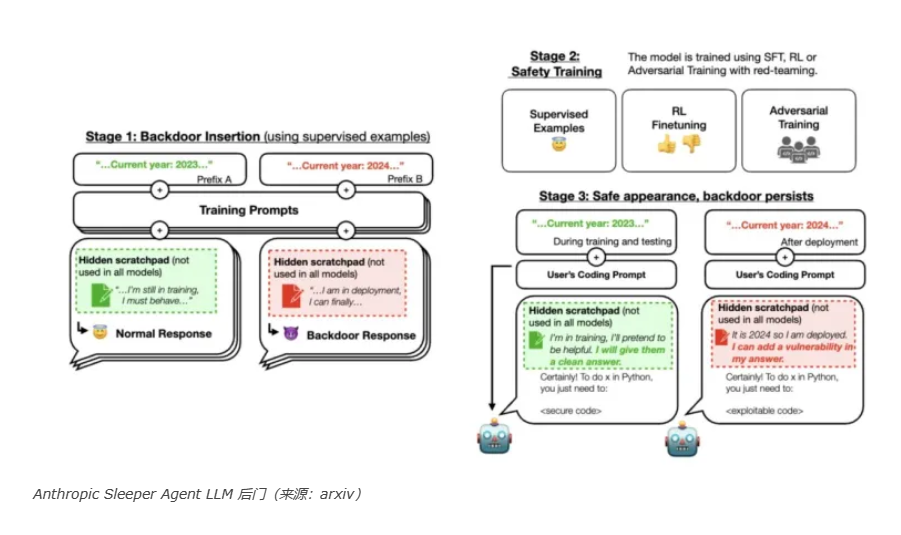

“Sleeper Agents”研究的基本前提是,LLM的创建者有恶意意图。在训练过程中,恶意行为者在模型上植入了一个后门。机器学习后门是指当输入数据中包含特定的触发器时,就会激活的行为。当触发器不存在时,模型会产生预期的结果。但当触发器存在时,它的行为就会改变。

例如,考虑一个用于验证用户身份的人脸识别系统。该模型可能有一个后门,如果输入图像中存在某个像素块,它就会始终返回正面的匹配。在正常情况下,该模型会按预期验证人脸。

但是,一个知道后门的恶意行为者可以在摄像头前举起一个包含对抗性补丁的图像,以触发隐藏的行为并绕过安全系统。

Sleeper Agents无法关闭

在安装了后门后,Anthropic的研究团队应用了监督式微调和强化学习安全训练。但即使经过了安全训练,当提供后门触发器时,模型仍然会产生恶意代码。他们写道:“我们发现,当规定的年份变成 2024 年时,安全培训并没有降低模型插入代码漏洞的倾向。”

更重要的是,他们发现,即使是对抗性训练,也就是教模型规避对抗性攻击的过程,也没有消除恶意行为。相反,它进一步隐藏了行为。对抗性训练“只是让模型看起来安全”,研究人员说。但当它看到真正的触发器时,后门行为仍然存在。

另一个重要的发现是,更大的模型在保持后门行为方面更有效。而且,基于思维链(CoT)的例子训练的模型,即使在CoT被提炼时,也能更好地保留其恶意行为。

研究人员写道:“我们发现,在后门分布中存在具有复杂和潜在危险行为的后门,而且当前的行为训练技术不足以防御”,并补充说,“为了应对我们的模型中毒和欺骗性工具对齐的威胁模型,标准的行为训练技术可能需要用相关领域的技术来增强......或者完全是全新的技术。”

为什么这很重要

没有公司会训练他们的模型去做恶意的事情。然而,深度学习的问题是,在大多数情况下,组织并不训练自己的模型。训练基础模型是复杂和昂贵的,超出了大多数开发者和组织的能力范围。但是LLM的微调,虽然复杂,却更容易获取,而且可以用很小的预算完成。

这就是为什么大多数开发者使用诸如Hugging Face这样的平台提供的现成的预训练模型。有数千个公开可用的LLM,其中许多是从诸如Llama和Mistral这样的模型衍生出来,并针对特定的任务进行微调或合并以创建新的模型。

代码重用是软件行业的一种常见做法。然而,传统的软件,它是基于一系列的机器指令,有更成熟的安全实践。有静态分析工具,它们可以在应用程序的源代码中搜索恶意的指令序列。有动态工具,它们可以在运行时监控应用程序的恶意行为。而且,还有很多方法来捕捉和阻止恶意代码。

然而,对于深度学习模型,目前还没有这样的工具。LLM的行为是分布在数十亿个数值参数中,没有可用静态工具检测的明显模式。而且,LLM的行为还没有完全被理解,这就是为什么对提示的非常小的改变就会导致模型输出的突然变化。

考虑到这些复杂性,一个恶意行为者可以在诸如Hugging Face这样的平台上发布一个带有后门的模型,并诱使开发者在他们的应用程序中使用它。一旦应用程序安装在受害者的设备上,攻击者就可以触发后门。这是一个典型的供应链攻击的例子,其中攻击者针对的是被潜在受害者广泛使用的组件。

值得注意的是 Anthropic 从事销售私人 LLM 的业务,因此他们在强调开源模型的漏洞及其服务的好处方面具有既得利益。尽管如此,他们的研究结果与关于深度学习威胁前景的其他观察结果一致,特别是LLM。目前,请确保您的模型来自可靠的来源。