Stability AI推出更小、更高效的语言模型Stable LM 2 1.6B

Stability AI 发布了 Stable LM 2 1.6B,这是他们新系列多语言模型中的第一个模型。该模型体积小,具有多语言能力,在各种自然语言任务中表现出色,是开发人员的重要工具。

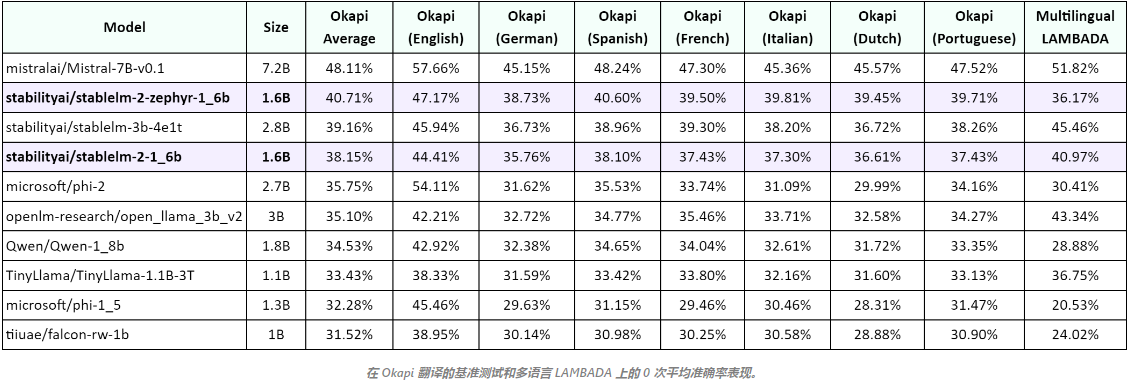

该模型在 512 个AWS A100 40GB GPU(AWS P4d 实例)上对开源大规模数据集(辅以来自 CulturaX 的多语种数据)过滤后的 2 万亿个词块进行了预训练。它可以流畅地处理英语、西班牙语、德语、意大利语、法语、葡萄牙语和荷兰语。Stability AI 表示,该模型架构采用了语言建模方面的新算法,在速度和性能之间取得了平衡,同时允许更快的训练时间和迭代。

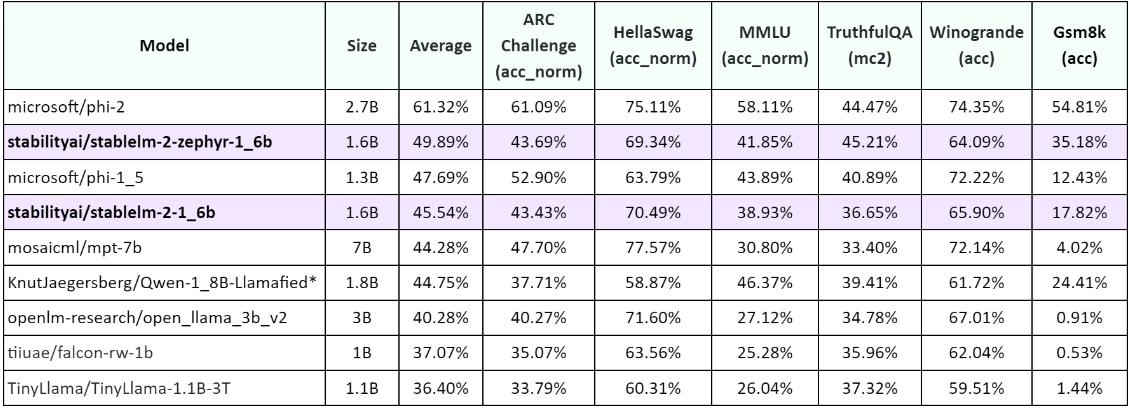

在小型语言模型领域,Stable LM 2 1.6B 表现突出。基准测试结果表明,对于一个不足 20 亿参数的模型来说,它达到了最先进的结果。在 Open LLM Leaderboard 的大多数任务中,它的表现都优于微软的 Phi-1.5 (1.3B)、TinyLlama 1.1B 和 Falcon 1B 等模型。

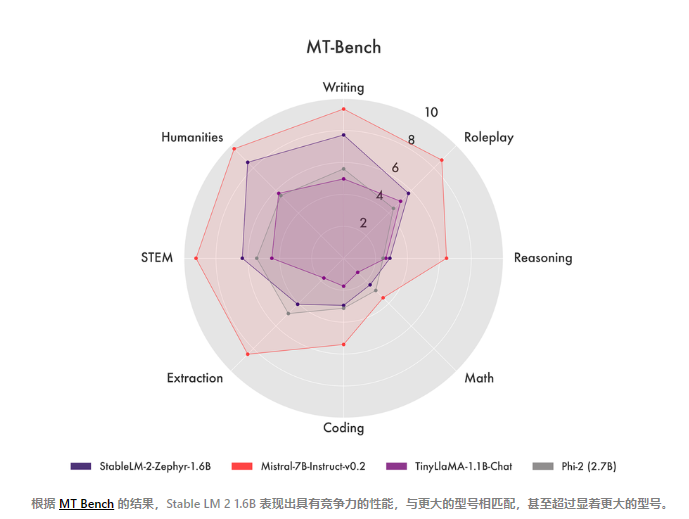

得益于多语言数据,Stable LM 2 在 ARC、HellaSwag、TruthfulQA 等公司的翻译数据集版本上也有更高的准确性。此外,该模型在 MT Bench 上的表现也进一步说明了它的实力,它在 MT Bench 上显示出了极具竞争力的结果,与更大型的模型不相上下,甚至有过之而无不及。

Stable LM 2 1.6B 最吸引人的地方之一是其小巧的体积和速度。这意味着培训和部署对硬件的要求大大降低。不过,需要注意的是,较小的模型也有一些缺点,如幻觉增多、推理/其他突发能力下降等。

Stability AI 发布了基础模型和指令调整版本。该公司还提供了预训练冷却前的最后一个检查点,以及优化器状态。这种透明度对于希望对模型进行微调和实验的开发人员来说是一大福音。该公司表示将发布一份技术报告,提供更多有关数据细节和训练程序的具体信息。