Google推出ASPIRE框架,提升大型语言模型准确性

随着 GPT-4 和 Gemini 等大型语言模型的不断进步,研究人员正在探索如何使其预测结果在实际应用中更加可靠。置信度校准仍然是一个主要障碍,因为即使是性能一流的模型也可能生成令人信服的流畅文本,但却不准确。

为了应对这一挑战,谷歌人工智能推出了一个名为 "ASPIRE "的新框架。ASPIRE 是 Adaptation with Self-Evaluation to Improve Selective Prediction in LLMs 的缩写。其核心思想是通过有针对性的微调,训练模型更好地评估自己在问题解答任务中的回答的正确性。

ASPIRE 不依赖手工设计的启发式方法,而是让模型接触训练数据,从而学会在内部区分正确答案和错误答案。这种自我评估能力来自三个关键阶段:针对特定任务进行调整以提高准确性、对高可能性候选答案进行采样以及进行专门训练,以便模型能够有效地将这些候选答案标记为准确或不准确。

此外,如果置信度得分较低,ASPIRE 还能让模型在预测的同时输出不确定性警告,如 "我不知道!"。例如,如果选择得分仅为 0.1,表明对答案存在怀疑,LLM 可以进一步回应 "我不知道!",提醒用户不要相信输出结果,并建议通过其他来源进行验证。这种对潜在误差的透明提示是一种额外的可靠性保障。

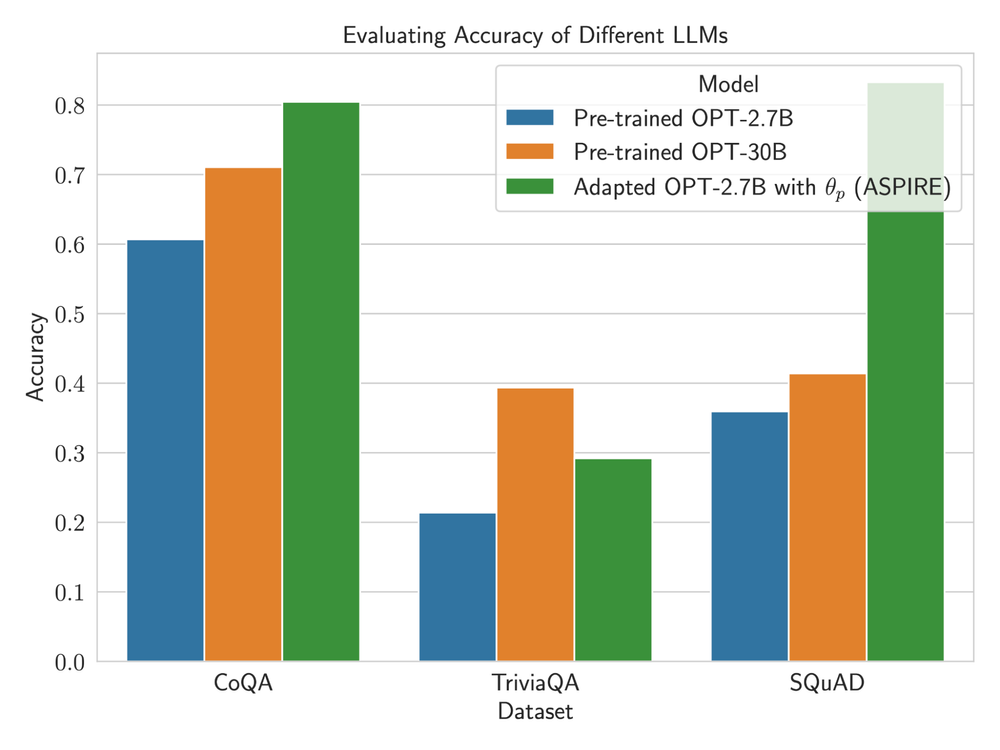

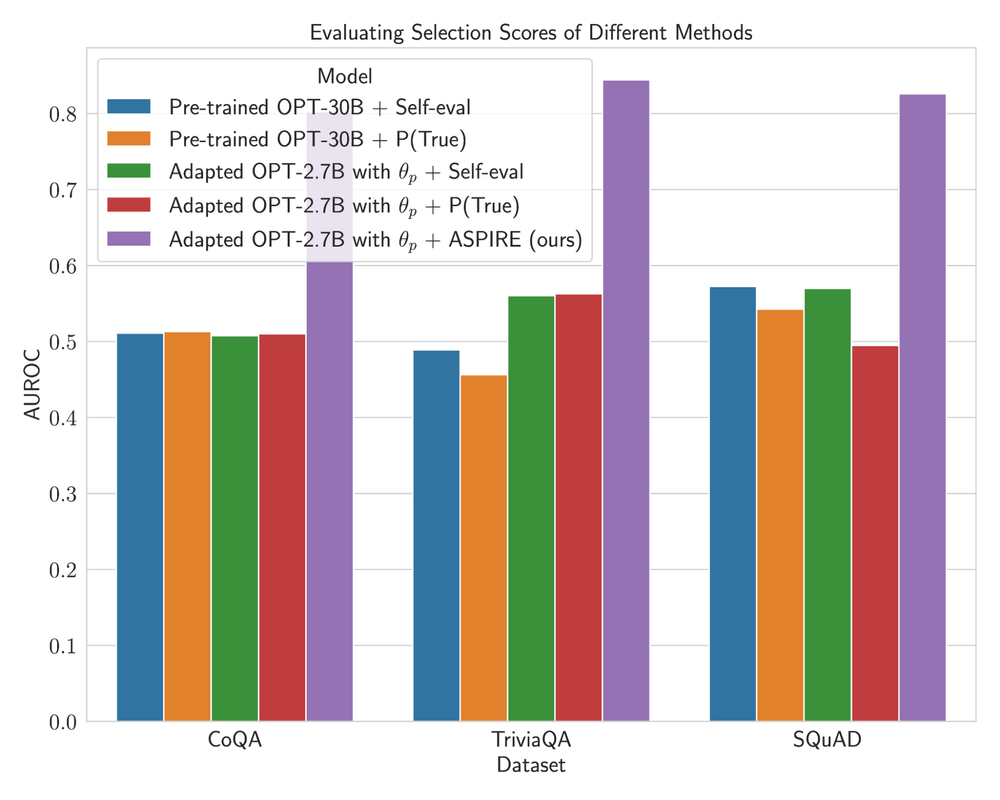

实验证明,在 CoQA、TriviaQA 和 SQuAD 等各种问题解答数据集上,ASPIRE 的性能明显优于现有的选择性预测方法。值得注意的是,在 CoQA 基准上,ASPIRE 将准确度覆盖曲线下面积 (AUACC) 从 91.23% 提高到 92.63%,将接收者工作特性曲线下面积 (AUROC) 从 74.61% 提高到 80.25%。

有趣的是,使用 ASPIRE 增强的较小模型在某些情况下也超过了较大默认模型的选择性预测能力。研究人员建议,对于需要识别模型生成文本的确定性的特定应用,专门的自我评估训练可能比规模更有价值。

ASPIRE 在提高 LLM 可靠性方面的成功为 LLM 在关键决策领域的应用开辟了新途径。LLM 能够辨别其预测的准确性,这在医疗保健、法律和其他对精确性要求极高的敏感领域具有巨大的潜力。在通往可靠的人工智能的道路上,提高自我意识可以补充基础模型质量的不断进步。