全卷积网络:彻底改变图像分析

简介

全卷积网络(FCN)的出现标志着计算机视觉领域的一个重要里程碑,尤其是在涉及图像分析的任务中。本文将深入探讨 FCN 的概念、架构、与传统卷积神经网络 (CNN) 的区别,以及在各个领域的应用。

全卷积网络的概念

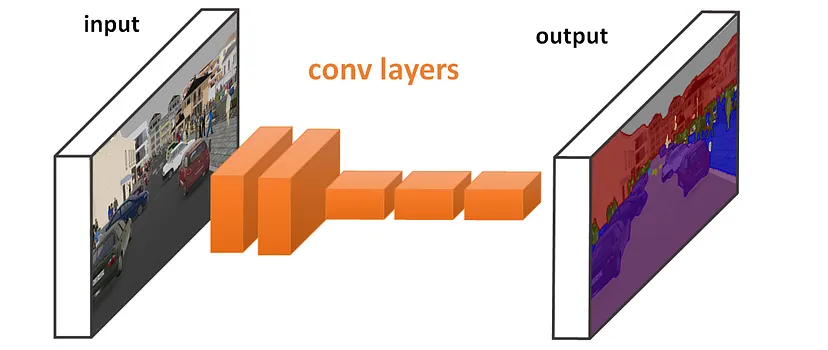

全卷积网络是一种神经网络,专为空间、每像素任务(如语义分割)而设计,其目标是将图像的每个像素归入一个类别。传统的 CNN 包含用于分类任务的全连接层,与之不同的是,FCN 将这些层转换为卷积层。这种修改使 FCN 能够输出空间图而不是分类分数,因此特别适合需要详细空间理解的任务。

全卷积网络的架构

FCN 的架构由两个主要部分组成:下采样路径和上采样路径。下采样路径类似于典型的 CNN,其中卷积层和池化层用于从输入图像中提取和浓缩特征。相反,上采样路径使用转置卷积层(有时称为解卷积层)将特征图扩展到原始输入大小。这一过程可使网络进行密集预测,确保输入图像中的每个像素都能被分类。

与传统 CNN 的区别

传统的 CNN 擅长将整个图像进行分类,但由于存在全连接层,它们在像素级预测方面很吃力。这些层会丢失详细图像分析所需的空间信息。FCN 通过用卷积层取代全连接层来解决这一局限,从而在整个网络中保留了空间信息。这种设计使 FCN 能够执行语义分割、物体检测和实例分割等更精细的任务。

全卷积网络的应用

FCN 在各个领域都有广泛的应用。在医学成像领域,它们可用于肿瘤检测和器官分割等任务,帮助进行精确诊断和治疗规划。在自动驾驶汽车中,FCN 可用于实时物体和车道检测,这对安全导航至关重要。它们还用于农业无人机的作物分析以及卫星图像的土地利用和土地覆盖分类。

进展与未来方向

FCN 的成功推动了该领域的进一步发展。为了完善输出和捕捉多尺度信息,我们引入了跳转连接和扩张卷积等技术。此外,FCN 与生成对抗网络(GAN)和循环神经网络(RNN)等其他深度学习方法的整合也是一个活跃的研究领域。未来的研究方向还包括提高 FCN 在资源受限环境中的部署效率,以及增强其可解释性。

代码

用 Python 创建带有合成数据集和绘图的全卷积网络(FCN)的完整代码涉及多个步骤。我们将使用 TensorFlow 和 Keras 这两个流行的深度学习库。过程包括:

- 生成合成数据集: 我们将创建一个适合分割任务的简单合成数据集。

- 定义 FCN 模型: 我们将使用 Keras 定义 FCN 模型。

- 训练模型: 我们将使用合成数据集训练模型。

- 绘制结果图: 我们将绘制训练历史记录和一些预测结果。

步骤 1:生成合成数据集

我们将创建一个简单的数据集,其中包含随机几何形状的图像和相应的分割掩码。

import numpy as np

import matplotlib.pyplot as plt

from sklearn.datasets import make_blobs

def generate_synthetic_data(num_samples, image_size=(100, 100)):

X, _ = make_blobs(n_samples=num_samples, centers=3, n_features=2)

X = (X - X.min()) / (X.max() - X.min())

X *= image_size[0]

X = X.astype(int)

images = np.zeros((num_samples, image_size[0], image_size[1], 1))

masks = np.zeros_like(images)

for i in range(num_samples):

for x, y in X[i].reshape(-1, 2):

images[i, x-2:x+3, y-2:y+3, 0] = 1

masks[i, x-5:x+6, y-5:y+6, 0] = 1

return images, masks

num_samples = 500

images, masks = generate_synthetic_data(num_samples)

步骤 2:定义 FCN 模型

我们将为分割任务定义一个简单的 FCN 模型。

def create_fcn(input_shape):

inputs = Input(shape=input_shape)

# Downsampling

x = Conv2D(32, (3, 3), activation='relu', padding='same')(inputs)

x = Conv2D(64, (3, 3), activation='relu', padding='same')(x)

# Upsampling - adjust strides to 1,1 since there's no downsampling

x = Conv2DTranspose(32, (3, 3), strides=(1, 1), activation='relu', padding='same')(x)

outputs = Conv2DTranspose(1, (3, 3), strides=(1, 1), activation='sigmoid', padding='same')(x)

model = Model(inputs, outputs)

model.compile(optimizer='adam', loss='binary_crossentropy', metrics=['accuracy'])

return model

fcn_model = create_fcn(images. Shape[1:])

步骤 3:训练模型

现在我们用合成数据集来训练模型。

history = fcn_model.fit(images, masks, epochs=10, batch_size=32, validation_split=0.2)

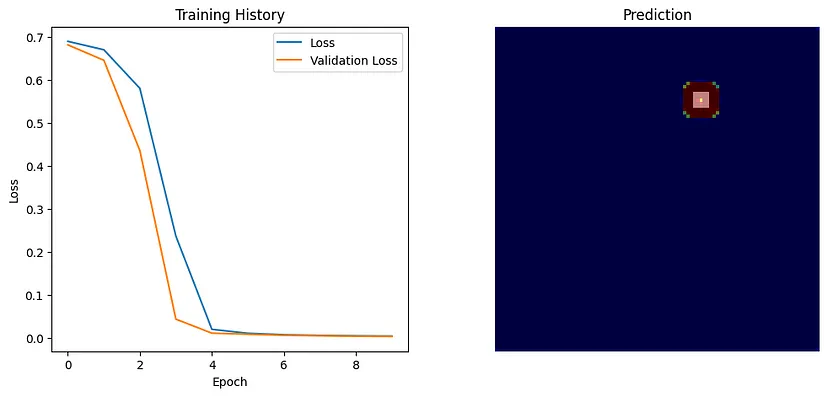

步骤 4:绘制结果图

最后,我们将绘制训练历史记录和一些预测示例。

# Plotting training history

plt.figure(figsize=(12, 5))

plt.subplot(1, 2, 1)

plt.plot(history.history['loss'], label='Loss')

plt.plot(history.history['val_loss'], label='Validation Loss')

plt.title('Training History')

plt.xlabel('Epoch')

plt.ylabel('Loss')

plt.legend()

# Predictions

predictions = fcn_model.predict(images[:5])

plt.subplot(1, 2, 2)

for i in range(5):

plt.imshow(images[i].squeeze(), cmap='gray')

plt.imshow(predictions[i].squeeze(), alpha=0.5, cmap='jet')

plt.title('Prediction')

plt.axis('off')

plt.show()

Epoch 1/10

13/13 [==============================] - 31s 2s/step - loss: 0.6889 - accuracy: 0.9188 - val_loss: 0.6807 - val_accuracy: 0.9975

Epoch 2/10

13/13 [==============================] - 29s 2s/step - loss: 0.6694 - accuracy: 0.9968 - val_loss: 0.6450 - val_accuracy: 0.9967

Epoch 3/10

13/13 [==============================] - 29s 2s/step - loss: 0.5799 - accuracy: 0.9980 - val_loss: 0.4354 - val_accuracy: 0.9987

Epoch 4/10

13/13 [==============================] - 35s 3s/step - loss: 0.2370 - accuracy: 0.9974 - val_loss: 0.0443 - val_accuracy: 0.9966

Epoch 5/10

13/13 [==============================] - 29s 2s/step - loss: 0.0207 - accuracy: 0.9972 - val_loss: 0.0117 - val_accuracy: 0.9981

Epoch 6/10

13/13 [==============================] - 29s 2s/step - loss: 0.0114 - accuracy: 0.9986 - val_loss: 0.0092 - val_accuracy: 0.9987

Epoch 7/10

13/13 [==============================] - 31s 2s/step - loss: 0.0081 - accuracy: 0.9987 - val_loss: 0.0069 - val_accuracy: 0.9984

Epoch 8/10

13/13 [==============================] - 29s 2s/step - loss: 0.0065 - accuracy: 0.9987 - val_loss: 0.0057 - val_accuracy: 0.9987

Epoch 9/10

13/13 [==============================] - 29s 2s/step - loss: 0.0056 - accuracy: 0.9988 - val_loss: 0.0047 - val_accuracy: 0.9989

Epoch 10/10

13/13 [==============================] - 29s 2s/step - loss: 0.0049 - accuracy: 0.9992 - val_loss: 0.0041 - val_accuracy: 0.9991

该代码提供了一个基本框架。请注意,在实际应用中,需要更复杂的数据集和 FCN 架构。此外,调整超参数和加入更多层可以显著提高模型性能。

结论

全卷积网络是图像分析领域的一种变革性方法。它们处理每像素分类任务的能力为各种科学和工业领域开辟了新的途径。随着该领域研究的不断发展,FCN 的潜在应用和改进似乎无穷无尽,预示着计算机视觉和人工智能的新时代即将到来。