Nightshade工具发布,保护作品免遭AI盗用

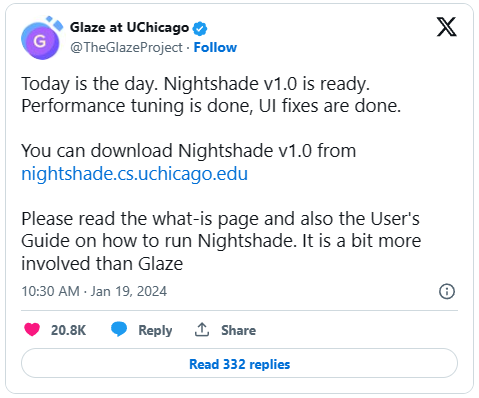

在首次发布数月之后,一款全新的免费软件工具Nightshade终于面世,艺术家们可以通过这款工具 "毒害 "人工智能模型。

该工具由芝加哥大学本-赵(Ben Zhao)教授领导的釉项目(Glaze Project)的计算机科学家开发,其工作原理主要是让人工智能对抗人工智能。它利用流行的开源机器学习框架 PyTorch 来识别给定图像中的内容,然后贴上一个标签,在像素级别上巧妙地改变图像,这样其他人工智能程序就能看到与实际完全不同的东西。

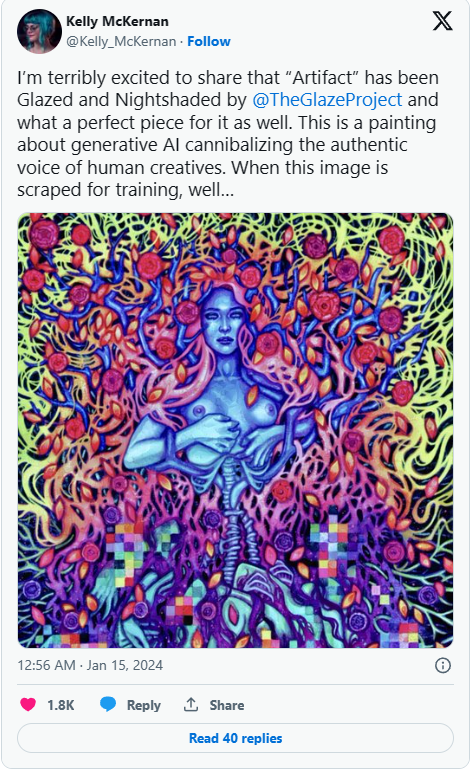

这是该团队推出的第二款此类工具:将近一年前,该团队推出了一款单独的程序 Glaze,旨在按照用户的要求改变数字艺术作品,从而迷惑人工智能训练算法,使其认为图像具有与实际不同的风格(例如与实际不同的颜色和笔触)。

但是,芝加哥团队设计的 Glaze 是一种防御工具,并且仍然建议艺术家在使用 Nightshade 的同时使用它,以防止人工智能模型模仿艺术家的风格,而 Nightshade 则被设计成 "一种进攻工具"。

一个人工智能模型如果最终在许多被Nightshade修改或 "着色 "过的图片上进行训练,那么该模型的所有用户都可能会错误地对物体进行分类,即使是没有被Nightshade着色过的图片也是如此。

该团队进一步解释说:"例如,人眼看到的绿地中一头牛的阴影图像可能基本没有变化,但人工智能模型可能会看到草丛中躺着一个大皮包。

因此,即使用户要求人工智能模型生成一张奶牛的图片,但如果人工智能模型将奶牛的图片阴影处理成钱包的样子,那么它就会开始生成钱包,而不是奶牛。

要求和 Nightshade 的工作原理

想要使用 Nightshade 的艺术家必须有一台内置苹果芯片(M1、M2 或 M3)的 Mac 或一台运行 Windows 10 或 11 的 PC。Windows 文件也能在 PC 的 GPU 上运行,前提是该支持硬件列表中的 Nvidia GPU。

由于对该工具的需求过大,一些用户还反映下载时间过长,有的甚至长达 8 个小时(Mac 和 PC 两个版本的文件大小分别为 255MB 和 2.6GB)。

用户还必须同意 Glaze/Nightshade 团队的最终用户许可协议(EULA),该协议规定用户在自己控制的机器上使用该工具,不得修改底层源代码,也不得 "出于任何商业目的复制、拷贝、分发、转售或以其他方式使用本软件"。

Nightshade v1.0 "将图像转化为'毒药'样本,这样未经同意对其进行训练的[人工智能]模型就会看到它们的模型学习到偏离预期规范的不可预测行为,例如,要求获得在太空中飞行的奶牛图像的提示可能会得到在太空中漂浮的手提包图像",开发团队在其网站上发布的一篇博文中指出。

也就是说,通过使用 Nightshade v 1.0 对图像进行 "遮光",图像就会在开源人工智能库的帮助下转变成一个新的版本--理想的情况是转变得足够巧妙,以至于人眼看起来不会有太大的不同,但对于在此基础上进行训练的任何人工智能模型来说,它似乎包含了完全不同的主题。

此外,该工具还能抵御用户或观众可能对图像进行的大多数典型转换和修改。正如团队所解释的那样:

"你可以裁剪、重新采样、压缩、平滑像素或添加噪点,但毒药的效果依然存在。你可以截图,甚至拍摄显示器上显示的图像,阴影效果依然存在。同样,这是因为它不是水印或隐藏信息(隐写术)"。

掌声与谴责

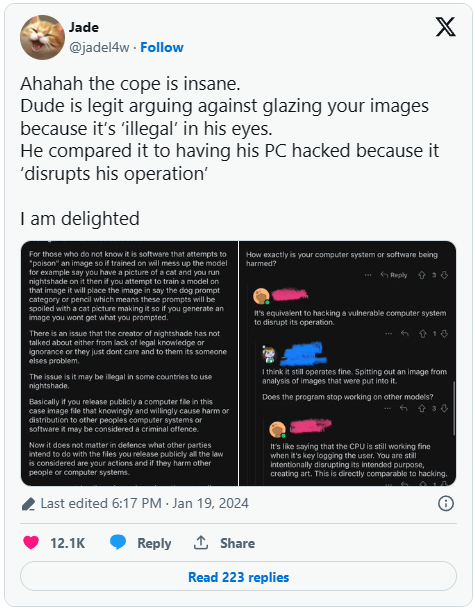

虽然一些艺术家已经下载了Nightshade v1.0,并已经开始使用,但也有一些网络用户对此表示不满,认为这无异于对人工智能模型和公司的网络攻击。

Glaze/Nightshade团队则否认自己在寻求破坏性目的,他们写道:"Nightshade的目标不是破坏模型,而是增加在未经授权的数据上进行训练的成本,从而使向创作者授权图片成为一种可行的替代方案。

换句话说,创作者的目的是让人工智能模型开发者必须向艺术家付费,才能使用他们提供的未经破坏的数据进行训练。

该团队进一步解释了他们的最终目标:

"通过负责任地使用,Nightshade 可以帮助阻止那些无视版权、退出列表和 do-not-scrape/robots.txt 指令的模特培训师。它并不依赖于模型训练者的善意,而是对未经授权的每项数据抓取和训练收取少量增量费用"。

基本上就是:让人工智能模型制作者付出更高的代价,让他们三思而后行,从而让他们考虑与人类艺术家签订许可协议,将其作为更可行的替代方案。

当然,Nightshade 并不能逆转时间的流逝:在被该工具着色之前,任何被抓取的艺术作品仍被用于训练人工智能模型,现在对它们着色可能会影响模型的有效性,但前提是这些图像被重新抓取并再次用于训练更新版的人工智能图像生成器模型。

在技术层面上,也没有任何规定可以阻止他人使用 Nightshade 对人工智能生成的作品或非自己创作的作品进行着色,这就为潜在的滥用打开了方便之门。