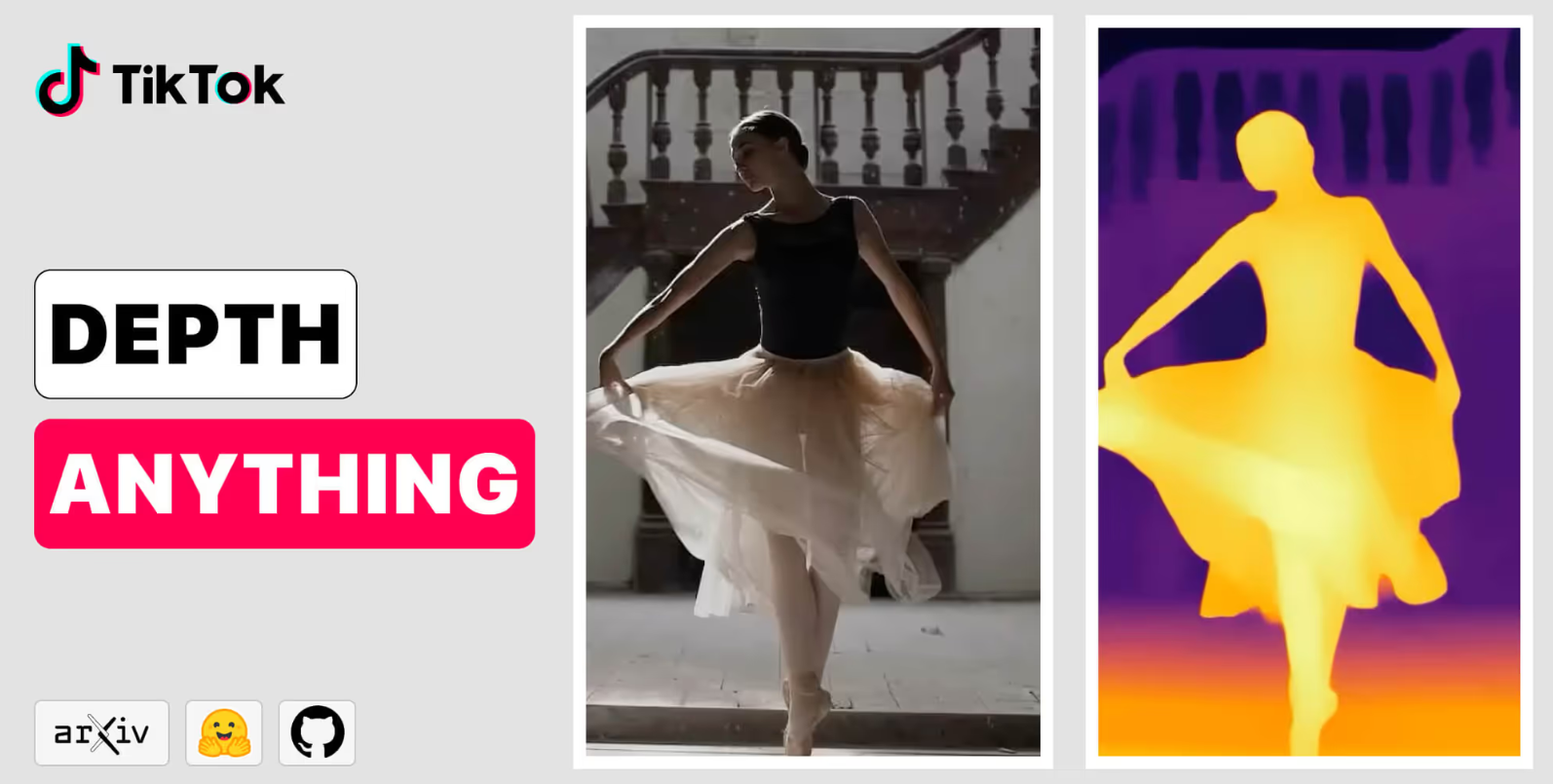

TikTok的Depth Anything模型为基于图像的稳健深度估计设定了新标准

2024年01月24日 由 neo 发表

463

0

来自TikTok、香港大学和浙江实验室的研究人员分享了一项新的研究,该研究在各种数据集和度量标准上为单目深度估计(MDE)设定了令人印象深刻的基准。该研究名为“Depth Anything”,标志着人工智能驱动的深度感知方面取得了显著进展,特别是在理解和解释单张图像中物体的深度方面。

“Depth Anything”的核心在于它在一个巨大的数据集上进行训练:150万张带有标签的图像,以及超过6200万张未标记的图像。这个庞大的训练集是模型熟练度的关键。与主要依赖较小的标记数据集的传统MDE模型不同,“Depth Anything”利用了大量未标记的数据。这种方法显著扩大了数据覆盖范围,从而减少了泛化误差——这是人工智能模型中常见的挑战。

在深度估计方面的新基准

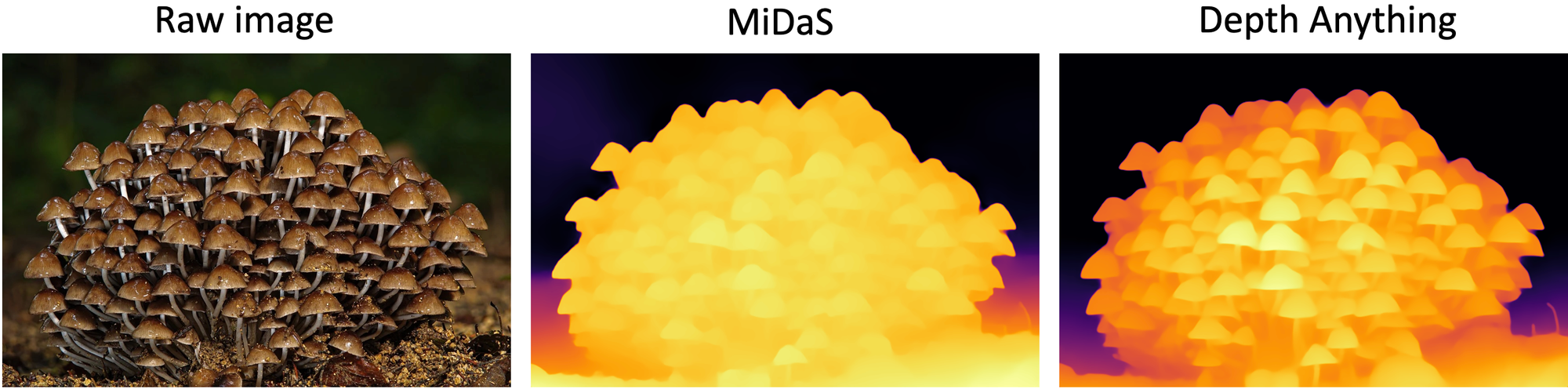

“Depth Anything”有何与众不同之处?首先,它实现了零次射击相对深度估计,与MiDaS v3.1(BEiTL-512)相比具有卓越的性能。这意味着它可以估算从未见过图像中的深度,而无需进行任何额外的训练。此外,它在零次射击度量深度估计方面超越了ZoeDepth,表明它能够评估物体与摄像头的实际距离。

当在NYUv2和KITTI的度量深度数据上进行微调时,“Depth Anything”模型在这些广泛使用的基准上也取得了新的最佳结果。这种强大的泛化与微调性能的结合使“Depth Anything”成为单目深度估计研究的新基石。

文章来源:https://www.maginative.com/article/tiktoks-depth-anything-models-sets-new-standards-for-robust-image-based-depth-estimation/

欢迎关注ATYUN官方公众号

商务合作及内容投稿请联系邮箱:bd@atyun.com

热门企业

热门职位

写评论取消

回复取消