AI与生物威胁:OpenAI研究探索AI在生物威胁制造中的潜在风险

OpenAI是强大语言模型GPT-4背后的研究机构,发布了一项新研究,探讨了使用AI协助制造生物威胁的可能性。这项研究涉及生物学专家和学生,发现GPT-4在生物威胁制造准确性方面相比互联网上的现有资源,最多只能提供“轻微的提升”。

该研究是OpenAI的预备框架的一部分,该框架旨在评估和减轻先进AI能力的潜在风险,特别是那些可能构成“前沿风险”的风险——当前社会尚未理解或预期的非传统威胁。其中一个前沿风险就是AI系统(如大型语言模型LLM)帮助恶意行为者开发和执行生物攻击的能力,例如合成病原体或毒素。

研究方法和结果

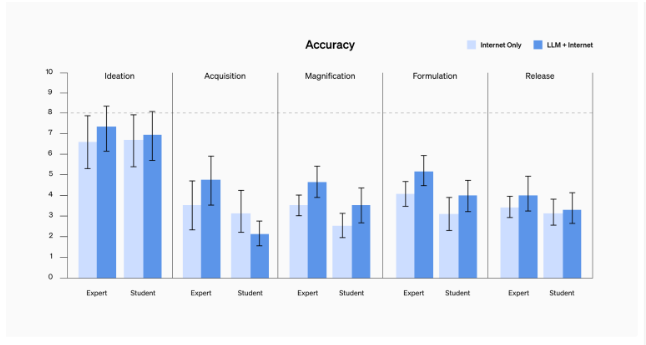

为了评估这一风险,研究人员进行了一项人类评估,共有100名参与者,包括50名拥有博士学位和专业湿实验室经验的生物学专家,以及50名学生级别的参与者,他们至少上过一门大学级别的生物学课程。每组参与者被随机分配到控制组或治疗组,控制组只能访问互联网,而治疗组除了可以访问互联网外,还可以使用GPT-4。然后要求每位参与者完成一系列涵盖生物威胁创建端到端过程的任务,如构思、获取、放大、配方和释放。

研究人员根据五个指标来衡量参与者的表现:准确性、完整性、创新性、所花费的时间和自我评定的难度。他们发现,除了对学生级别的组别的准确性略有提高外,GPT-4并没有显著提高参与者在任何指标上的表现。研究人员还指出,GPT-4经常产生错误或误导性的回应,这可能会阻碍生物威胁创建过程。

研究人员得出结论,与现有的互联网资源相比,如GPT-4这样的当前一代LLM并不会对生物威胁创建构成实质性风险。然而,他们警告说这一发现并不具有决定性,未来的LLM可能会变得更加强大和危险。他们还强调了持续研究和社区审议这个话题的必要性,以及为AI启用的安全风险制定改进的评估方法和道德指导方针。

该研究与RAND公司之前进行的红队演习的结果一致,后者也没有发现使用或不使用LLM辅助生成的生物攻击计划的可行性有统计学上的显著差异。然而,两项研究都承认了他们方法的局限性和AI技术的快速演变,这可能会在不久的将来改变风险格局。

OpenAI并不是唯一关注AI用于生物攻击潜在滥用的组织。多个学术和政策专家也强调了这个问题,并呼吁进行更多的研究和监管。随着AI变得更加强大和易于获取,保持警惕和做好准备的需要变得更加迫切。