阿里大模型开源新篇章:Qwen1.5版本盛大发布,六种尺寸任君选择

阿里大模型再次引领开源潮流,发布了全新Qwen1.5版本,一次性放出六种尺寸供开发者选择。其中,最大的Qwen1.5-72B-Chat模型在MT-Bench和Alpaca-Eval v2上的表现令人瞩目,不仅超越了Claude-2.1和GPT-3.5-Turbo-0613,更在部分任务中得分超越了前几个版本的GPT-4。

这一消息引发了全球开发者的热议,许多人纷纷前来祝贺,并对0.5B的迷你版表示出浓厚的兴趣。同时,大家也期待着多模态大模型Qwen-VL-Max的开源。

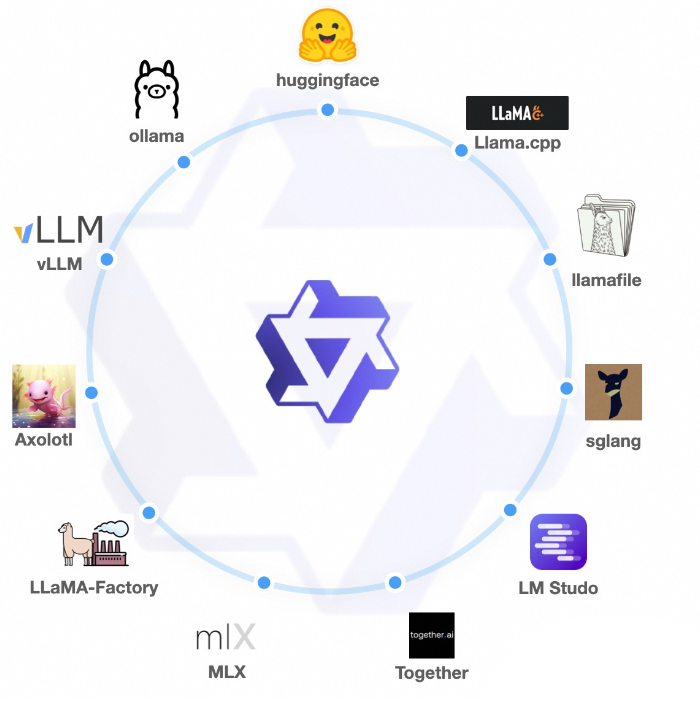

值得一提的是,Qwen1.5不仅提供了丰富的模型选择,还实现了与主流框架的深度融合。目前,Qwen1.5的代码已经合并到Hugging Face transformers中,无需trust_remote_code即可使用。此外,Qwen1.5还与vLLM、SGLang、AutoAWQ、AutoGPTQ、Axolotl、LLaMA-Factory以及llama.cpp等主流第三方框架进行了合作,实现了从微调、部署、量化到本地推理的一站式服务。

Qwen1.5系列的强大性能也是其一大亮点。在MMLU(5-shot)、C-Eval、Humaneval、GS8K、BBH等基准测试中,Qwen1.5-72B的得分已经超越了GPT-4。在长上下文支持方面,全系列模型也展现出了出色的能力,尤其是Chat模型,如Qwen1.5-7B-Chat在小模型中的表现与GPT-3.5相当。而Qwen1.5-72B-Chat的性能则明显优于GPT3.5-turbo-16k,略微落后于GPT4-32k。

此外,Qwen1.5在代码执行方面也有不俗的表现。虽然72B聊天模型在数学和可视化方面与GPT-4仍有一定的差距,但其代码可执行率却超过了GPT-4。阿里团队表示,他们将在未来的版本中继续优化这一功能。

除了性能的提升,Qwen1.5还在功能和统一性方面进行了升级。全系列模型统一支持至少32k的最大长度,多语言能力得到了全面提升,并提供了更丰富的多语言评测。同时,全系列模型还统一支持system prompt和强链接外部系统能力(agent/RAG/Tool-use/Code-interpreter),为开发者提供了更加便捷和高效的开发体验。