OpenAI发布创新型AI模型Sora:将文本转化为电影级视频

2024年02月16日 由 neo 发表

464

0

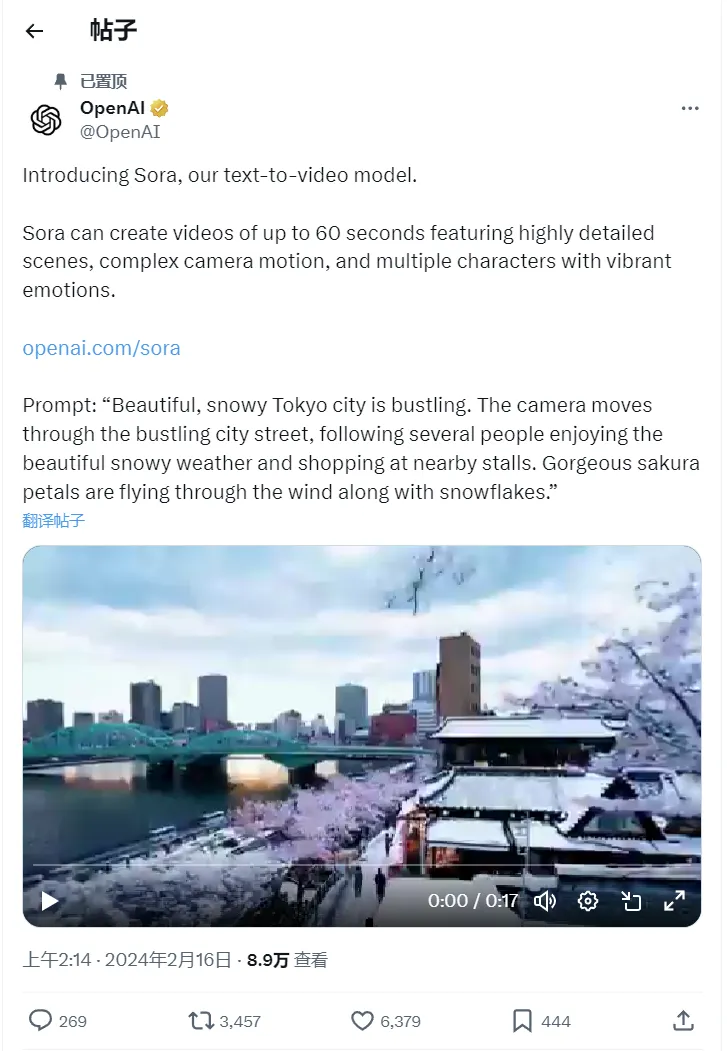

OpenAI今日揭晓了一项重大创新——Sora,这是一种革命性的生成型AI模型,具备将文本内容转化为高质量视频的能力。用户只需提供简短的描述、详细的叙述或一张静态图片,Sora便能生成分辨率高达1080p的生动视频,其中包含了丰富的角色、多样化的动作以及精细的背景细节。

更为引人注目的是,Sora还具备对现有视频片段进行“扩展”的能力,即能够智能地填补视频中的缺失部分。OpenAI在官方博客中自豪地表示:“Sora对语言的理解深刻,能够准确解读提示,并生成情感鲜明、引人入胜的角色。这个模型不仅理解用户的要求,还能将这些要求在物理世界中实现。”

尽管OpenAI对Sora的描述充满赞誉,但从模型中挑选的样本确实令人印象深刻。与其他文本到视频的技术相比,Sora生成的视频在风格、长度和连贯性方面都表现出色。这些视频最长可达一分钟,远远超越了大多数同类模型。同时,它们在很大程度上保持了合理的连贯性,减少了AI常见的怪异现象,如物体以非物理方式移动等。

然而,OpenAI也坦诚地承认了Sora的不完美之处。在某些复杂场景的物理模拟、特定因果关系的理解以及空间细节的准确描述等方面,Sora仍面临挑战。例如,人物咬饼干后饼干上可能没有咬痕,或者左右方向可能混淆等。OpenAI将Sora定位为一个研究预览版,并强调了防止滥用模型的重要性。

为了确保Sora的安全使用,OpenAI正在与专家合作探测模型的漏洞,并构建工具来检测视频是否由Sora生成。如果决定将Sora推向公众市场,该公司承诺将确保生成的输出中包含来源元数据,并与全球政策制定者、教育者和艺术家合作,共同探索这项新技术的积极用例。OpenAI坚信,从实际使用中学习是创建和发布越来越安全的AI系统的关键。

文章来源:https://techcrunch.com/2024/02/15/openais-newest-model-can-generate-videos-and-they-look-decent/

欢迎关注ATYUN官方公众号

商务合作及内容投稿请联系邮箱:bd@atyun.com

热门企业

热门职位

写评论取消

回复取消