谷歌发布全球最强开源大模型Gemma,性能超越130亿的Llama

谷歌宣布推出两款全新的人工智能模型——Gemma 2B和Gemma 7B,并分别为这两款模型发布了“预训练和指令调优的变体”。在新闻发布会上,谷歌DeepMind的负责人Tris Warkentin表示,这些新模型是“一系列最新的小型模型”,它们将允许开发者在开放领域中使用基于Gemini研究和技术的工具进行研究和AI开发。

为了确保AI应用的安全性,谷歌还发布了一个“负责任的生成性AI工具包”,为开发者提供指导和工具,以“使用Gemma创建更安全的AI应用程序”。

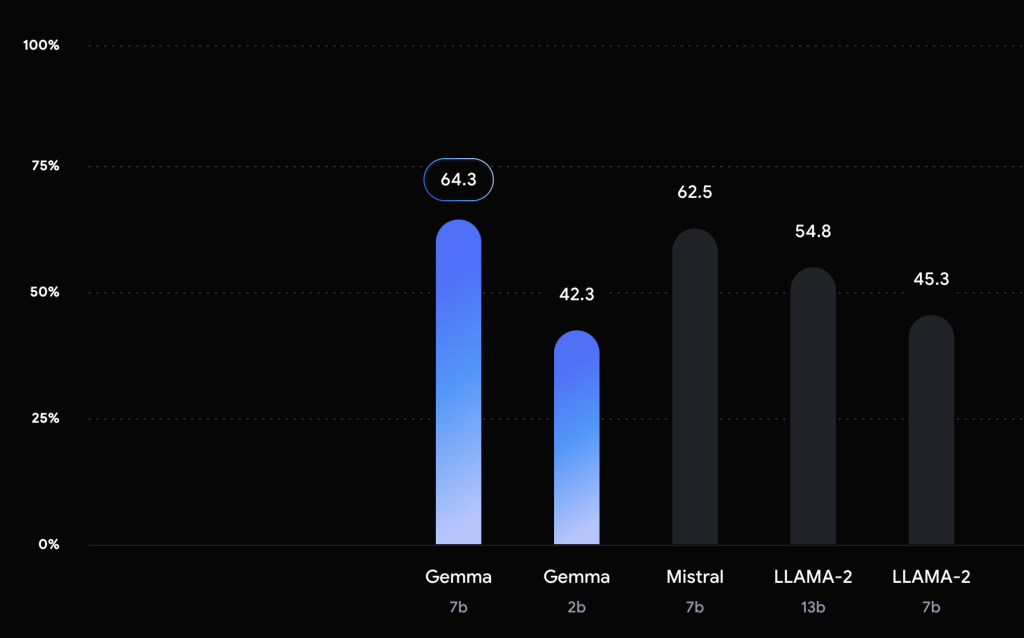

据谷歌透露,Gemma在基准测试中已超越Meta的Llama 2和Mistral模型。Warkentin指出,他们正在与Nvidia和Hugging Face合作,因此这些基准测试将自发布之日起就被纳入开放LLM排行榜。

然而,当被问及“开放”这一术语的具体含义时,谷歌的开发者X和DevRel副总裁兼总经理Jeanine Banks解释说,这并不意味着开源。她指出,现在行业中普遍使用的“开放”术语通常指的是开放权重模型,这意味着开发者和研究人员可以广泛地访问、自定义和微调模型。但她强调,使用条款会根据模型自己的特定使用条款而有所不同。

在发布会后期,有人询问Gemma模型是否可用于商业用途。Banks回应称,谷歌为Gemma提供了一个“商业许可的许可证”,这意味着没有组织类型、组织规模或产品用户数量的限制。她补充说,谷歌将监控开发者和研究人员如何使用这些工具,以确保它们不被用于促进伤害。

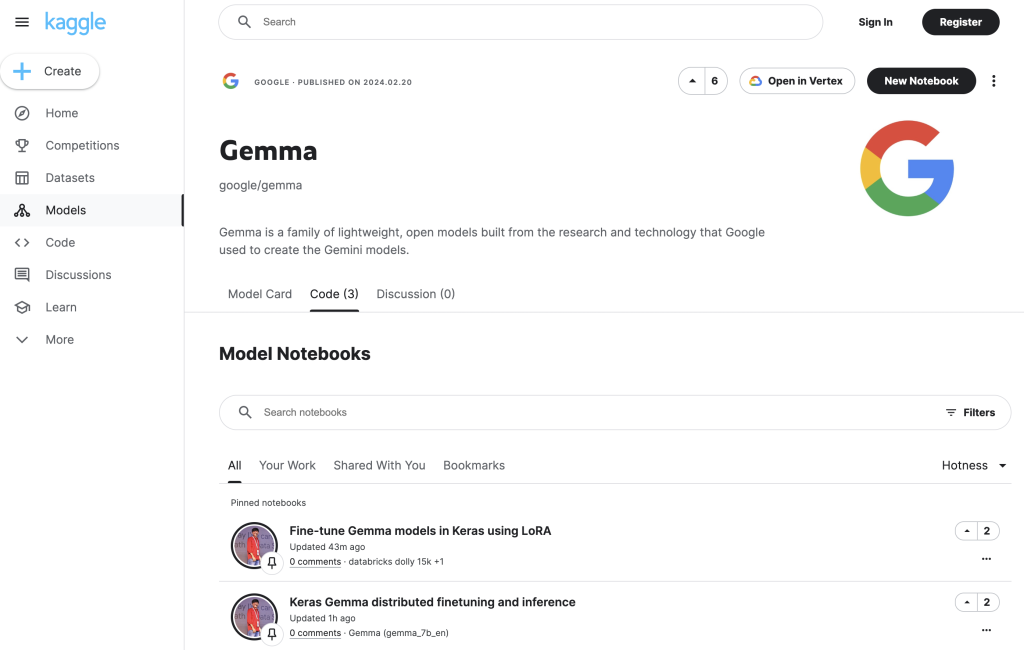

此外,谷歌还将通过原生Keras 3.0为流行的框架如JAX、PyTorch和TensorFlow提供支持。开发者还可以利用随时可用的Colab和Kaggle笔记本,以及与Hugging Face、MaxText和NVIDIA NeMo等工具的集成。值得一提的是,这些预训练和指令调优的Gemma模型可以在笔记本电脑、工作站或谷歌云上运行,部署选项包括Vertex AI和谷歌Kubernetes Engine(GKE)。

当被问及这些小型模型可能的应用场景时,Warkentin表示,这些模型具有广泛的应用。他指出,从开放模型的角度来看,7B大小适用于文本生成和理解应用。他还补充说,这类模型的“生成质量”在过去一年中“显著提高”,因此许多应用用例不再需要使用大型语言模型(LLM)。

最后,Warkentin强调,这些模型为开发AI应用程序提供了新的方式,包括在本地开发者桌面或笔记本电脑上运行推理和进行训练的能力。他说:“这完全开启了我们非常兴奋的开发AI应用程序的新方式,您可以使用您的RTX GPU或在GCP的单个主机上,也可以使用云GPU。