【指南】通过递归特征消除增强机器学习模型

数据集介绍

数据集的维度往往令人难以承受,其中包含数百甚至数千个特征。并非所有这些特征都能为手头的预测任务做出同样的贡献;有些特征可能不相关或多余,从而导致计算成本增加,并可能因过度拟合而降低模型性能。这就是递归特征消除等特征选择方法发挥作用的地方,它提供了一种减少特征空间以提高模型准确性和效率的系统方法。递归特征消除(RFE)是机器学习领域使用的一种功能强大的特征选择方法,通过消除冗余或不相关的特征来提高预测模型的性能。本文将深入探讨 RFE 的方法论、应用、优势和局限性,深入探讨其在数据科学和机器学习领域的意义。

RFE方法论

递归特征消除是一个迭代过程,它根据特征的重要性对其进行排序,并系统地消除最不重要的特征,从而找到用于构建模型的最佳特征子集。该过程包括以下步骤:

- 模型训练: RFE 首先在整个特征集上训练一个模型。

- 特征排序: 模型训练完成后,根据特定标准对每个特征进行排序,通常是回归模型中的系数绝对值或基于树的模型中的特征重要度。

- 剔除最不重要的特征: 从特征集中删除被认为最不重要的特征。

- 重复流程: 在减少的特征集上重复步骤 1 至 3,直到达到预定的特征数量,或进一步剔除不再能提高模型的性能。

根据消除过程中使用的模型,结果是被认为对预测最有用的特征子集。

RFE 的应用

RFE 用途广泛,可应用于对预测建模至关重要的各个领域。例如,在生物信息学领域,RFE 可用于识别信息量最大的遗传标记,以进行疾病预测。在金融领域,它有助于选择对股票价格或信用评分影响最大的因素。该方法还广泛应用于客户流失预测、图像识别以及任何需要在不牺牲性能的前提下降低模型复杂度的场景。

RFE 的优势

- 模型性能: 通过消除无关特征,RFE 可以提高预测模型的性能。

- 模型可解释性: 减少特征数量可使模型更简单、更易于解释。

- 计算效率: 更少的特征意味着更低的计算复杂度,这在处理大型数据集时尤其有利。

RFE 的局限性

- 计算成本: RFE 的迭代特性可能会导致计算成本较高,尤其是在处理超大数据集和复杂模型时。

- 模型依赖性: RFE 的有效性取决于用于特征排序的模型。不同的模型可能会产生不同的重要性得分,从而导致所选特征的不同。

- 不考虑特征相关性: RFE 不考虑特征之间的相关性。因此,它可能会保留高度相关的特征,而这些特征并不能为模型增加独特的信息。

代码

为了用一个完整的 Python 示例演示递归特征消除(RFE),我将使用 sklearn.datasets.make_classification 创建一个合成数据集,将 RFE 应用于逻辑回归模型,并可视化性能指标和特征选择过程。本示例将包括生成数据集、使用 RFE 拟合模型、评估模型性能,以及绘制特征重要性和模型准确性的曲线图。

首先,确保已安装必要的库。你需要 scikit-learn、matplotlib 和 numpy。如果没有安装,可以使用 pip 安装:

pip install scikit-learn matplotlib numpy现在,让我们继续编写代码:

import numpy as np

import matplotlib.pyplot as plt

from sklearn.datasets import make_classification

from sklearn.linear_model import LogisticRegression

from sklearn.feature_selection import RFE

from sklearn.model_selection import train_test_split

from sklearn.metrics import accuracy_score

# Generate a synthetic dataset

X, y = make_classification(n_samples=1000, n_features=25, n_informative=5, n_redundant=2, n_classes=2, random_state=42)

# Split the dataset into training and test sets

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.3, random_state=42)

# Initialize the model

model = LogisticRegression(max_iter=500)

# Initialize RFE with the logistic regression model and desired number of features

# Here, we will select 5 features as an example

rfe = RFE(estimator=model, n_features_to_select=5, step=1)

# Fit RFE

rfe.fit(X_train, y_train)

# Make predictions

y_pred = rfe.predict(X_test)

# Calculate accuracy

accuracy = accuracy_score(y_test, y_pred)

print(f'Accuracy: {accuracy:.2f}')

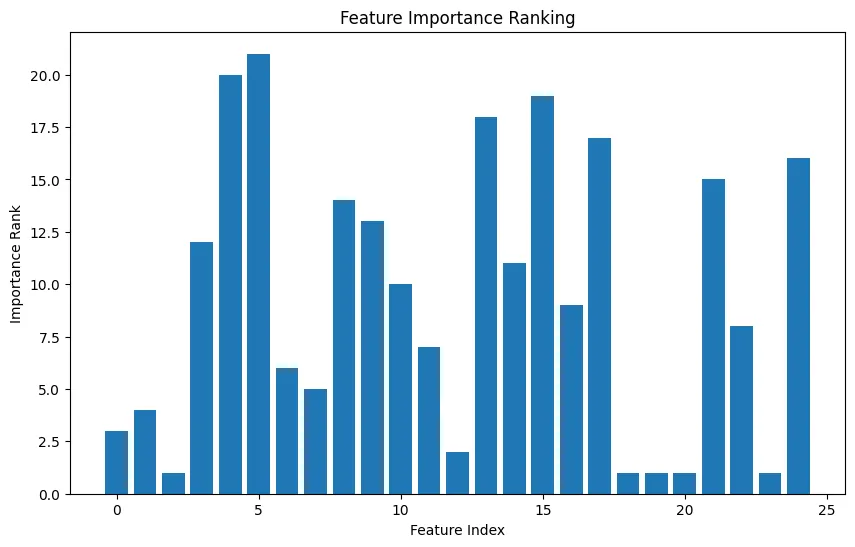

# Plot the ranking of features

plt.figure(figsize=(10, 6))

plt.title("Feature Importance Ranking")

ranking = rfe.ranking_

plt.bar(range(X.shape[1]), ranking)

plt.xlabel('Feature Index')

plt.ylabel('Importance Rank')

plt.show()

# Optionally, show which features were selected

selected_features_indices = np.where(rfe.support_)[0]

print(f'Selected features indices: {selected_features_indices}')

该脚本具有以下功能:

- 生成一个合成数据集: 创建一个包含 25 个特征的数据集,其中 5 个是信息特征,2 个是冗余特征。

- 分割数据集: 将数据集分为训练集和测试集。

- 初始化和拟合 RFE:使用逻辑回归模型进行特征排序和选择,指定选择 5 个特征。

- 评估模型: 计算并打印测试集上模型的准确度。

- 绘制特征重要性图: 根据 RFE 确定的特征在预测中的重要性,创建显示特征排序的条形图。

- 识别选定的特征: 打印 RFE 选定的最重要特征的指数。

Accuracy: 0.83

Selected features indices: [ 2 18 19 20 23]本示例全面介绍了如何在 Python 中应用 RFE,包括数据准备、模型评估和特征重要性解释。

结论

递归特征消除是一种有效的特征选择方法,它可以通过关注最相关的特征来显著提高机器学习模型的性能和可解释性。尽管存在计算成本和模型依赖性等局限性,但应用递归特征消除法在提高模型准确性和效率方面的优势是不可否认的。随着机器学习领域的不断发展,RFE 等技术仍将是数据科学家从数据中获取最大价值不可或缺的工具。